Supervisão humana da IA

A supervisão humana em sistemas de IA é um requisito de conformidade:

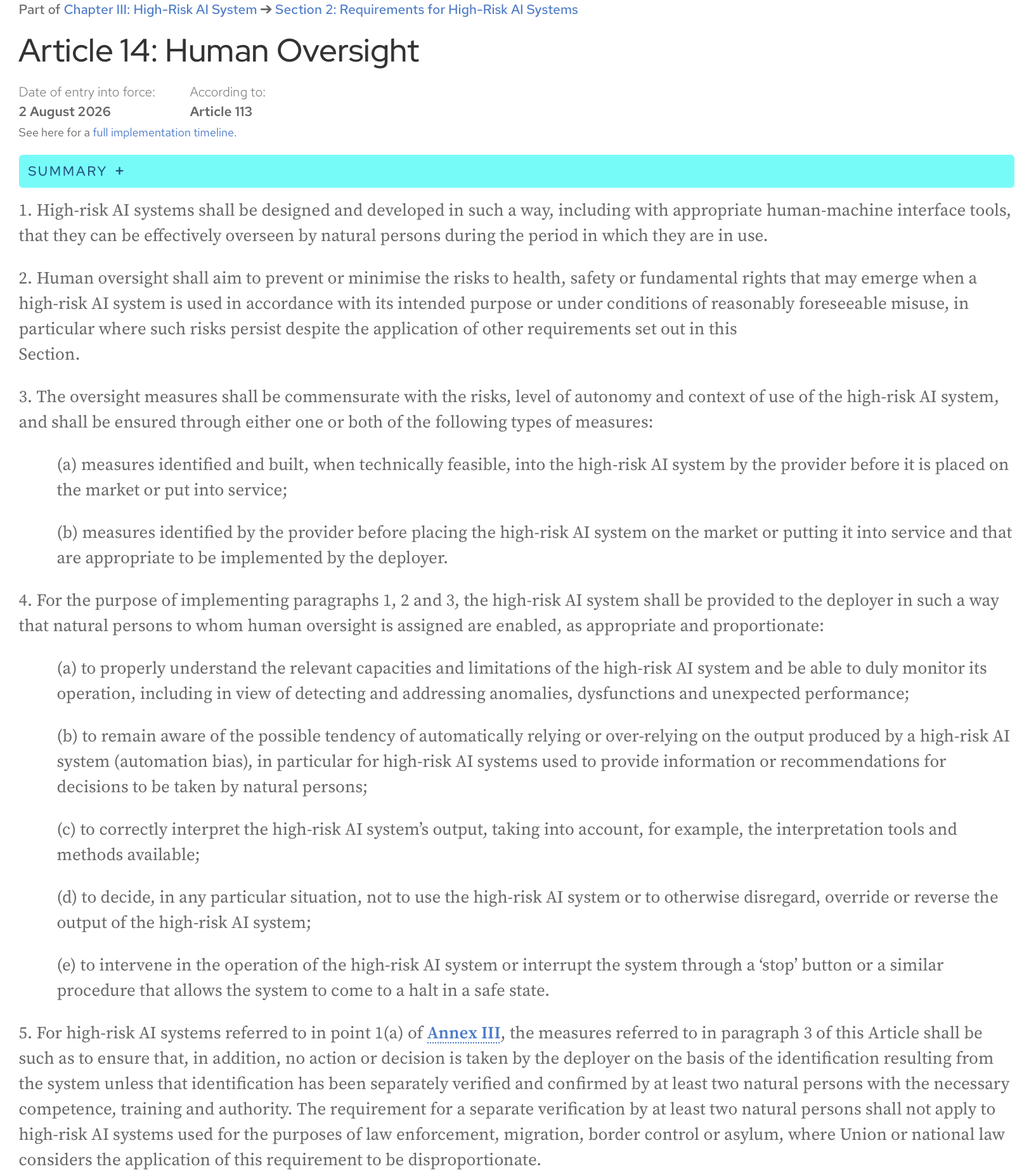

Lei da IA, Artigo 14: Os sistemas de IA de alto risco devem ser concebidos e desenvolvidos de tal forma, incluindo com ferramentas de interface homem-máquina adequadas, que possam ser eficazmente supervisionados por pessoas singulares durante o período em que estão a ser utilizados.

Aqui está o texto completo do artigo da página oficial da Lei da IA:

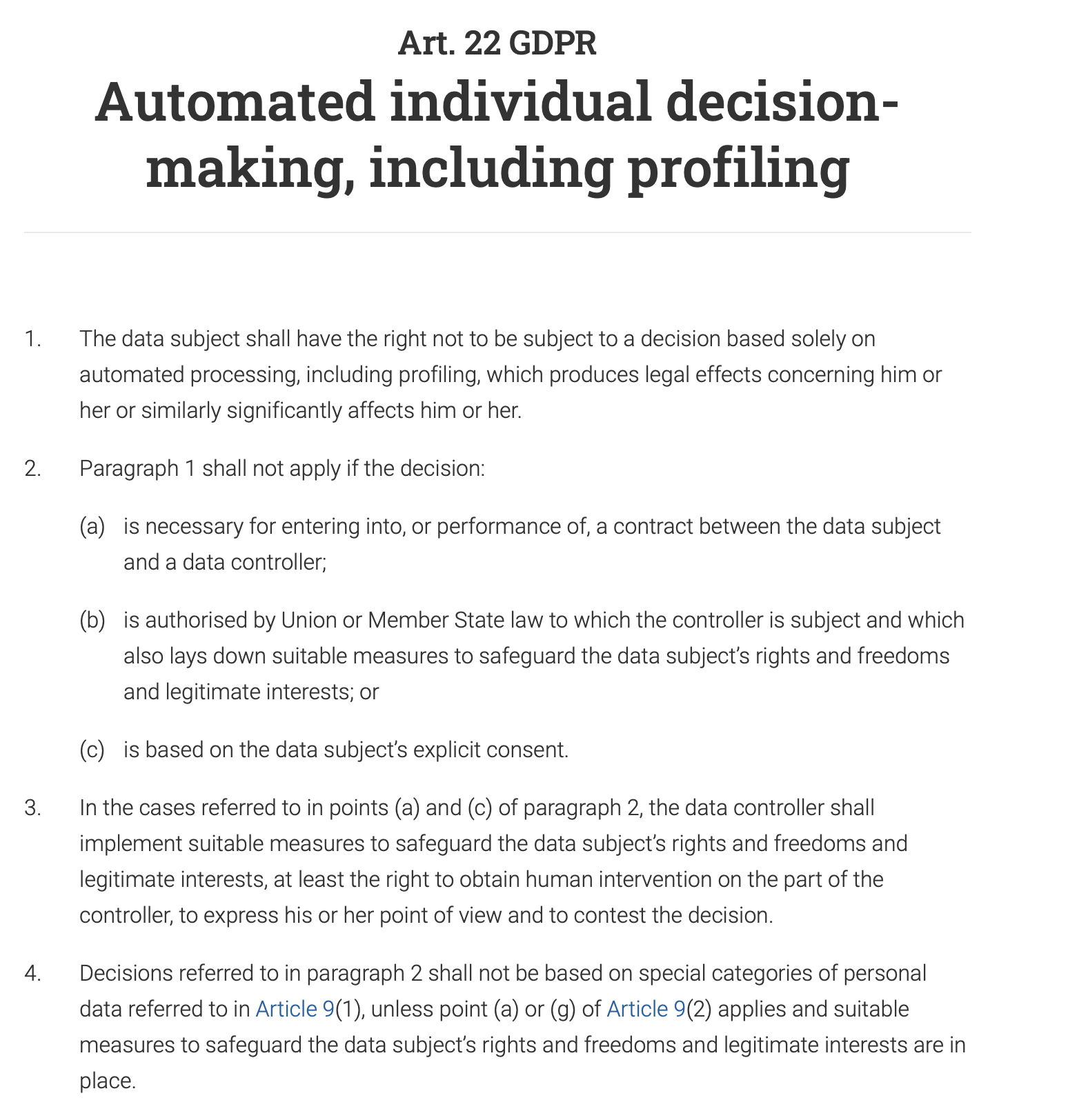

O Artigo 22 do RGPD confere explicitamente aos indivíduos o direito de “não ficarem sujeitos a uma decisão tomada exclusivamente com base no tratamento automatizado, incluindo a definição de perfis, que produza efeitos jurídicos na sua esfera jurídica ou que os afete significativamente de forma similar”. Isto significa que, para qualquer sistema de tomada de decisão automatizado que tenha um grande impacto num indivíduo (por exemplo, negar um pedido de empréstimo, uma oferta de emprego ou um benefício público), um ser humano deve estar envolvido no processo para rever e validar a decisão. O indivíduo também tem o direito de contestar a decisão automatizada e obter intervenção humana.

E, como seria de esperar, a supervisão humana é um requisito fundamental tanto na ISO 42001 como no Quadro de Gestão de Riscos de IA do NIST (AI RMF). Ambos os quadros, embora diferentes na sua abordagem, enfatizam a necessidade de intervenção humana para garantir o uso responsável e ético dos sistemas de IA.

Esta publicação é a minha interpretação do artigo que foi apresentado na recente sessão do Chat mensal sobre Adoção e Garantia de IA da Data61 - “Conceber uma supervisão humana significativa na IA” (https://www.researchgate.net/publication/395540553_Designing_Meaningful_Human_Oversight_in_AI).

(a citação completa do artigo: Zhu, Liming & Lu, Qinghua & Ding, Ming & Lee, Sunny & Wang, Chen & Data, & Csiro, & Australia,. (2025). Designing Meaningful Human Oversight in AI. 10.13140/RG.2.2.16624.11528)

O artigo discute o problema da abordagem atual à supervisão humana e apresenta dicas práticas para os desenvolvedores de sistemas de IA.

O que é a supervisão humana e como é feita?

O problema da supervisão humana é que ela é mal definida. Mas, na minha opinião, o que torna tudo mais complicado é o nosso viés de automação natural - uma tendência para confiar no resultado de uma máquina em detrimento do nosso próprio julgamento. Quantas vezes já seguiu cegamente um GPS para uma estrada inexistente?

Como resultado, ou aprovamos o resultado do sistema sem o compreendermos devidamente (“carimbamos”).

Por exemplo, o sistema de IA de um banco pode sinalizar a sua transação como de alto risco, e um analista humano, encarregado de rever milhares de alertas deste tipo diariamente, aprova automaticamente a decisão da IA e congela a sua conta.

O cenário oposto também é comum: restringimos tanto o sistema que, em vez de lhe darmos um objetivo de alto nível e alguma liberdade para explorar compromissos e encontrar soluções intermédias, tentamos pré-programar cada ação que ele deve tomar e, assim, reduzi-lo a um sistema de automação baseado em regras.

Uma empresa quer que um chatbot de IA trate das questões dos clientes. Em vez de lhe dar um objetivo de alto nível como “resolver o problema do cliente de forma educada e eficiente”, você programa-o com um guião rígido que dita que, se um cliente perguntar: “Como devolvo um produto?”, o bot deve responder com um link para a página de devoluções e depois perguntar: “Isto respondeu à sua pergunta?”. Ele não consegue lidar com perguntas com nuances como: “Perdi o meu recibo, ainda posso devolver isto?”, porque as regras não cobrem esse cenário específico. O chatbot perde a sua qualidade de agente e torna-se uma árvore de decisão básica e frustrante.

O artigo argumenta que nenhum destes cenários é o ideal, e que a agência humana e a agência da IA não são um jogo de soma zero. A colaboração dos dois produz melhores resultados do que qualquer um deles poderia alcançar sozinho.

Como pode a supervisão humana ser concebida para permitir esta colaboração?

Dois tipos de agência

Comecemos pela definição de agência: é a capacidade de agir e fazer as coisas acontecerem por si próprio, para atingir um objetivo.

O artigo sugere a distinção entre os dois tipos de agência:

- Agência operativa (a capacidade da IA para gerar soluções)

Por exemplo, um sistema de IA médico gera um diagnóstico.

- Agência avaliativa (a capacidade do ser humano para compreender, julgar, verificar a solução da IA e, quando necessário, orientar os seus resultados ou substituí-los por soluções alternativas)

Um médico não replica o processo de diagnóstico. Não é trabalho de um médico refazer o trabalho da IA ou ser mais esperto que a máquina. Em vez disso, o seu papel é avaliar o diagnóstico da IA. O médico pergunta: “Isto faz sentido? O raciocínio da IA é consistente com o que um especialista humano responsável faria?”. Eles verificam a consistência. Eles reveem a justificação da IA, que pode ser uma lista de sintomas chave e uma citação da literatura médica. O médico verifica se este raciocínio se alinha com a sua própria formação e com as normas médicas. Eles também adicionam o contexto humano: sabendo que o tratamento para uma doença rara é uma terapia dispendiosa, dolorosa e intensiva de um ano, eles consideram as preferências do paciente, a sua situação financeira e se estão dispostos a comprometer-se com um regime tão difícil. Finalmente, eles ponderam os benefícios potenciais do tratamento contra o seu fardo significativo e decidem se é o curso de ação mais apropriado e ético, mesmo que o diagnóstico da IA esteja tecnicamente correto.

É difícil discordar da opinião dos autores de que “avaliar” é uma palavra melhor do que “supervisionar”, porque enfatiza o papel humano como ativo e crítico, em vez de meramente supervisor ou simbólico.

A agência avaliativa proporciona responsabilidade

Se algo correr mal, um ser humano é o responsável final. A IA não pode ser responsabilizada num tribunal; a pessoa que avaliou o seu resultado pode. Além disso, o julgamento do ser humano ancora as ações da IA a normas profissionais, éticas e sociais que a própria IA não consegue compreender. A IA pode encontrar o caminho mais rápido, mas só o ser humano pode decidir se esse caminho é o mais ético ou seguro. Estes dois benefícios são fundamentais para uma IA responsável e fidedigna.

Fidelidade do raciocínio interno vs. externo

Como podemos avaliar os resultados de um sistema se ainda não conseguimos compreender totalmente o complexo funcionamento interno dos modelos de IA modernos? Cada ativação da rede neural, cada ajuste de parâmetro, ou como o conhecimento aprendido do modelo (como o conceito de um “gato”) é distribuído e armazenado dentro dos seus milhões ou milhares de milhões de parâmetros (a memória do modelo) - tentar compreender este circuito algorítmico não é viável nesta fase do desenvolvimento da IA, e mesmo que fosse, seria como olhar para as decisões que um programa de xadrez de computador toma através do prisma dos cálculos individuais que faz - demasiados detalhes, demasiado complexo e não muito útil para avaliar realmente as decisões.

Em vez disso, podemos conceber sistemas de tal forma que forneçam explicações que façam sentido para um ser humano - explicações baseadas no que o artigo designa por “fidelidade do raciocínio externo” ou “plausibilidade”. Um programa de xadrez diria: “Escolhi este movimento para controlar o centro do tabuleiro e pressionar o cavalo do adversário”, e seríamos capazes de avaliar esta decisão porque a sua explicação se alinha com os princípios estabelecidos do xadrez e com o julgamento humano.

Agora, como concebemos um sistema para fornecer tais pistas que possamos avaliar e, se necessário, contestar?

Assimetria resolver-verificar

O artigo introduz um conceito útil de assimetria resolver-verificar: a dificuldade de criar uma solução (resolver) e a dificuldade de verificar essa solução (verificar) muitas vezes não são iguais. Este é o caso tanto no momento da conceção como no momento da execução, e compreendê-lo ajuda a criar um processo de supervisão humana eficaz.

Na fase de conceção, a tarefa de “resolver” é o esforço necessário para construir o sistema de IA:

- criar a arquitetura do sistema

- especificar os objetivos

- implementar o sistema

- conceber tarefas de verificação e limiares para aplicar em muitas instâncias futuras

A tarefa de “verificar” é o esforço para avaliar e validar esse sistema antes de ser implementado:

- revisão de requisitos

- avaliação da arquitetura e do design

- testes

- outras formas de verificação e validação

Em tempo de execução, olhamos para instâncias individuais - resultados específicos do sistema, soluções específicas que ele sugere. A tarefa de “verificar” aqui é avaliar estes resultados únicos. Por vezes, as tarefas de “resolver” são muito dispendiosas do ponto de vista computacional, mas verificar os resultados é fácil; no entanto, há casos em que a IA gera um resultado rapidamente, mas o ser humano que supervisiona o sistema gastará muito tempo e esforço a verificá-lo (por exemplo, verificação de factos, revisão de preconceitos, garantia de que o conteúdo se alinha com as normas, etc.), e a verificação torna-se um estrangulamento.

A principal conclusão é que uma supervisão eficaz deve adaptar-se a esta assimetria.

Quando a verificação no momento da conceção é fácil

Esta estratégia consiste em incorporar a segurança desde o início. Ao antecipar o processo de verificação, pode detetar potenciais problemas antes mesmo de a IA ser utilizada, reduzindo a necessidade de uma monitorização manual constante.

Por exemplo, o braço de um robô de fábrica deve operar com um elevado grau de precisão e segurança, permanecendo sempre dentro da sua área de trabalho designada. A verificação de que não irá prejudicar um trabalhador humano próximo é feita durante a fase de conceção e programação através de testes extensivos, modelação e parâmetros de segurança pré-programados. O objetivo é garantir que o sistema é “seguro por conceção”, tornando desnecessária a intervenção humana em tempo real nos seus movimentos básicos.

Quando a verificação no momento da conceção é difícil

Este artigo reconhece que algumas tarefas de IA são demasiado complexas para serem totalmente verificadas durante o desenvolvimento. Nestes casos, o sistema pode ser concebido para fornecer informações claras e acionáveis a um operador humano, que pode então tomar uma decisão final informada. O ser humano atua como o ponto de controlo final.

Por exemplo, um sistema de IA que recomenda um diagnóstico está a realizar uma tarefa muito complexa. A sua precisão pode ser difícil de verificar totalmente durante o desenvolvimento devido às infinitas variações na anatomia humana e nas doenças. Portanto, o sistema deve ser concebido para facilitar a verificação em tempo de execução: não dará apenas um diagnóstico, mas também fornecerá uma pontuação de confiança (por exemplo, “95% de probabilidade de um tumor benigno”), destacará as áreas específicas de uma tomografia que levaram à sua conclusão, adicionará outras citações relevantes e oferecerá uma explicação detalhada do seu raciocínio (rastos de justificação). Um médico pode então utilizar esta informação para fazer o diagnóstico final e informado.

E quanto aos domínios subjetivos onde não há uma resposta certa?

Em áreas como a arte, a ética ou o planeamento estratégico, pessoas diferentes têm valores e perspetivas diferentes. Aqui, em vez de ter um sistema de IA que “colapsa” toda a diversidade numa única resposta “correta” onde muitas vezes não há uma, devemos conceber a IA para ser um parceiro numa discussão. O objetivo não é obter uma solução perfeita, mas sim trazer à luz diferentes perspetivas e cenários. Esta abordagem torna o desacordo uma parte valiosa do processo, uma vez que a IA pode mostrar-lhe os vários compromissos e pontos de vista. Ao fazer isto, o sistema torna-se mais responsável, porque o força a si, o ser humano, a considerar ativamente estas opções e a tomar uma decisão ponderada e bem fundamentada com base em todos os ângulos disponíveis.

Limite de delegação

Os autores do artigo enfatizam que existe uma linha para além da qual a IA já não deve ser o principal decisor - eles chamam-lhe “limite de delegação”. Em certos campos de alto risco como a sentença legal, o diagnóstico médico ou a contratação, o julgamento final acarreta um peso ético e normativo significativo. Estas decisões não devem ser delegadas inteiramente à IA. Nestes casos, a supervisão não se trata apenas de verificar se o resultado da IA está correto. Trata-se de salvaguardar a responsabilidade humana. A IA deve atuar como uma ferramenta para apoiar o decisor humano, fornecendo dados e conhecimentos, mas nunca substituindo completamente o seu papel. A decisão final deve permanecer com um ser humano para garantir a responsabilidade ética e moral.

Os 3 Cs de uma supervisão humana eficiente

O que precisamos de alcançar ao conceber o processo de supervisão da IA?

- Controlo (nós, humanos, podemos fazer intervenções oportunas e eficazes para pausar, redirecionar ou substituir uma decisão da IA)

- Contestabilidade (as decisões da IA são apoiadas por razões e provas compreensíveis, para que possam ser revistas e contestadas)

- Competência (a supervisão melhora o desempenho geral e a equidade do sistema, evitando anulações bruscas que degradariam os resultados corretos da IA)

Condições da agência e da supervisão

O artigo refere-se às condições da agência (individualidade, fonte de ação, orientação para objetivos e adaptabilidade) como um quadro para conceber uma supervisão humana eficaz tanto no momento da conceção como no momento da execução. Pode ler mais sobre estas condições noutro artigo - A Agência é Dependente do Quadro

Vejamos cada uma destas condições - e as dicas práticas de conceção da supervisão humana relacionadas com cada uma delas que o artigo oferece aos desenvolvedores de sistemas.

Individualidade

Esta condição requer uma fronteira clara entre o papel da IA (agência operativa) e o papel do ser humano (agência avaliativa). Aqui precisamos de criar o plano para a interação homem-IA onde a IA deve ser livre para trabalhar autonomamente, e o ser humano deve intervir apenas em pontos de controlo específicos e bem definidos. Esbater estas linhas difunde a responsabilidade.

Momento da conceção

- Definir os limites do sistema e estabelecer pontos de transferência explícitos para a intervenção humana.

Onde termina o trabalho da IA? Não apenas “O sistema tratará do serviço ao cliente”, mas “O sistema responderá a perguntas de clientes relacionadas com as especificações do produto a partir de uma base de conhecimentos predefinida. Não tratará de disputas de faturação ou reembolsos.”

- Adicionar condições para a abstenção (a recusa em responder a uma consulta) quando o sistema tem de sinalizar um caso para intervenção humana em vez de adivinhar

Por exemplo, quando a pontuação de confiança for < 90%, o sistema sinalizará a um ser humano que está a operar numa “zona cinzenta”.

- Definir pontos de controlo de transferência humana predeterminados - onde o controlo passa da IA para um ser humano.

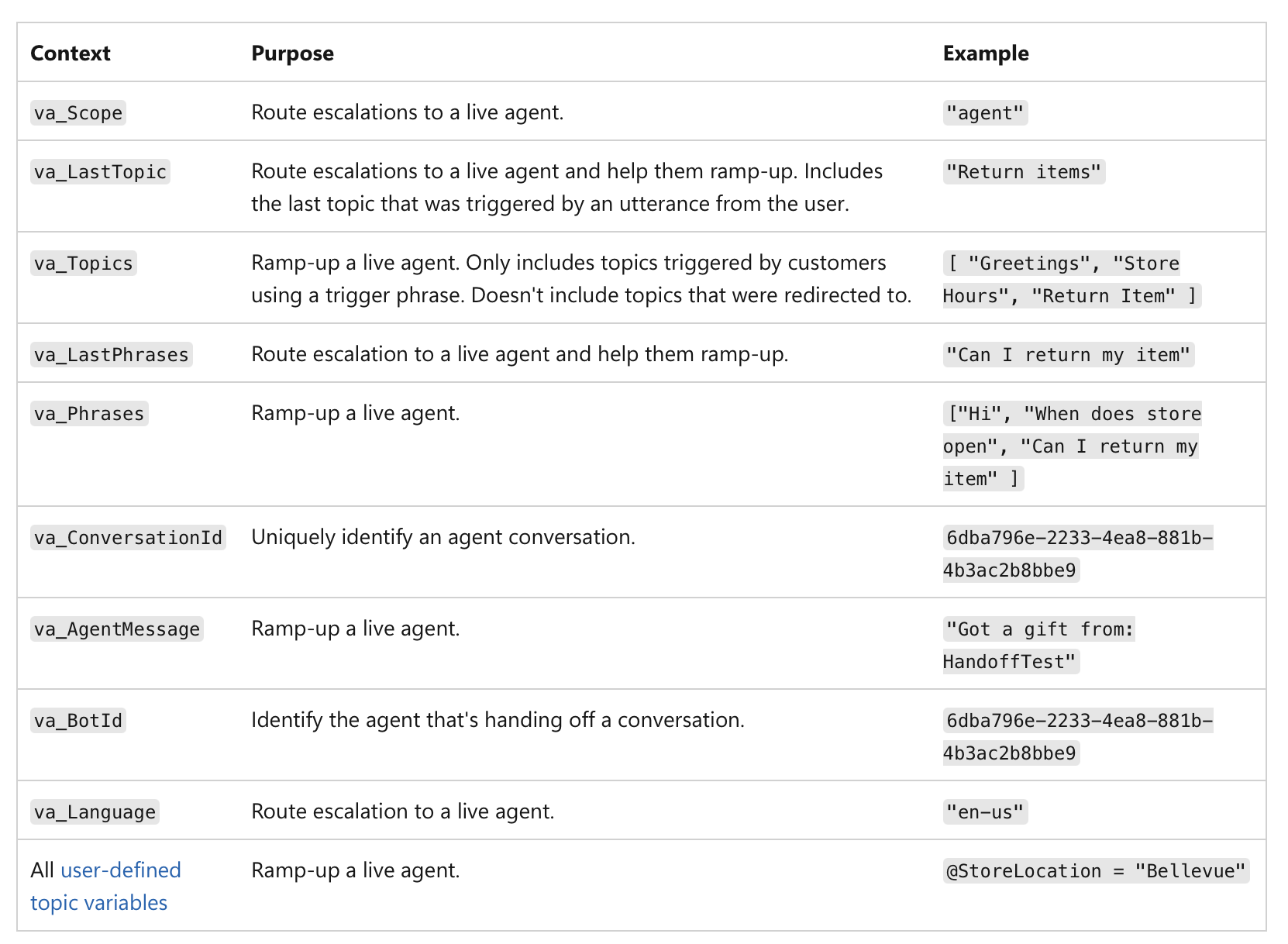

Não se trata apenas de uma pontuação de confiança baixa, mas da importância da própria ação. Por exemplo, mesmo que uma IA tenha 99% de confiança, se a decisão envolver uma transação financeira acima de 1 milhão de dólares ou um diagnóstico médico crítico, a natureza de alto risco da tarefa torna-a um ponto de controlo humano obrigatório. Aqui está um exemplo de como a transferência humana pode ser implementada nos agentes do MS Copilot:

(fonte)

(fonte)

Momento da execução

Uma vez que o sistema está em funcionamento, o foco muda para o registo e a responsabilização.

- Registar quando o controlo passa efetivamente da IA para o ser humano.

O seu sistema deve criar um registo imutável (por exemplo, numa blockchain ou numa base de dados de escrita única - para evitar adulterações) de cada transferência: o registo deve incluir um carimbo de data/hora, a ação final da IA e a identidade do ser humano que assumiu o controlo:

“Pedido de empréstimo #12345 transferido para o analista humano Mary Smith às 10:30 devido a uma pontuação de crédito abaixo do limiar.”

Isto garante uma clara responsabilização pela decisão final.

Os dados registados podem ser utilizados para criar painéis e relatórios para supervisão - pode ver com que frequência ocorre a intervenção humana, se as recomendações da IA estão a ser aceites ou rejeitadas e quem está a tomar as decisões finais. Isto ajuda-nos a identificar áreas onde o desempenho da IA pode ser fraco ou onde os processos humanos precisam de ser aperfeiçoados.

Fonte da ação

Aqui rastreamos a causa de um resultado. O processo gerativo de uma IA é muitas vezes opaco, pelo que tentar “co-possuí-lo” através da elaboração meticulosa de prompts pode ser apenas uma ilusão de controlo. Em vez disso, a supervisão humana deve focar-se na avaliação do resultado final, revendo o historial causal (prompts, entradas, chamadas à IA) (também conhecido como proveniência).

Momento da conceção

-

Garantir que o sistema consegue capturar um registo completo da sua proveniência através de um registo de ponta a ponta (imutável e padronizado para legibilidade por máquina), onde cada passo no fluxo de trabalho da IA é automaticamente registado e carimbado com a hora:

- dados de entrada e prompt utilizados

- versão específica do modelo de IA utilizado para gerar o resultado

- historial completo de instruções e modificações humanas

- quaisquer chamadas externas, serviços externos, APIs, bases de dados a que o sistema de IA acedeu

- resultados intermédios que o sistema gerou mas que acabou por descartar

Esta pré-impressão de “Utilizar Registos de Blockchain para Registar as Decisões da IA na IoT”, por exemplo, discute como isto pode ser feito na prática: https://www.preprints.org/manuscript/202504.1789/v1 Aqui está um exemplo desta pré-impressão:

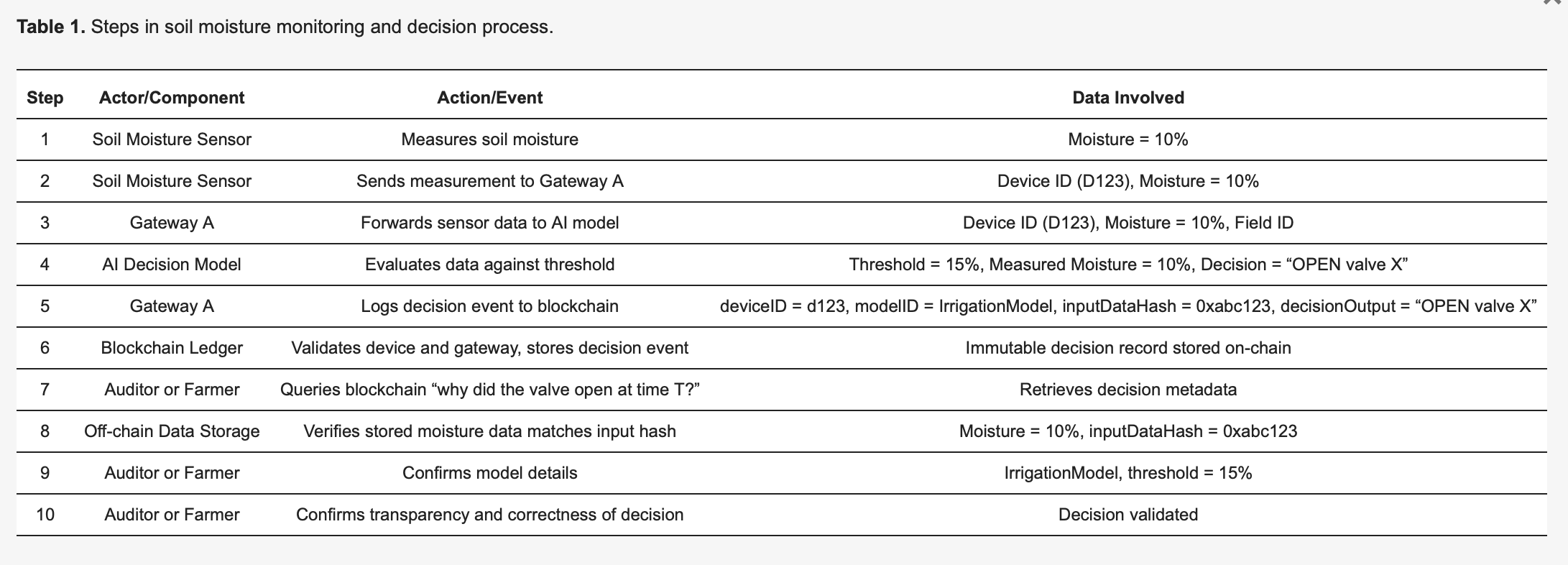

Para tornar a metodologia concreta, considere um sistema de irrigação inteligente baseado em IoT [27], detalhado na Tabela 1. Os sensores de humidade do solo (dispositivos) enviam leituras para um modelo de IA de ponta que decide se as válvulas de água devem abrir ou permanecer fechadas. Cada decisão tomada pela IA desencadeia um evento de registo capturado de forma imutável num registo de blockchain, melhorando a transparência e a auditabilidade. Conforme ilustrado na Tabela 1, o Sensor 123 deteta humidade a 10 por cento e transmite esta medição para o Gateway A. O Gateway A encaminha os dados para o modelo de IA, que, devido a um limiar predefinido de 15 por cento (especificado pelo IrrigationModelv2), determina a ação apropriada: “válvula = ABERTA” para o campo X. O Gateway A prepara então uma transação contendo metadados críticos—incluindo o ID do dispositivo (123), o ID do modelo (IrrigationModelv2), um hash dos dados de entrada (0xabc123) e o resultado da decisão (ABRIR válvula X)—assina-a e submete-a à blockchain. Os nós da blockchain verificam a autenticidade e as permissões do Sensor 123 e do Gateway A, confirmam que estão devidamente registados no campo X e, subsequentemente, armazenam o registo permanentemente. É emitido um evento para indicar o registo bem-sucedido. Mais tarde, um auditor ou o agricultor pode consultar “porque é que a água foi libertada no momento T?”, recuperando o registo detalhado da transação da blockchain. O hash (0xabc123) da blockchain pode então ser cruzado com os dados do sensor armazenados fora da cadeia (armazenados no IPFS ou na base de dados do Gateway A) para confirmar que a leitura de humidade foi de facto de 10 por cento. Adicionalmente, referenciando o registo do modelo, o agricultor pode validar que o limiar de irrigação foi definido em 15 por cento de humidade, confirmando que a decisão da IA foi correta e justificada. Este processo estruturado melhora significativamente a transparência: cada ação automatizada é verificável e totalmente explicável através de metadados registados, e a imutabilidade da blockchain garante que nem os operadores agrícolas nem os fabricantes de dispositivos podem modificar secretamente os registos de decisões.

Momento da execução

- Inspecionar a cadeia causal do caso específico para ver como o resultado foi gerado.

- Utilizar um painel visual que mapeia toda a cadeia causal de um resultado específico para ver o resultado final e cada passo que levou a ele.

Quando quiser rever uma decisão, pode consultar o registo de proveniência desse caso específico. Não precisa de compreender o “caminho gerativo” interno da IA (a matemática complexa e as ativações neuronais). Em vez disso, verifica os metadados de proveniência para responder a perguntas como estas:

“Foram utilizados os dados corretos?”

Por exemplo, quando um médico consulta o registo de proveniência, os metadados mostram uma lista dos pontos de dados específicos que a IA utilizou. O registo de proveniência confirma que a IA utilizou o historial médico completo do paciente, uma análise de sangue recente de 24/10/25 e uma ressonância magnética de 26/10/25, e todos os pontos de dados correspondem ao RSE oficial. Num caso diferente, o médico pode concluir que o registo de proveniência mostra que a IA acedeu a dados de análises de sangue de há dois anos, mas o historial do paciente foi atualizado com novos resultados na semana passada e a IA utilizou informações desatualizadas.

“O prompt do ser humano foi processado com precisão?”

O prompt do médico para a IA foi “Analisar os sintomas e recomendar um diagnóstico para um homem de 45 anos com tosse persistente e febre”. O registo de proveniência regista a consulta exata que a IA recebeu. O médico compara isto com a sua entrada original e repara que a consulta registada mostra que o prompt foi truncado, faltando o sintoma “febre” - pelo que a IA apenas processou “tosse persistente”, o que levou a um caminho de diagnóstico diferente.

“Foi implementada a versão correta do modelo?”

O registo de proveniência pode mostrar que o diagnóstico foi gerado por uma versão mais antiga do modelo que deveria ter sido descontinuada devido a um erro do sistema.

Aqui, o sistema atribui claramente as ações à geração autónoma da IA ou à intervenção específica de um ser humano. Isto permite uma clara responsabilização. Se for tomada uma má decisão, uma verificação rápida do registo de proveniência pode revelar se foi um resultado defeituoso da IA ou um erro de avaliação humana, evitando o “jogo da culpa” em que a agência é difundida.

Orientação para objetivos

A IA deve gerir os sub-objetivos de baixo nível, enquanto os humanos mantêm a autoridade sobre os objetivos de alto nível. O papel do ser humano é garantir que o caminho escolhido pela IA se alinha com os objetivos e restrições mais amplos, como requisitos legais ou metas de equidade.

Momento da conceção

- Publicar explicitamente os objetivos de alto nível, as restrições e as regras de compromisso para a IA.

Os objetivos de alto nível, definidos pelo ser humano, são tornados claros e acessíveis. Não são apenas declarações de missão vagas; são metas tangíveis, muitas vezes numéricas. Para uma IA de logística, isto poderia ser “minimizar o tempo de entrega em 15% sem aumentar os custos de combustível”. Para uma IA de contratação, um objetivo de alto nível poderia ser “aumentar as candidaturas qualificadas em 20% garantindo que não há preconceito racial ou de género na procura de candidatos”.

- Definir restrições e regras de compromisso.

A autoridade humana é expressa através de limites e regras. A IA deve receber limites explícitos que não pode violar. Por exemplo, “manter-se dentro do orçamento legal”, “não recomendar qualquer ação que viole as leis de privacidade” ou “priorizar a equidade sobre a eficiência pura”. Nos casos em que os objetivos entram em conflito (por exemplo, velocidade vs. custo), as regras de compromisso definidas pelo ser humano devem ditar qual tem prioridade.

Momento da execução

Aqui o foco muda para a monitorização e avaliação. Um ser humano não precisa de conhecer cada passo computacional, mas pode ver se a direção geral da IA se alinha com o objetivo de nível superior. Podemos avaliar o progresso em pontos predefinidos específicos.

- Testar se o resultado atual e os sub-objetivos da IA são consistentes com os objetivos declarados.

Por exemplo, uma IA financeira pode ser autorizada a executar várias simulações para otimizar uma carteira (sub-objetivos), mas um analista humano deve aprovar a estratégia final para garantir que se alinha com a tolerância ao risco e os requisitos legais do cliente (objetivos de alto nível). Este processo permite que a IA utilize a sua “agência operativa” para explorar soluções, enquanto o ser humano retém a “agência avaliativa” para garantir que a direção da IA permanece legítima.

- Garantir que o sistema é concebido para monitorizar e reportar continuamente o seu progresso em direção aos seus sub-objetivos.

Para uma IA de geração de conteúdo, isto pode envolver o relato das suas tentativas de encontrar palavras-chave específicas ou a sua estratégia para estruturar o artigo.

- O sistema deve criar um registo claro e rastreável das suas decisões, incluindo o motivo pelo qual perseguiu um determinado sub-objetivo. Este registo é disponibilizado a um avaliador humano.

Se uma IA gerar um resultado enviesado, um auditor pode rastrear o seu caminho e ver onde começou a desviar-se das restrições de equidade definidas na fase de conceção.

Adaptabilidade

Um ser humano não pode supervisionar de forma viável todas as pequenas alterações internas que uma IA faz. A supervisão humana deve ser direcionada para alterações significativas, como mudanças na política ou no comportamento geral do sistema. Trata-se de criar as barreiras de proteção para o comportamento adaptativo da IA.

Momento da conceção

- Configurar controlos de alterações e monitores de desvio que detetem alterações comportamentais significativas.

O sistema deve ser concebido para versionar os seus próprios modelos e configurações para que seja possível reverter para uma versão anterior e estável se algo correr mal.

Os monitores de desvio são ferramentas que rastreiam constantemente o desempenho e o comportamento da IA no mundo real. Eles não medem apenas a precisão; procuram o desvio de conceito (quando a relação entre os dados de entrada e saída muda) e o desvio de dados (quando os próprios dados de entrada mudam). Os monitores são configurados com limiares específicos. Por exemplo, o monitor de desvio de uma IA de deteção de fraudes pode ser configurado para alertar um ser humano se a sua taxa de falsos positivos aumentar mais de 5%.

Momento da execução

Uma vez que o sistema está em funcionamento, os humanos não o observam constantemente. São alertados pelos monitores automatizados, o que lhes permite focar a sua atenção de forma eficaz. Quando o limiar de um monitor de desvio é ultrapassado, ele envia automaticamente um alerta para uma equipa humana. O alerta deve incluir um instantâneo do comportamento observado e os dados relevantes, para que o ser humano possa avaliar rapidamente a situação. O sistema também pode ser pré-programado para seguir um protocolo específico quando uma alteração é detetada.

O que ganho se implementar este quadro?

Esta abordagem cria uma parceria poderosa onde o sistema de IA e o ser humano “supervisor” têm cada um um papel distinto e valioso. A IA é livre para usar o seu poder computacional para resolver problemas complexos (a sua “agência operativa”), enquanto o ser humano, usando sinais claros do sistema, está capacitado para tomar decisões informadas de alto nível e intervir quando necessário (a sua “agência avaliativa”). O resultado é uma colaboração de “soma não-zero”, onde o esforço combinado leva a melhores resultados do que o ser humano ou a IA poderiam alcançar sozinhos.

Como é que este quadro aborda o Art. 14 da Lei da IA?

O quadro aborda diretamente os requisitos da Lei da IA da UE, em particular o Artigo 14, ao oferecer uma abordagem prática e acionável para a “supervisão humana eficaz” que vai além dos princípios abstratos. Define a supervisão não como uma obrigação vaga, mas como um processo sistemático de conceber a IA para apoiar a agência avaliativa humana.

O que é que a Lei da IA exige dos desenvolvedores de sistemas de IA?

- “Ferramentas de interface homem-máquina adequadas… podem ser eficazmente supervisionadas.”

O princípio fundamental do quadro é que o próprio sistema de IA deve ser construído para permitir a supervisão. O quadro proposto pelo artigo oferece características de conceção fundamentais que garantem que o funcionamento do sistema seja transparente e gerível para um ser humano.

- “Visar prevenir ou minimizar os riscos.”

A ênfase do quadro na agência avaliativa aborda diretamente isto. O papel do ser humano é fornecer o “julgamento de ordem superior” que ancora as ações da IA a normas profissionais e sociais. Este é o mecanismo para prevenir os riscos que a IA, operando com a sua agência operativa, pode não detetar. As verificações no momento da conceção do quadro (por exemplo, definir metas de equidade, identificar decisões de alto risco) garantem que a prevenção de riscos é uma parte intencional da arquitetura do sistema, não uma reflexão tardia.

- “Medidas… incorporadas no sistema de IA de alto risco.”

Toda a estrutura do quadro é construída em torno deste requisito. Os “Artefactos de IA a Expor” e a “Superfície de Verificação do Sistema” para cada condição são exemplos de medidas que são “incorporadas… no sistema de IA de alto risco pelo fornecedor.”

A condição de individualidade exige que o sistema seja concebido com contratos de API de transferência claros. A condição de adaptabilidade exige monitores de desvio e mecanismos de reversão incorporados. Todas estas são medidas concretas implementadas pelo fornecedor.

O quadro também orienta o fornecedor na identificação de medidas para o implementador. Por exemplo, a condição de Fonte de Ação exige que o fornecedor dê ao implementador um painel de proveniência, que é uma medida fundamental para o implementador implementar e utilizar.

- “Supervisão humana… habilitada, conforme apropriado e proporcional.” O quadro traduz diretamente cada ponto deste sub-artigo num requisito de conceção.

a) “Compreender adequadamente as capacidades e limitações relevantes”

As condições de Individualidade e Orientação para Objetivos abordam isto ao exigir uma documentação explícita dos limites, objetivos e restrições da IA. Isto proporciona ao ser humano uma compreensão clara das capacidades da IA.

b) “Permanecer ciente de… viés de automação”

O quadro promove a agência avaliativa como contrapeso ao viés de automação. A ênfase na verificação dos resultados da IA em vez de simplesmente os aceitar força o ser humano a permanecer envolvido e fornece um mecanismo para anular a IA quando necessário.

c) “Interpretar corretamente o… resultado”

A condição de Fonte de Ação garante que o resultado da IA é acompanhado por metadados e registos de proveniência interpretáveis. Isto permite ao ser humano interpretar corretamente o contexto e a cadeia causal do resultado, tornando possível uma simples decisão.

d) “Decidir… não usar… ou ignorar… o resultado”

A condição de Individualidade apoia diretamente isto ao exigir pontos de transferência explícitos e mecanismos de “recusar responder e transferir para um ser humano”, capacitando o ser humano a intervir e anular o sistema.

e) “Intervir… ou interromper… através de um botão de ‘parar’”

Os mecanismos de reversão e abstenção da condição de Adaptabilidade fornecem o equivalente funcional de um botão de “parar”. Permitem que um ser humano pare ou reverta a operação da IA de forma segura e controlada.

f) “Verificação por pelo menos duas pessoas singulares.”

O quadro fornece as ferramentas para que este seja um processo viável e significativo. O registo de proveniência da condição de Fonte de Ação e um registo claro de todas as interações humanas facilitam a verificação independente da identificação de uma IA por duas ou mais pessoas. Ambas podem consultar o mesmo conjunto de dados registados e rever a cadeia causal para chegar a um consenso, garantindo que a verificação se baseia em provas objetivas em vez de suposições subjetivas.

Desafios

Claro que, embora o quadro pareça muito promissor e aplicável, o artigo não ignora as desvantagens comuns da implementação dos mecanismos de supervisão.

Complexidade e custo

Primeiro, nem todos são simples de configurar - muitos exigem um esforço inicial significativo para conceber e construir. É necessária experiência especializada para criar sistemas que possam gerar justificações estruturadas, capturar a proveniência ou codificar regras com nuances num registo de objetivos. Além disso, prepare-se para os custos contínuos de manutenção do sistema, calibração de sinais e formação dos revisores humanos nos novos processos.

Dependência do sinal

A eficácia destes mecanismos de supervisão depende muito da qualidade dos sinais que produzem. Se a IA gerar sinais fracos ou ruidosos (por exemplo, pontuações de confiança imprecisas, justificações vagas ou dados de proveniência defeituosos), pode induzir em erro o revisor humano e minar todo o processo de supervisão.

Fardo da verificação

Embora o objetivo seja melhorar a eficiência, estes sistemas não eliminam completamente a carga de trabalho humana. Em casos limítrofes, novos ou ambíguos, o revisor humano pode ainda precisar de realizar verificações pontuais manuais e intensivas. O artigo observa que isto pode reduzir os ganhos de eficiência, uma vez que os revisores podem precisar de gastar muito tempo a resolver abstenções ou a contestar as sugestões da IA. O fardo humano passa de uma avaliação em grande escala para uma verificação detalhada do trabalho da IA, que ainda pode ser significativa.

Lembre-se: é necessária uma mudança de mentalidade

Portanto, não basta dizer que precisamos de “supervisão humana”. Para que seja uma realidade, precisamos de mudar a nossa mentalidade de simplesmente “supervisionar a IA” para conceber a IA para a colaboração homem-IA: redefinir o papel do ser humano como um avaliador ativo, incorporar a supervisão na conceção da IA, lembrarmo-nos dos três Cs - controlo, contestabilidade e competência - e então não estará apenas a cumprir regulamentos como a Lei da IA - estará a criar um sistema mais fidedigno e poderoso que funciona com as pessoas.