Ludzki nadzór nad sztuczną inteligencją

Ludzki nadzór w systemach sztucznej inteligencji jest wymogiem zgodności:

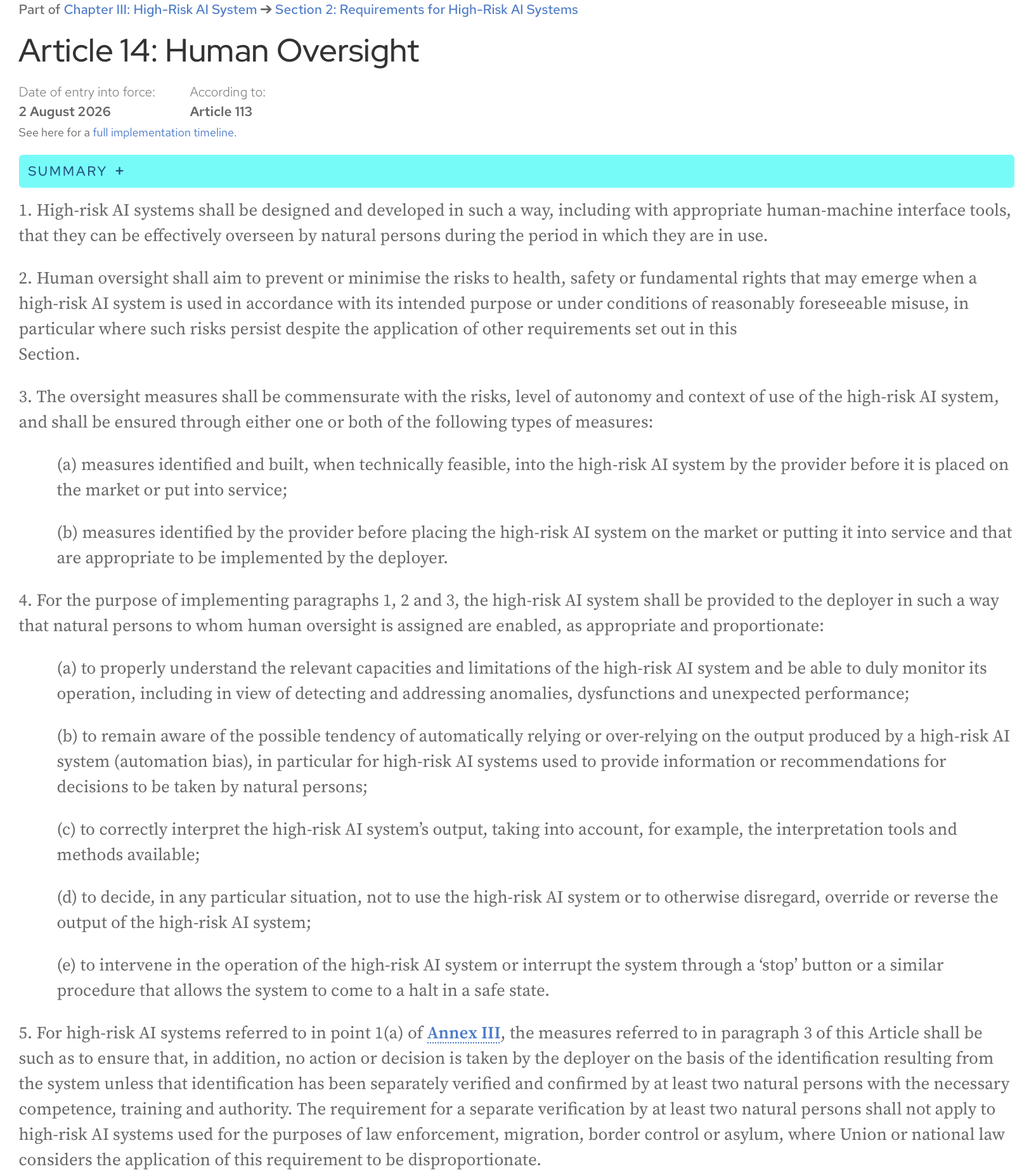

AI Act, Artykuł 14: Systemy sztucznej inteligencji wysokiego ryzyka powinny być projektowane i rozwijane w taki sposób, w tym z odpowiednimi narzędziami interfejsu człowiek-maszyna, aby mogły być skutecznie nadzorowane przez osoby fizyczne w okresie, w którym są w użyciu.

Oto pełny tekst artykułu z oficjalnej strony internetowej AI Act:

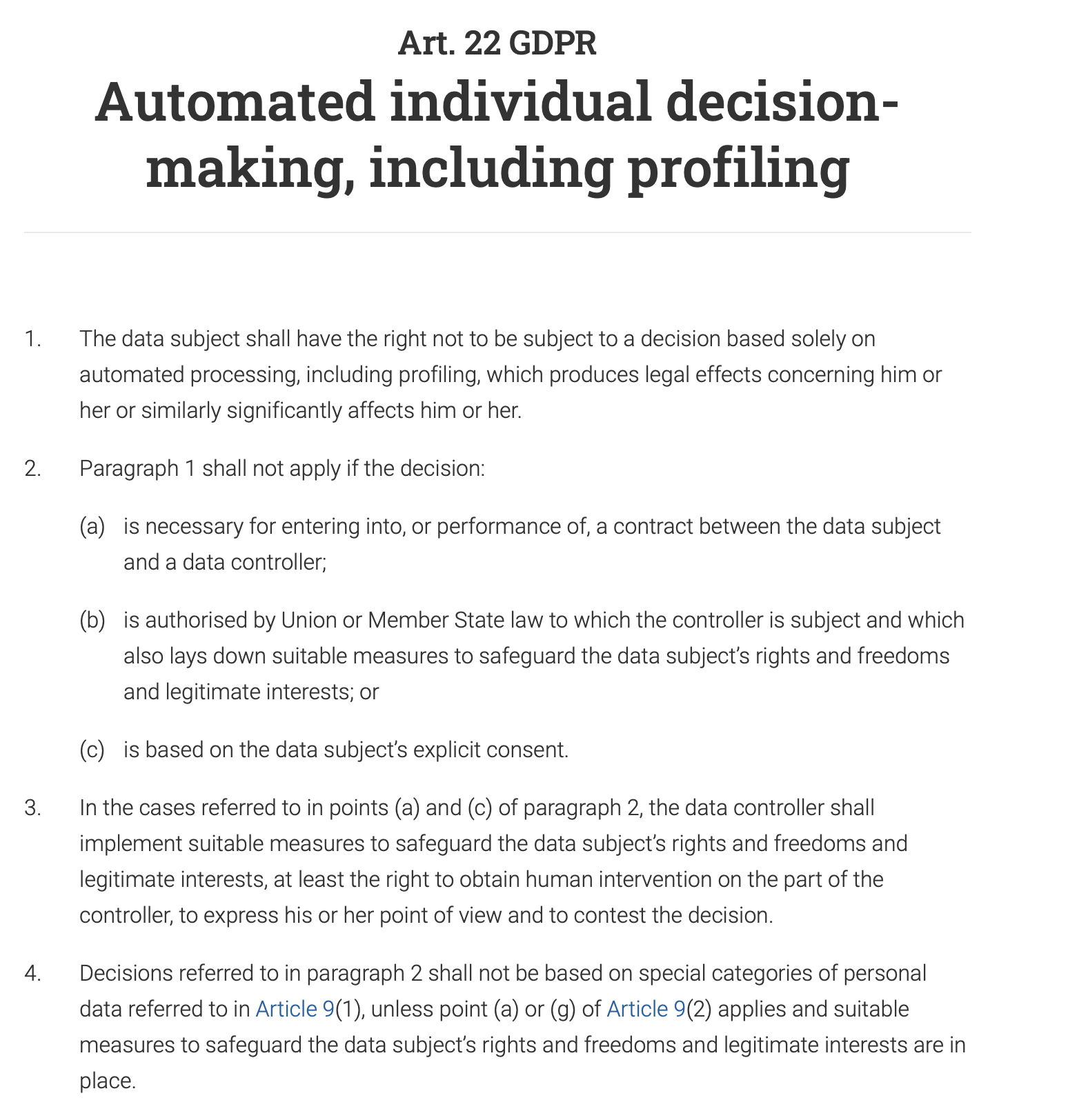

Artykuł 22 RODO wyraźnie zapewnia osobom fizycznym prawo do “niepodlegania decyzji, która opiera się wyłącznie na zautomatyzowanym przetwarzaniu, w tym profilowaniu, i wywołuje wobec tej osoby skutki prawne lub w podobny sposób istotnie na nią wpływa”. Oznacza to, że w przypadku każdego zautomatyzowanego systemu podejmowania decyzji, który ma duży wpływ na osobę fizyczną (np. odrzucenie wniosku o pożyczkę, oferty pracy lub świadczenia publicznego), w procesie musi uczestniczyć człowiek, aby zweryfikować i zatwierdzić decyzję. Osoba fizyczna ma również prawo do zakwestionowania zautomatyzowanej decyzji i uzyskania interwencji człowieka.

I, co nie jest zaskakujące, ludzki nadzór jest kluczowym wymogiem zarówno w normie ISO 42001, jak i w Ramach Zarządzania Ryzykiem AI NIST (AI RMF). Obie ramy, choć różne w swoim podejściu, podkreślają potrzebę interwencji człowieka w celu zapewnienia odpowiedzialnego i etycznego wykorzystania systemów AI.

Ten post jest moją interpretacją artykułu, który został zaprezentowany na ostatniej sesji comiesięcznego Data61 AI Adoption and Assurance Chat - “Projektowanie znaczącego ludzkiego nadzoru w AI” (https://www.researchgate.net/publication/395540553_Designing_Meaningful_Human_Oversight_in_AI).

(pełna cytata artykułu: Zhu, Liming & Lu, Qinghua & Ding, Ming & Lee, Sunny & Wang, Chen & Data, & Csiro, & Australia,. (2025). Designing Meaningful Human Oversight in AI. 10.13140/RG.2.2.16624.11528)

Artykuł omawia problem z obecnym podejściem do ludzkiego nadzoru i przedstawia praktyczne wskazówki dla twórców systemów AI.

Czym jest ludzki nadzór i jak się go sprawuje?

Problem z ludzkim nadzorem polega na tym, że jest on słabo zdefiniowany. Ale moim zdaniem, to, co wszystko komplikuje, to nasza naturalna tendencja do automatyzacji - skłonność do ufania wynikom maszyny bardziej niż własnemu osądowi. Ile razy ślepo podążałeś za GPS-em na nieistniejącą drogę?

W rezultacie albo zatwierdzamy wynik systemu bez jego właściwego zrozumienia (“zatwierdzamy na ślepo”).

Na przykład system AI banku może oznaczyć Twoją transakcję jako obarczoną wysokim ryzykiem, a ludzki analityk, którego zadaniem jest codzienne przeglądanie tysięcy takich alertów, automatycznie zatwierdza decyzję AI i zamraża Twoje konto.

Odwrotny scenariusz jest również powszechny: ograniczamy system tak bardzo, że zamiast dać mu cel wysokiego poziomu i pewną swobodę w eksplorowaniu kompromisów i znajdowaniu rozwiązań, próbujemy zaprogramować każdą pojedynczą akcję, którą powinien podjąć, i w ten sposób sprowadzamy go do systemu automatyzacji opartego na regułach.

Firma chce, aby chatbot AI obsługiwał zapytania klientów. Zamiast dać mu cel wysokiego poziomu, taki jak “rozwiąż problem klienta grzecznie i wydajnie”, programujesz go sztywnym skryptem, który dyktuje, że jeśli klient zapyta: “Jak mogę zwrócić produkt?”, bot musi odpowiedzieć linkiem do strony zwrotów, a następnie zapytać: “Czy to odpowiedziało na Twoje pytanie?”. Nie potrafi on obsługiwać zniuansowanych pytań, takich jak: “Zgubiłem paragon, czy nadal mogę to zwrócić?”, ponieważ reguły nie obejmują tego konkretnego scenariusza. Chatbot traci swoją jakość agencyjną i staje się podstawowym, frustrującym drzewem decyzyjnym.

Artykuł argumentuje, że żaden z tych scenariuszy nie jest optymalny, a ludzka agencja i agencja AI nie są grą o sumie zerowej. Współpraca obu przynosi lepsze wyniki, niż każdy z nich mógłby osiągnąć samodzielnie.

Jak można zaprojektować ludzki nadzór, aby umożliwić tę współpracę?

Dwa rodzaje agencji

Zacznijmy od definicji agencji: jest to zdolność do podejmowania działań i sprawiania, że rzeczy dzieją się samodzielnie, w celu osiągnięcia celu.

Artykuł sugeruje rozróżnienie między dwoma rodzajami agencji:

- Agencja operacyjna (zdolność AI do generowania rozwiązań)

Na przykład, medyczny system AI generuje diagnozę.

- Agencja oceniająca (zdolność człowieka do zrozumienia, oceny, weryfikacji rozwiązania AI i, w razie potrzeby, sterowania jego wynikami lub zastępowania ich alternatywnymi rozwiązaniami)

Lekarz nie powiela procesu diagnostycznego. Nie jest zadaniem lekarza powtarzanie pracy AI ani przechytrzanie maszyny. Zamiast tego, ich rolą jest ocena diagnozy AI. Lekarz pyta: “Czy to ma sens? Czy rozumowanie AI jest zgodne z tym, co zrobiłby odpowiedzialny ludzki ekspert?”. Sprawdzają spójność. Przeglądają uzasadnienie AI, które może być listą kluczowych objawów i cytatem z literatury medycznej. Lekarz weryfikuje, czy to rozumowanie jest zgodne z ich własnym szkoleniem i standardami medycznymi. Dodają również kontekst ludzki: wiedząc, że leczenie rzadkiej choroby jest kosztowną, bolesną i intensywną roczną terapią, biorą pod uwagę preferencje pacjenta, sytuację finansową i to, czy są gotowi poddać się tak trudnemu reżimowi. Na koniec ważą potencjalne korzyści z leczenia w stosunku do jego znacznego obciążenia i decydują, czy jest to najbardziej odpowiedni i etyczny sposób postępowania, nawet jeśli diagnoza AI jest technicznie poprawna.

Trudno nie zgodzić się z opinią autorów, że “oceniać” to lepsze słowo niż “nadzorować”, ponieważ podkreśla rolę człowieka jako aktywną i oceniającą, a nie tylko nadzorczą czy symboliczną.

Agencja oceniająca zapewnia odpowiedzialność

Jeśli coś pójdzie nie tak, ostatecznie odpowiedzialny jest człowiek. AI nie może być pociągnięta do odpowiedzialności w sądzie; osoba, która oceniła jej wynik, może. Poza tym, osąd człowieka zakotwicza działania AI w standardach zawodowych, etycznych i społecznych, których sama AI nie jest w stanie zrozumieć. AI może znaleźć najszybszą trasę, ale tylko człowiek może zdecydować, czy ta trasa jest najbardziej etyczna lub bezpieczna. Te dwie korzyści są kluczowe dla odpowiedzialnej i godnej zaufania AI.

Wewnętrzna a zewnętrzna wierność rozumowania

Jak możemy oceniać wyniki systemu, jeśli wciąż nie jesteśmy w stanie w pełni pojąć złożonego wewnętrznego działania nowoczesnych modeli AI? Każda aktywacja sieci neuronowej, każda korekta parametrów, czy to, jak wyuczona wiedza modelu (jak pojęcie “kota”) jest dystrybuowana i przechowywana w jego milionach lub miliardach parametrów (pamięć modelu) - próba zrozumienia tego algorytmicznego obwodu nie jest wykonalna na tym etapie rozwoju AI, a nawet gdyby była, byłoby to jak patrzenie na decyzje podejmowane przez program szachowy przez pryzmat pojedynczych obliczeń, które wykonuje - zbyt wiele szczegółów, zbyt złożone i niezbyt przydatne do faktycznej oceny decyzji.

Zamiast tego możemy projektować systemy w taki sposób, aby dostarczały wyjaśnień, które mają sens dla człowieka - wyjaśnień opartych na tym, co artykuł nazywa “zewnętrzną wiernością rozumowania” lub “prawdopodobieństwem”. Program szachowy powiedziałby: “Wybrałem ten ruch, aby kontrolować centrum szachownicy i wywrzeć presję na skoczka przeciwnika”, a my bylibyśmy w stanie ocenić tę decyzję, ponieważ jej wyjaśnienie jest zgodne z ustalonymi zasadami szachowymi i ludzkim osądem.

Jak więc zaprojektować system, aby dostarczał takich wskazówek, które możemy ocenić i, w razie potrzeby, zakwestionować?

Asymetria rozwiązanie-weryfikacja

Artykuł wprowadza użyteczne pojęcie asymetrii rozwiązanie-weryfikacja: trudność tworzenia rozwiązania (rozwiązywanie) i trudność sprawdzania tego rozwiązania (weryfikacja) często nie są równe. Dzieje się tak zarówno w czasie projektowania, jak i w czasie wykonywania, a zrozumienie tego pomaga stworzyć skuteczny proces ludzkiego nadzoru.

W fazie projektowania zadanie “rozwiązania” to wysiłek wymagany do zbudowania systemu AI:

- tworzenie architektury systemu

- określanie celów

- implementacja systemu

- projektowanie zadań weryfikacyjnych i progów do zastosowania w wielu przyszłych instancjach

Zadanie “weryfikacji” to wysiłek włożony w ocenę i walidację tego systemu przed jego wdrożeniem:

- przegląd wymagań

- ocena architektury i projektu

- testowanie

- inne formy weryfikacji i walidacji

W czasie wykonywania patrzymy na poszczególne instancje - konkretne wyniki systemu, konkretne rozwiązania, które sugeruje. Zadaniem “weryfikacji” jest tutaj ocena tych pojedynczych wyników. Czasami zadania “rozwiązania” są bardzo kosztowne obliczeniowo, ale sprawdzanie wyników jest łatwe; jednak zdarzają się przypadki, gdy AI szybko generuje wynik, ale człowiek nadzorujący system spędzi dużo czasu i wysiłku na jego weryfikacji (na przykład sprawdzanie faktów, przegląd pod kątem stronniczości, zapewnienie zgodności treści ze standardami itp.), a weryfikacja staje się wąskim gardłem.

Głównym wnioskiem jest to, że skuteczny nadzór musi dostosować się do tej asymetrii.

Kiedy weryfikacja w czasie projektowania jest łatwa

Ta strategia polega na wbudowywaniu bezpieczeństwa od samego początku. Poprzez wcześniejsze przeprowadzenie procesu weryfikacji, można wychwycić potencjalne problemy, zanim AI zostanie w ogóle użyta, co zmniejsza potrzebę stałego, ręcznego monitorowania.

Na przykład, ramię robota fabrycznego musi działać z dużą precyzją i bezpieczeństwem, zawsze pozostając w wyznaczonym obszarze roboczym. Weryfikacja, że nie zaszkodzi ono pobliskiemu pracownikowi, odbywa się na etapie projektowania i programowania poprzez szeroko zakrojone testy, modelowanie i wstępnie zaprogramowane parametry bezpieczeństwa. Celem jest zapewnienie, że system jest “bezpieczny z założenia”, co sprawia, że interwencja człowieka w czasie rzeczywistym w jego podstawowe ruchy jest niepotrzebna.

Kiedy weryfikacja w czasie projektowania jest trudna

Ten artykuł przyznaje, że niektóre zadania AI są zbyt złożone, aby można je było w pełni zweryfikować podczas rozwoju. W takich przypadkach system można zaprojektować tak, aby dostarczał jasnych, użytecznych informacji operatorowi ludzkiemu, który może następnie podjąć świadomą ostateczną decyzję. Człowiek działa jako ostateczny punkt kontrolny.

Na przykład, system AI, który zaleca diagnozę, wykonuje bardzo złożone zadanie. Jego dokładność może być trudna do pełnej weryfikacji podczas rozwoju ze względu na nieskończone wariacje w ludzkiej anatomii i chorobach. Dlatego system powinien być zaprojektowany tak, aby ułatwić weryfikację w czasie wykonywania: nie tylko poda diagnozę, ale także dostarczy wynik pewności (np. “95% prawdopodobieństwa łagodnego guza”), podkreśli konkretne obszary skanu, które doprowadziły do jego wniosku, doda inne istotne cytaty i zaoferuje szczegółowe wyjaśnienie swojego rozumowania (ślady uzasadnienia). Lekarz może następnie wykorzystać te informacje do postawienia ostatecznej, świadomej diagnozy.

A co z subiektywnymi dziedzinami, w których nie ma jednej właściwej odpowiedzi?

W dziedzinach takich jak sztuka, etyka czy planowanie strategiczne, różni ludzie mają różne wartości i perspektywy. Tutaj, zamiast mieć system AI, który “zwija” całą różnorodność w jedną “poprawną” odpowiedź, gdzie często jej nie ma, powinniśmy projektować AI jako partnera w dyskusji. Celem nie jest uzyskanie idealnego rozwiązania, ale ujawnienie różnych perspektyw i scenariuszy. Takie podejście sprawia, że niezgoda staje się cenną częścią procesu, ponieważ AI może pokazać ci różne kompromisy i punkty widzenia. W ten sposób system staje się bardziej odpowiedzialny, ponieważ zmusza ciebie, człowieka, do aktywnego rozważenia tych opcji i podjęcia przemyślanej, dobrze uzasadnionej decyzji w oparciu o wszystkie dostępne kąty.

Granica delegacji

Autorzy artykułu podkreślają, że istnieje granica, poza którą AI nie powinna już być głównym decydentem - nazywają ją “granicą delegacji”. W niektórych dziedzinach o wysokiej stawce, takich jak wyroki sądowe, diagnoza medyczna czy rekrutacja, ostateczny osąd ma znaczną wagę etyczną i normatywną. Te decyzje nie powinny być w całości delegowane na AI. W takich przypadkach nadzór nie polega tylko na sprawdzaniu, czy wynik AI jest poprawny. Chodzi o ochronę ludzkiej odpowiedzialności. AI powinna działać jako narzędzie wspierające ludzkiego decydenta, dostarczając danych i spostrzeżeń, ale nigdy w pełni nie zastępując jego roli. Ostateczna decyzja musi pozostać w gestii człowieka, aby zapewnić odpowiedzialność etyczną i moralną.

3 C efektywnego nadzoru ludzkiego

Co musimy osiągnąć, projektując proces nadzoru nad sztuczną inteligencją?

- Kontrola (my, ludzie, możemy podejmować terminowe i skuteczne interwencje, aby wstrzymać, przekierować lub zastąpić decyzję AI)

- Możliwość zakwestionowania (decyzje AI są poparte zrozumiałymi powodami i dowodami, dzięki czemu można je przeglądać i kwestionować)

- Kompetencja (nadzór poprawia ogólną wydajność i sprawiedliwość systemu, unikając tępych nadpisań, które degradowałyby poprawne wyniki AI)

Warunki agencji i nadzoru

Artykuł odnosi się do warunków agencji (indywidualność, źródło działania, celowość i zdolność adaptacji) jako ram do projektowania skutecznego nadzoru ludzkiego zarówno w czasie projektowania, jak i w czasie wykonywania. Możesz przeczytać więcej o tych warunkach w innym artykule - Agencja jest zależna od ram

Przyjrzyjmy się każdemu z tych warunków - i praktycznym wskazówkom dotyczącym projektowania nadzoru ludzkiego związanym z każdym z nich, które artykuł oferuje twórcom systemów.

Indywidualność

Ten warunek wymaga wyraźnej granicy między rolą AI (agencja operacyjna) a rolą człowieka (agencja oceniająca). Tutaj musimy stworzyć plan interakcji człowiek-AI, w którym AI powinna mieć swobodę autonomicznej pracy, a człowiek powinien interweniować tylko w określonych, dobrze zdefiniowanych punktach kontrolnych. Zacieranie tych granic rozmywa odpowiedzialność.

Czas projektowania

- Zdefiniuj granice systemu i ustaw jawne punkty przekazania do interwencji człowieka.

Gdzie kończy się praca AI? Nie tylko “System będzie obsługiwał obsługę klienta”, ale “System będzie odpowiadał na pytania klientów dotyczące specyfikacji produktów z predefiniowanej bazy wiedzy. Nie będzie obsługiwał sporów dotyczących rozliczeń ani zwrotów.”

- Dodaj warunki wstrzymania się od głosu (odmowa odpowiedzi na zapytanie), gdy system musi oznaczyć sprawę do interwencji człowieka zamiast zgadywać

Na przykład, gdy wynik pewności < 90%, system zasygnalizuje człowiekowi, że działa w “szarej strefie”.

- Zdefiniuj z góry określone punkty przekazania przez człowieka - gdzie kontrola przechodzi z AI na człowieka.

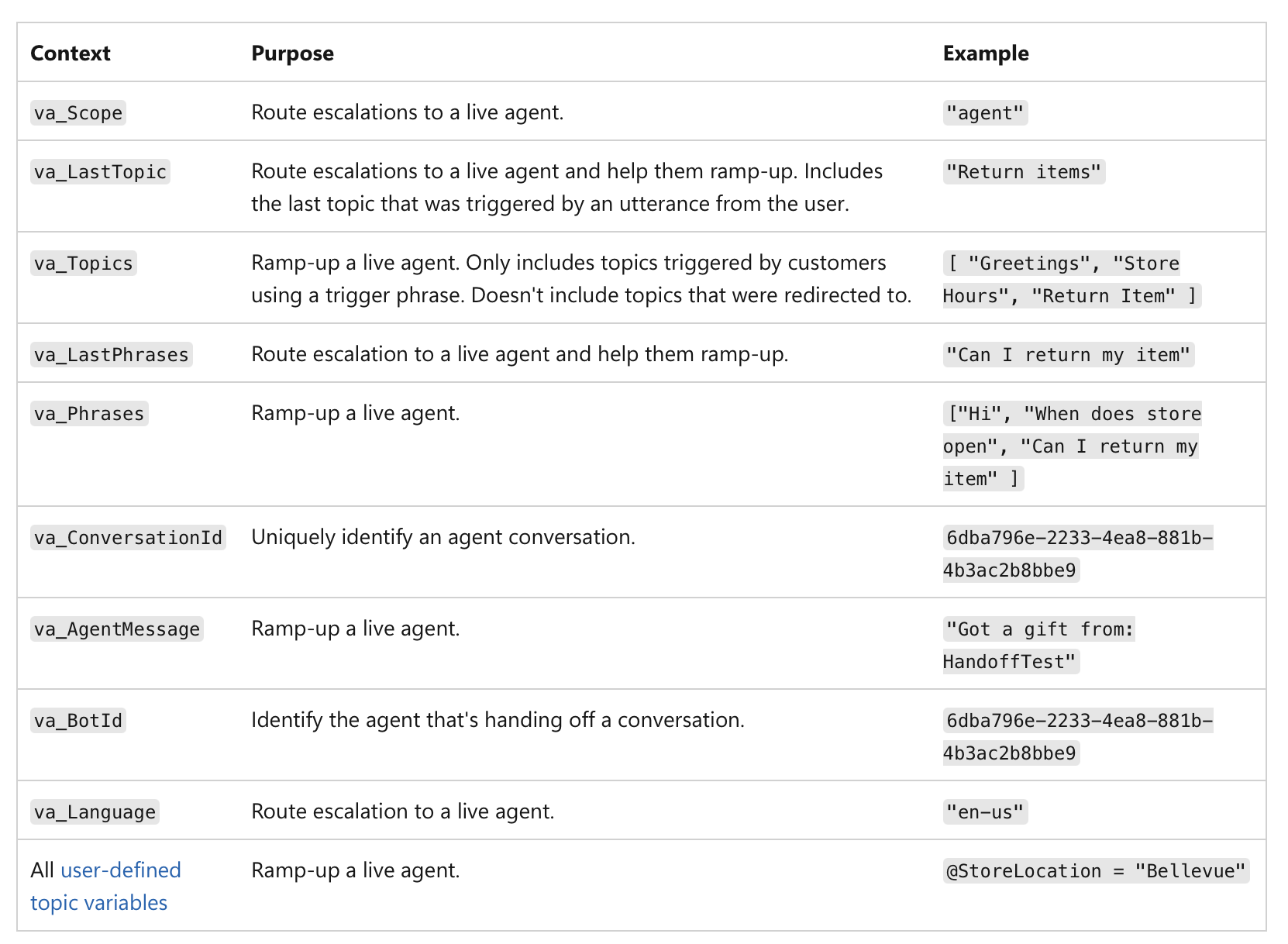

Nie chodzi tylko o niski wynik pewności, ale o znaczenie samej akcji. Na przykład, nawet jeśli AI jest w 99% pewna, jeśli decyzja dotyczy transakcji finansowej powyżej 1 miliona dolarów lub krytycznej diagnozy medycznej, wysokie ryzyko zadania czyni je obowiązkowym punktem kontrolnym dla człowieka. Oto przykład, jak można zaimplementować przekazanie przez człowieka w agentach MS Copilot:

(źródło)

(źródło)

Czas wykonywania

Gdy system jest już uruchomiony, uwaga skupia się na logowaniu i odpowiedzialności.

- Rejestruj, kiedy kontrola faktycznie przechodzi z AI na człowieka.

Twój system musi tworzyć niezmienny zapis (np. na blockchainie lub w bazie danych jednokrotnego zapisu - aby zapobiec manipulacji) każdego przekazania: dziennik powinien zawierać znacznik czasu, ostatnią akcję AI i tożsamość człowieka, który przejął kontrolę:

“Wniosek o pożyczkę nr 12345 przekazany analitykowi ludzkiemu Mary Smith o godzinie 10:30 z powodu wyniku kredytowego poniżej progu.”

Zapewnia to jasną odpowiedzialność za ostateczną decyzję.

Zarejestrowane dane mogą być wykorzystywane do tworzenia pulpitów nawigacyjnych i raportów do nadzoru - można zobaczyć, jak często dochodzi do interwencji człowieka, czy zalecenia AI są akceptowane czy odrzucane, i kto podejmuje ostateczne decyzje. Pomaga to zidentyfikować obszary, w których wydajność AI może być słaba lub gdzie procesy ludzkie wymagają udoskonalenia.

Źródło działania

Tutaj śledzimy przyczynę wyniku. Proces generatywny AI jest często nieprzejrzysty, więc próba “współposiadania” go poprzez skrupulatne tworzenie podpowiedzi może być tylko iluzją kontroli. Zamiast tego, ludzki nadzór powinien skupić się na ocenie ostatecznego wyniku poprzez przegląd historii przyczynowej (podpowiedzi, dane wejściowe, wywołania AI) (znanej również jako proweniencja).

Czas projektowania

-

Upewnij się, że system może przechwycić pełny zapis swojej proweniencji poprzez kompleksowe logowanie (niezmienne i ustandaryzowane do odczytu maszynowego), gdzie każdy krok w przepływie pracy AI jest automatycznie logowany i opatrzony znacznikiem czasu:

- użyte dane wejściowe i podpowiedź

- konkretna wersja modelu AI użyta do wygenerowania wyniku

- pełna historia ludzkich instrukcji i modyfikacji

- wszelkie zewnętrzne wywołania, usługi zewnętrzne, interfejsy API, bazy danych, do których system AI miał dostęp

- pośrednie wyniki, które system wygenerował, ale ostatecznie odrzucił

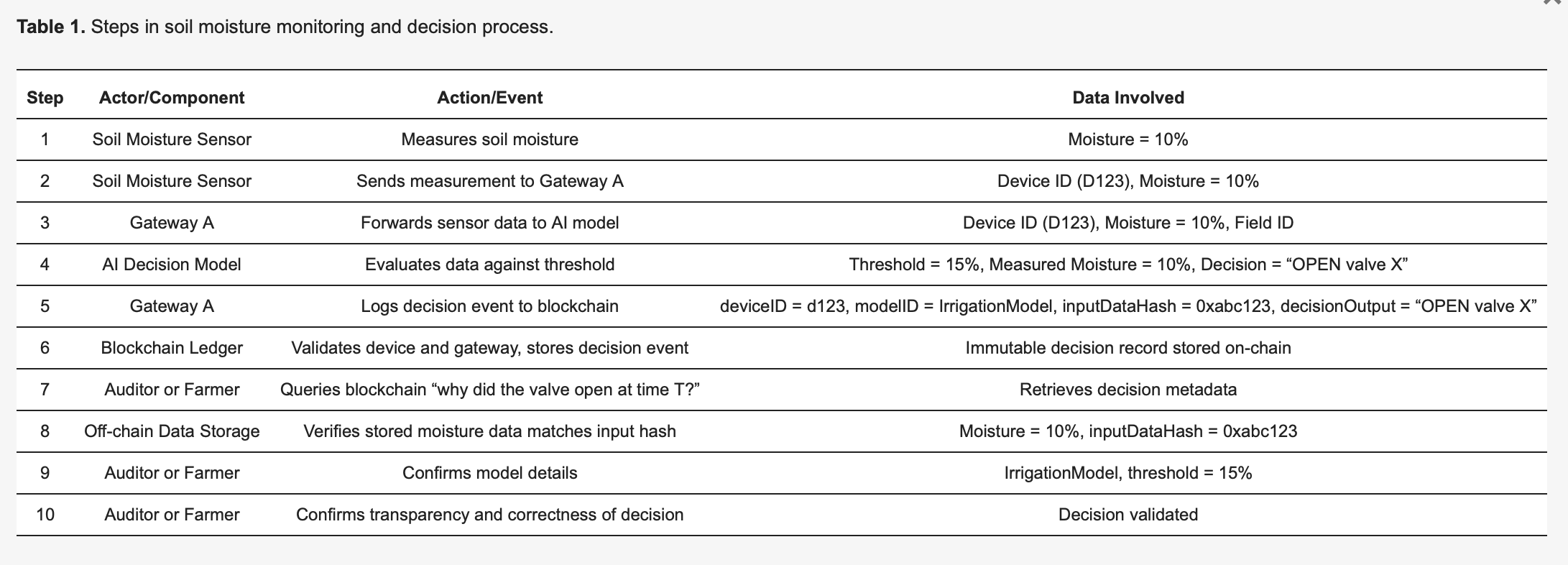

Ten preprint “Using Blockchain Ledgers to Record the AI Decisions in IoT”, na przykład, omawia, jak można to zrobić w praktyce: https://www.preprints.org/manuscript/202504.1789/v1 Oto jeden przykład z tego preprintu:

Aby uczynić metodologię konkretną, rozważmy inteligentny system nawadniania oparty na IoT [27], szczegółowo opisany w Tabeli 1. Czujniki wilgotności gleby (urządzenia) wysyłają odczyty do modelu AI na brzegu sieci, który decyduje, czy zawory wodne powinny się otworzyć, czy pozostać zamknięte. Każda decyzja podjęta przez AI wyzwala zdarzenie logowania przechwytywane niezmiennie w rejestrze blockchain, co zwiększa przejrzystość i możliwość audytu. Jak zilustrowano w Tabeli 1, Czujnik 123 wykrywa wilgotność na poziomie 10 procent i przesyła ten pomiar do Bramy A. Brama A przekazuje dane do modelu AI, który, ze względu na predefiniowany próg 15 procent (określony przez IrrigationModelv2), określa odpowiednie działanie: “zawór = OTWARTY” dla pola X. Brama A następnie przygotowuje transakcję zawierającą krytyczne metadane - w tym deviceID (123), modelID (IrrigationModelv2), skrót danych wejściowych (0xabc123) i wynik decyzji (OTWARTY zawór X) - podpisuje ją i przesyła do blockchaina. Węzły blockchain weryfikują autentyczność i uprawnienia Czujnika 123 i Bramy A, potwierdzają, że są one prawidłowo zarejestrowane dla pola X, a następnie trwale przechowują zapis. Emitowane jest zdarzenie wskazujące na pomyślne zalogowanie. Później audytor lub rolnik może zapytać “dlaczego woda została uwolniona o czasie T?”, pobierając szczegółowy zapis transakcji z blockchaina. Skrót (0xabc123) z blockchaina można następnie porównać z danymi czujników przechowywanymi poza łańcuchem (przechowywanymi na IPFS lub w bazie danych Bramy A), aby potwierdzić, że odczyt wilgotności rzeczywiście wynosił 10 procent. Dodatkowo, odwołując się do rejestru modeli, rolnik może zweryfikować, że próg nawadniania został ustawiony na 15 procent wilgotności, co potwierdza, że decyzja AI była prawidłowa i uzasadniona. Ten ustrukturyzowany proces znacznie zwiększa przejrzystość: każde zautomatyzowane działanie jest weryfikowalne i w pełni wyjaśnialne za pomocą zalogowanych metadanych, a niezmienność blockchaina zapewnia, że ani operatorzy farm, ani producenci urządzeń nie mogą potajemnie modyfikować dzienników decyzji.

Czas wykonywania

- Sprawdź łańcuch przyczynowy dla konkretnego przypadku, aby zobaczyć, jak został wygenerowany wynik.

- Użyj wizualnego pulpitu nawigacyjnego, który mapuje cały łańcuch przyczynowy dla konkretnego wyniku, aby zobaczyć ostateczny rezultat i każdy krok, który do niego doprowadził.

Gdy chcesz przejrzeć decyzję, możesz pobrać zapis proweniencji dla tego konkretnego przypadku. Nie musisz rozumieć wewnętrznej “ścieżki generatywnej” AI (złożonej matematyki i aktywacji neuronowych). Zamiast tego sprawdzasz metadane proweniencji, aby odpowiedzieć na pytania takie jak te:

“Czy użyto właściwych danych?”

Na przykład, gdy lekarz pobiera zapis proweniencji, metadane pokazują listę konkretnych punktów danych, których użyła AI. Zapis proweniencji potwierdza, że AI użyła pełnej historii medycznej pacjenta, niedawnego badania krwi z 24.10.25 i rezonansu magnetycznego z 26.10.25, a wszystkie punkty danych zgadzają się z oficjalną dokumentacją medyczną. W innym przypadku lekarz może stwierdzić, że zapis proweniencji pokazuje, że AI uzyskała dostęp do danych z badania krwi sprzed dwóch lat, ale karta pacjenta została zaktualizowana o nowe wyniki w zeszłym tygodniu, a AI użyła nieaktualnych informacji.

“Czy podpowiedź człowieka została dokładnie przetworzona?”

Podpowiedź lekarza do AI brzmiała: “Przeanalizuj objawy i zalec diagnozę dla 45-letniego mężczyzny z uporczywym kaszlem i gorączką”. Zapis proweniencji rejestruje dokładne zapytanie, które otrzymała AI. Lekarz porównuje to ze swoim pierwotnym wkładem i zauważa, że zarejestrowane zapytanie pokazuje, że podpowiedź została obcięta, brakowało objawu “gorączka” - więc AI przetworzyła tylko “uporczywy kaszel”, co doprowadziło do innej ścieżki diagnostycznej.

“Czy wdrożono prawidłową wersję modelu?”

Zapis proweniencji może pokazać, że diagnoza została wygenerowana przez starszą wersję modelu, która powinna zostać wycofana z powodu błędu systemowego.

Tutaj system wyraźnie przypisuje działania albo autonomicznemu generowaniu przez AI, albo konkretnej interwencji człowieka. Pozwala to na jasną odpowiedzialność. Jeśli zostanie podjęta zła decyzja, szybkie sprawdzenie dziennika proweniencji może ujawnić, czy był to wadliwy wynik AI, czy błąd w ocenie człowieka, co zapobiega “grze w obwinianie”, w której agencja jest rozproszona.

Celowość

AI powinna obsługiwać podcele niskiego poziomu, podczas gdy ludzie zachowują władzę nad celami wysokiego poziomu. Rolą człowieka jest zapewnienie, że wybrana przez AI ścieżka jest zgodna z szerszymi celami i ograniczeniami, takimi jak wymogi prawne lub cele sprawiedliwości.

Czas projektowania

- Jawnie opublikuj cele wysokiego poziomu, ograniczenia i zasady kompromisu dla AI.

Cele najwyższego poziomu, zdefiniowane przez człowieka, są jasne i dostępne. To nie są tylko niejasne deklaracje misji; są to namacalne, często liczbowe, cele. Dla AI logistycznej może to być “zminimalizowanie czasu dostawy o 15% bez zwiększania kosztów paliwa”. Dla AI rekrutacyjnej celem najwyższego poziomu może być “zwiększenie liczby kwalifikowanych aplikacji o 20% przy jednoczesnym zapewnieniu braku uprzedzeń rasowych lub płciowych w pozyskiwaniu kandydatów”.

- Zdefiniuj ograniczenia i zasady kompromisu.

Władza ludzka wyraża się poprzez granice i zasady. AI powinna otrzymać wyraźne ograniczenia, których nie może naruszyć. Na przykład, “pozostań w ramach budżetu prawnego”, “nie zalecaj żadnych działań naruszających przepisy o ochronie prywatności” lub “priorytetyzuj sprawiedliwość nad czystą wydajnością”. W przypadkach, gdy cele są sprzeczne (np. szybkość vs. koszt), zdefiniowane przez człowieka zasady kompromisu muszą dyktować, który z nich ma pierwszeństwo.

Czas wykonywania

Tutaj uwaga przenosi się na monitorowanie i ocenę. Człowiek nie musi znać każdego pojedynczego kroku obliczeniowego, ale może zobaczyć, czy ogólny kierunek AI jest zgodny z celem wyższego poziomu. Możemy oceniać postępy w określonych, z góry zdefiniowanych punktach.

- Sprawdź, czy bieżący wynik i podcele AI są zgodne z tymi zadeklarowanymi celami.

Na przykład, finansowa AI może mieć pozwolenie na uruchomienie wielu symulacji w celu optymalizacji portfela (podcele), ale ludzki analityk musi zatwierdzić ostateczną strategię, aby upewnić się, że jest ona zgodna z tolerancją na ryzyko klienta i wymogami prawnymi (cele najwyższego poziomu). Ten proces pozwala AI wykorzystać swoją “agencję operacyjną” do eksploracji rozwiązań, podczas gdy człowiek zachowuje “agencję oceniającą”, aby zapewnić, że kierunek AI pozostaje legalny.

- Upewnij się, że system jest zaprojektowany do ciągłego monitorowania i raportowania swoich postępów w realizacji swoich podcelów.

Dla AI generującej treści może to obejmować raportowanie o próbach znalezienia określonych słów kluczowych lub strategii strukturyzacji artykułu.

- System powinien tworzyć jasny, możliwy do prześledzenia zapis swoich decyzji, w tym dlaczego dążył do określonego podcelu. Ten zapis jest udostępniany ludzkiemu oceniającemu.

Jeśli AI wygeneruje stronniczy wynik, audytor może prześledzić jego ścieżkę i zobaczyć, gdzie zaczął odbiegać od ograniczeń sprawiedliwości zdefiniowanych na etapie projektowania.

Zdolność adaptacji

Człowiek nie jest w stanie w sposób wykonalny nadzorować każdej drobnej wewnętrznej zmiany, jaką wprowadza AI. Ludzki nadzór powinien być ukierunkowany na znaczące zmiany, takie jak zmiany w polityce lub ogólnym zachowaniu systemu. Chodzi o stworzenie barierek dla adaptacyjnego zachowania AI.

Czas projektowania

- Skonfiguruj kontrole zmian i monitory dryftu, które wykrywają znaczące zmiany w zachowaniu.

System powinien być zaprojektowany tak, aby wersjonować własne modele i konfiguracje, aby umożliwić powrót do poprzedniej, stabilnej wersji, jeśli coś pójdzie nie tak.

Monitory dryftu to narzędzia, które stale śledzą wydajność i zachowanie AI w świecie rzeczywistym. Nie mierzą one tylko dokładności; szukają dryftu koncepcji (gdy zmienia się związek między danymi wejściowymi a wyjściowymi) i dryftu danych (gdy zmieniają się same dane wejściowe). Monitory są ustawione z określonymi progami. Na przykład, monitor dryftu AI do wykrywania oszustw może być ustawiony tak, aby ostrzegał człowieka, jeśli jego wskaźnik fałszywych alarmów wzrośnie o więcej niż 5%.

Czas wykonywania

Gdy system jest już uruchomiony, ludzie nie obserwują go stale. Są oni ostrzegani przez zautomatyzowane monitory, co pozwala im skutecznie skupić swoją uwagę. Gdy próg monitora dryftu zostanie przekroczony, automatycznie wysyła on alert do zespołu ludzkiego. Alert powinien zawierać migawkę zaobserwowanego zachowania i odpowiednie dane, aby człowiek mógł szybko ocenić sytuację. System może być również wstępnie zaprogramowany do postępowania zgodnie z określonym protokołem po wykryciu zmiany.

Co zyskam, jeśli wdrożę te ramy?

Takie podejście tworzy potężne partnerstwo, w którym system AI i “nadzorujący” człowiek mają odrębne, cenne role. AI ma swobodę wykorzystywania swojej mocy obliczeniowej do rozwiązywania złożonych problemów (swoja “agencja operacyjna”), podczas gdy człowiek, korzystając z wyraźnych sygnałów z systemu, jest upoważniony do podejmowania świadomych, wysokopoziomowych decyzji i interweniowania w razie potrzeby (swoja “agencja oceniająca”). Rezultatem jest współpraca “o sumie niezerowej”, w której połączony wysiłek prowadzi do lepszych wyników, niż człowiek lub AI mogliby osiągnąć samodzielnie.

Jak te ramy odnoszą się do Art. 14 Ustawy o AI?

Ramy te bezpośrednio odnoszą się do wymogów Ustawy o AI UE, w szczególności Artykułu 14, oferując praktyczne, wykonalne podejście do “skutecznego nadzoru ludzkiego”, które wykracza poza abstrakcyjne zasady. Definiuje nadzór nie jako niejasne zobowiązanie, ale jako systematyczny proces projektowania AI w celu wspierania ludzkiej agencji oceniającej.

Czego wymaga Ustawa o AI od twórców systemów AI?

- “Odpowiednie narzędzia interfejsu człowiek-maszyna… mogą być skutecznie nadzorowane.”

Podstawową zasadą ram jest to, że sam system AI musi być zbudowany tak, aby umożliwiał nadzór. Ramy zaproponowane w artykule oferują fundamentalne cechy projektowe, które zapewniają, że działanie systemu jest przejrzyste i możliwe do zarządzania przez człowieka.

- “Dążyć do zapobiegania lub minimalizowania ryzyka.”

Nacisk ram na agencję oceniającą bezpośrednio odnosi się do tego. Rolą człowieka jest zapewnienie “osądu wyższego rzędu”, który zakotwicza działania AI w standardach zawodowych i społecznych. Jest to mechanizm zapobiegania ryzyku, którego AI, działając w ramach swojej agencji operacyjnej, może nie wykryć. Kontrole na etapie projektowania ram (np. ustalanie celów sprawiedliwości, identyfikowanie decyzji wysokiego ryzyka) zapewniają, że zapobieganie ryzyku jest celową częścią architektury systemu, a nie czymś dodanym na końcu.

- “Środki… wbudowane w system AI wysokiego ryzyka.”

Cała struktura ram jest zbudowana wokół tego wymogu. “Artefakty AI do ujawnienia” i “Powierzchnia weryfikacji systemu” dla każdego warunku są przykładami środków, które są “wbudowane… w system AI wysokiego ryzyka przez dostawcę”.

Warunek indywidualności wymaga, aby system był zaprojektowany z wyraźnymi umowami API dotyczącymi przekazywania. Warunek zdolności adaptacji wymaga wbudowanych monitorów dryftu i mechanizmów wycofywania. Są to wszystko konkretne środki wdrożone przez dostawcę.

Ramy te prowadzą również dostawcę w identyfikowaniu środków dla wdrażającego. Na przykład, warunek źródła działania wymaga od dostawcy udostępnienia wdrażającemu pulpitu nawigacyjnego proweniencji, co jest kluczowym środkiem do wdrożenia i wykorzystania przez wdrażającego.

- “Nadzór ludzki… umożliwiony, w stosownych przypadkach i proporcjonalnie.” Ramy te bezpośrednio przekładają każdy punkt tego podartykułu na wymóg projektowy.

a) “Właściwie rozumieć odpowiednie zdolności i ograniczenia”

Warunki indywidualności i celowości odnoszą się do tego, wymagając jawnej dokumentacji granic, celów i ograniczeń AI. Zapewnia to człowiekowi jasne zrozumienie możliwości AI.

b) “Pozostać świadomym… stronniczości automatyzacji”

Ramy promują agencję oceniającą jako przeciwwagę dla stronniczości automatyzacji. Nacisk na sprawdzanie wyników AI, a nie tylko ich akceptowanie, zmusza człowieka do pozostania zaangażowanym i zapewnia mechanizm do unieważnienia AI w razie potrzeby.

c) “Prawidłowo interpretować… wynik”

Warunek źródła działania zapewnia, że wynik AI jest opatrzony interpretowalnymi metadanymi i zapisami proweniencji. Umożliwia to człowiekowi prawidłową interpretację kontekstu i łańcucha przyczynowego wyniku, co umożliwia podjęcie prostego osądu.

d) “Zdecydować… nie używać… lub zignorować… wynik”

Warunek indywidualności bezpośrednio to wspiera, wymagając jawnych punktów przekazania i mechanizmów “odmów odpowiedzi i przekaż człowiekowi”, co upoważnia człowieka do wkroczenia i unieważnienia systemu.

e) “Interweniować… lub przerwać… za pomocą przycisku ‘stop’”

Mechanizmy wycofywania i wstrzymywania się od głosu w warunku zdolności adaptacji zapewniają funkcjonalny odpowiednik przycisku “stop”. Umożliwiają one człowiekowi zatrzymanie lub cofnięcie działania AI w bezpieczny i kontrolowany sposób.

f) “Weryfikacja przez co najmniej dwie osoby fizyczne.”

Ramy te dostarczają narzędzi, aby uczynić to wykonalnym i znaczącym procesem. Zapis proweniencji warunku źródła działania i jasny dziennik wszystkich interakcji ludzkich ułatwiają dwóm lub więcej osobom niezależną weryfikację identyfikacji AI. Obie mogą pobrać ten sam zestaw zarejestrowanych danych i przejrzeć łańcuch przyczynowy, aby osiągnąć konsensus, zapewniając, że weryfikacja opiera się na obiektywnych dowodach, a nie na subiektywnych domysłach.

Wyzwania

Oczywiście, chociaż ramy wyglądają bardzo obiecująco i mają zastosowanie, artykuł nie ignoruje powszechnych wad wdrażania mechanizmów nadzoru.

Złożoność i koszty

Po pierwsze, nie wszystkie z nich są proste w konfiguracji - wiele wymaga znacznego wysiłku z góry w celu zaprojektowania i zbudowania. Potrzebujesz specjalistycznej wiedzy, aby tworzyć systemy, które mogą generować ustrukturyzowane uzasadnienia, przechwytywać proweniencję lub kodować zniuansowane reguły w rejestrze celów. Poza tym, przygotuj się na bieżące koszty utrzymania systemu, kalibracji sygnałów i szkolenia ludzkich recenzentów w zakresie nowych procesów.

Zależność od sygnału

Skuteczność tych mechanizmów nadzoru jest w dużym stopniu zależna od jakości sygnałów, które wytwarzają. Jeśli AI generuje słabe lub zaszumione sygnały (np. niedokładne wyniki pewności, niejasne uzasadnienia lub wadliwe dane proweniencji), może to wprowadzić w błąd ludzkiego recenzenta i podważyć cały proces nadzoru.

Obciążenie weryfikacją

Chociaż celem jest poprawa wydajności, systemy te nie eliminują całkowicie obciążenia pracą człowieka. W przypadkach granicznych, nowych lub niejednoznacznych, ludzki recenzent może nadal potrzebować intensywnych, ręcznych kontroli wyrywkowych. Artykuł zauważa, że może to zmniejszyć zyski z wydajności, ponieważ recenzenci mogą potrzebować spędzić dużo czasu na rozwiązywaniu wstrzymań lub kwestionowaniu sugestii AI. Obciążenie ludzkie przenosi się z oceny na pełną skalę na szczegółową weryfikację pracy AI, co nadal może być znaczące.

Pamiętaj: potrzebna jest zmiana sposobu myślenia

Nie wystarczy więc po prostu powiedzieć, że potrzebujemy “ludzkiego nadzoru”. Aby to urzeczywistnić, musimy zmienić nasz sposób myślenia z prostego “nadzorowania AI” na projektowanie AI do współpracy człowiek-AI: na nowo zdefiniować rolę człowieka jako aktywnego oceniającego, wbudować nadzór w projekt AI, pamiętać o trzech C - kontroli, możliwości zakwestionowania i kompetencji - a wtedy nie tylko będziesz przestrzegać przepisów, takich jak Ustawa o AI - będziesz tworzyć bardziej godny zaufania i potężny system, który współpracuje z ludźmi.