Menselijk toezicht op AI

Menselijk toezicht in AI-systemen is een nalevingsvereiste:

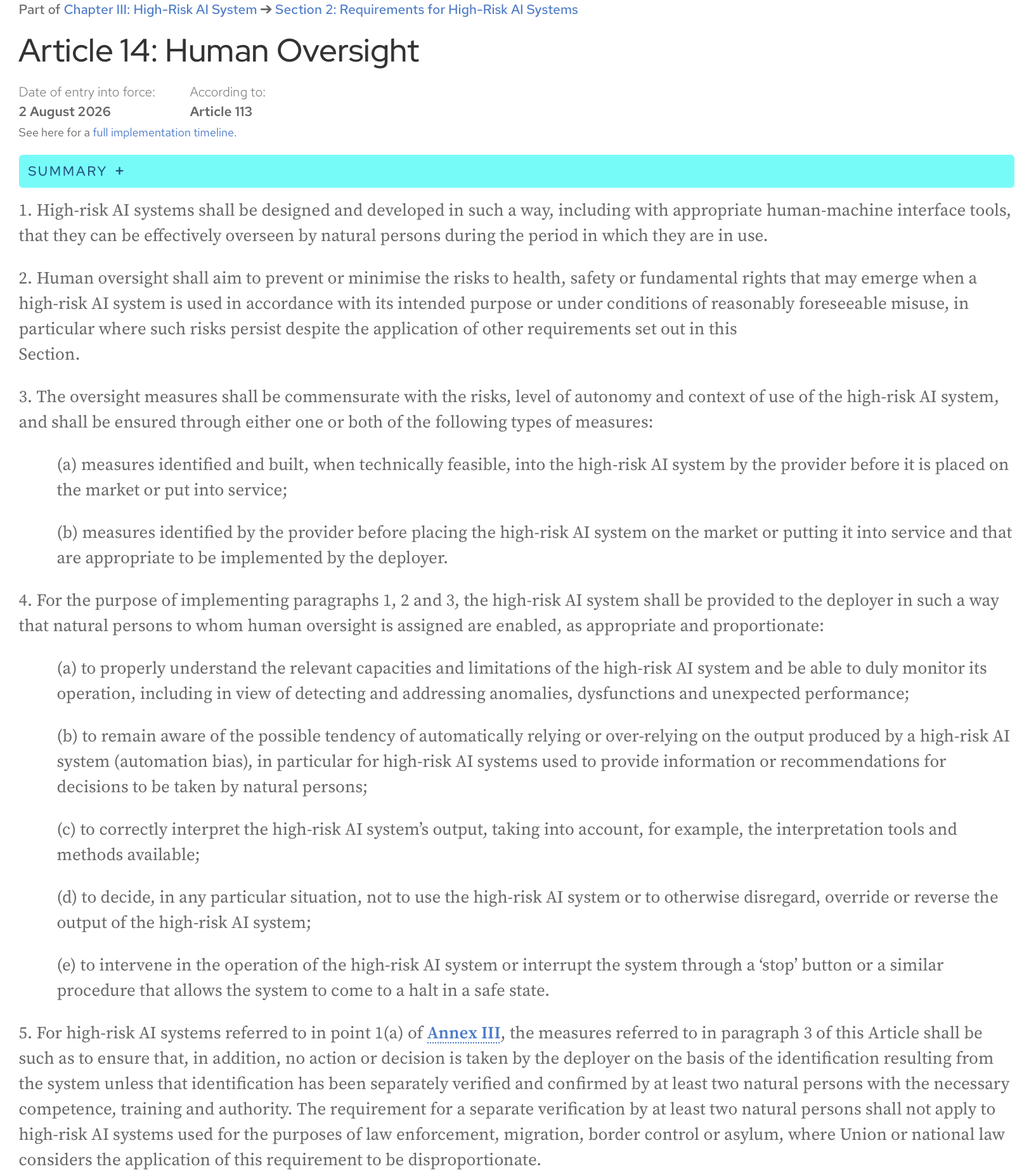

AI Act, Artikel 14: Hoogrisico-AI-systemen moeten zodanig worden ontworpen en ontwikkeld, inclusief met passende mens-machine-interfacetools, dat ze effectief kunnen worden overzien door natuurlijke personen gedurende de periode waarin ze in gebruik zijn.

Hier is de volledige tekst van het artikel van de officiële AI Act-webpagina:

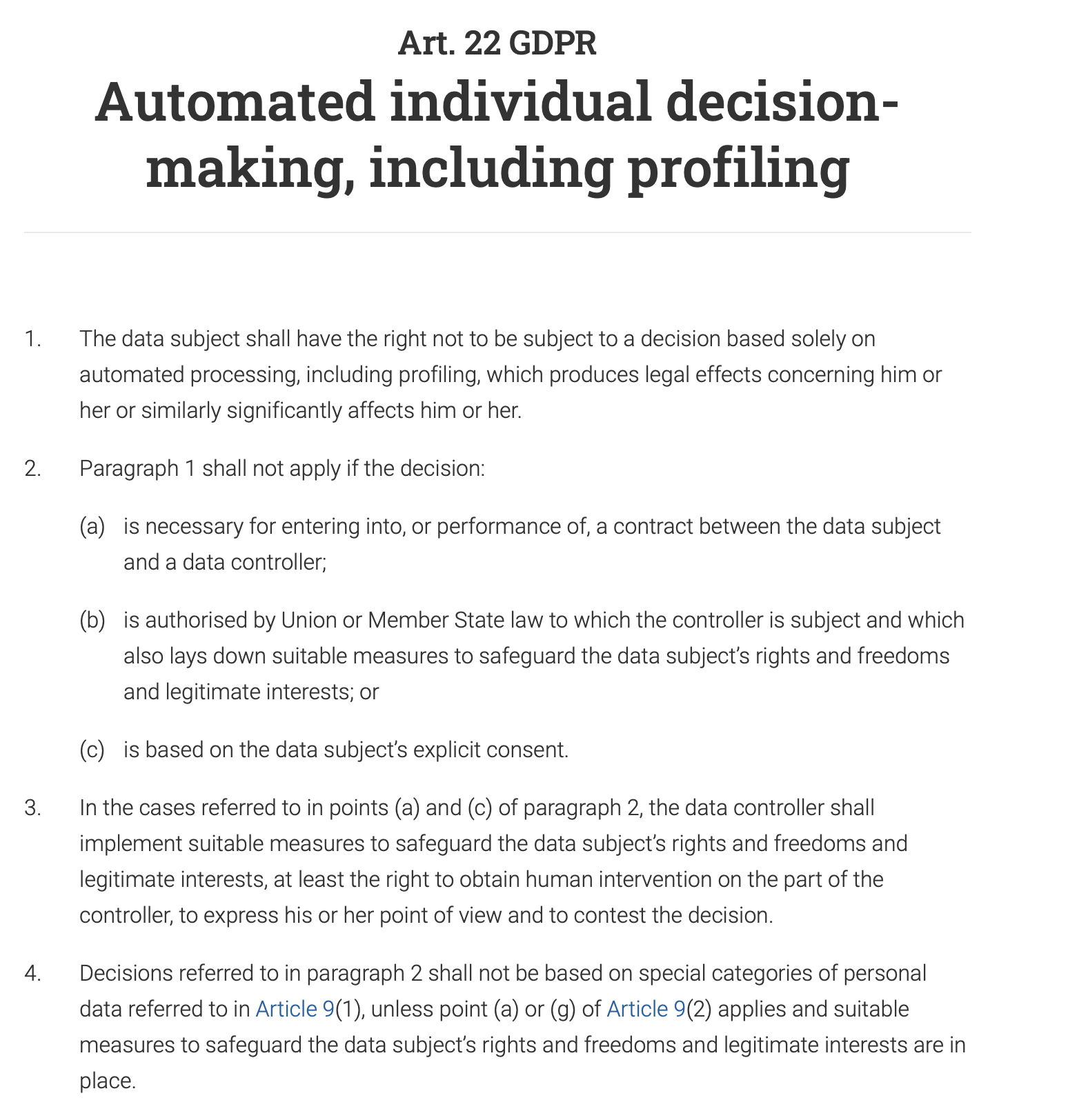

Artikel 22 van de GDPR geeft individuen expliciet het recht “om niet te worden onderworpen aan een besluit dat uitsluitend is gebaseerd op geautomatiseerde verwerking, met inbegrip van profilering, dat rechtsgevolgen voor hem of haar heeft of hem of haar op vergelijkbare wijze aanzienlijk treft.” Dit betekent dat voor elk geautomatiseerd besluitvormingssysteem dat een grote impact heeft op een individu (bijv. het weigeren van een leningaanvraag, een baanaanbod of een openbare uitkering), een mens bij het proces betrokken moet zijn om het besluit te herzien en te valideren. Het individu heeft ook het recht om het geautomatiseerde besluit aan te vechten en menselijke tussenkomst te verkrijgen.

En, niet onverwacht, is menselijk toezicht een belangrijke vereiste in zowel de ISO 42001 als het NIST AI Risk Management Framework (AI RMF). Beide raamwerken, hoewel verschillend in hun aanpak, benadrukken de noodzaak van menselijke tussenkomst om het verantwoorde en ethische gebruik van AI-systemen te waarborgen.

Dit bericht is mijn interpretatie van het paper dat werd gepresenteerd tijdens de recente sessie van de maandelijkse Data61 AI Adoption and Assurance Chat - “Designing meaningful human oversight in AI” (https://www.researchgate.net/publication/395540553_Designing_Meaningful_Human_Oversight_in_AI).

(de volledige citatie voor het paper: Zhu, Liming & Lu, Qinghua & Ding, Ming & Lee, Sunny & Wang, Chen & Data, & Csiro, & Australia,. (2025). Designing Meaningful Human Oversight in AI. 10.13140/RG.2.2.16624.11528)

Het paper bespreekt het probleem met de huidige aanpak van menselijk toezicht en presenteert praktische tips voor ontwikkelaars van AI-systemen.

Wat is menselijk toezicht en hoe wordt het gedaan?

Het probleem met menselijk toezicht is dat het slecht gedefinieerd is. Maar naar mijn mening, wat alles gecompliceerder maakt, is onze natuurlijke automatiseringsbias - een neiging om de output van een machine meer te vertrouwen dan ons eigen oordeel. Hoe vaak heb je blindelings een GPS gevolgd naar een niet-bestaande weg?

Als gevolg daarvan keuren we de output van het systeem goed zonder het goed te begrijpen (“rubber-stamp” het).

Bijvoorbeeld, het AI-systeem van een bank kan uw transactie als hoog risico markeren, en een menselijke analist, die dagelijks duizenden van dergelijke waarschuwingen moet beoordelen, keurt automatisch de beslissing van de AI goed en bevriest uw account.

Het tegenovergestelde scenario is ook gebruikelijk: we beperken het systeem zozeer dat we, in plaats van het een hoog niveau doel en enige vrijheid te geven om compromissen te verkennen en te vinden, proberen elke afzonderlijke actie die het moet ondernemen vooraf te programmeren en het zo te reduceren tot een op regels gebaseerd automatiseringssysteem.

Een bedrijf wil dat een AI-chatbot vragen van klanten afhandelt. In plaats van het een hoog niveau doel te geven zoals “los het probleem van de klant beleefd en efficiënt op”, programmeer je het met een rigide script dat dicteert dat als een klant vraagt: “Hoe kan ik een product retourneren?”, de bot moet reageren met een link naar de retourpagina en dan vragen: “Heeft dit uw vraag beantwoord?” Het kan geen genuanceerde vragen aan zoals: “Ik ben mijn kassabon kwijt, kan ik dit nog steeds retourneren?” omdat de regels dat specifieke scenario niet dekken. De chatbot verliest zijn agentische kwaliteit en wordt een basale, frustrerende beslisboom.

Het paper stelt dat geen van deze scenario’s optimaal is, en dat menselijke agency en AI-agency geen nulsomspel zijn. Samenwerking van de twee levert betere resultaten op dan elk afzonderlijk zou kunnen bereiken.

Hoe kan menselijk toezicht worden ontworpen om deze samenwerking mogelijk te maken?

Twee soorten agency

Laten we beginnen met de definitie van agency: het is het vermogen om actie te ondernemen en dingen zelf te laten gebeuren, om een doel te bereiken.

Het paper stelt voor om onderscheid te maken tussen de twee soorten agency:

- Operatieve agency (het vermogen van de AI om oplossingen te genereren)

Bijvoorbeeld, een medisch AI-systeem genereert een diagnose.

- Evaluatieve agency (het vermogen van de mens om de oplossing van de AI te begrijpen, te beoordelen, te verifiëren en waar nodig de resultaten ervan te sturen of te vervangen door alternatieve oplossingen)

Een arts repliceert het diagnostische proces niet. Het is niet de taak van een arts om het werk van de AI over te doen of de machine te slim af te zijn. In plaats daarvan is hun rol het evalueren van de diagnose van de AI. De arts vraagt: “Is dit logisch? Is de redenering van de AI consistent met wat een verantwoordelijke menselijke expert zou doen?” Ze controleren op consistentie. Ze beoordelen de redenering van de AI, die een lijst van belangrijke symptomen en een verwijzing naar medische literatuur kan zijn. De arts verifieert dat deze redenering overeenkomt met hun eigen opleiding en medische normen. Ze voegen ook menselijke context toe: wetende dat de behandeling voor een zeldzame ziekte een dure, pijnlijke en intensieve therapie van een jaar is, houden ze rekening met de voorkeuren van de patiënt, de financiële situatie en of ze bereid zijn zich aan zo’n moeilijk regime te binden. Ten slotte wegen ze de potentiële voordelen van de behandeling af tegen de aanzienlijke last en beslissen ze of dit de meest geschikte en ethische handelwijze is, zelfs als de diagnose van de AI technisch correct is.

Het is moeilijk om het niet eens te zijn met de mening van de auteurs dat ‘evalueren’ een beter woord is dan ‘toezicht’ omdat het de menselijke rol als actief en oordelend benadrukt, in plaats van louter toezichthoudend of symbolisch.

Evaluatieve agency zorgt voor verantwoordelijkheid

Als er iets misgaat, is een mens uiteindelijk verantwoordelijk. De AI kan niet voor de rechter worden gedaagd; de persoon die de output ervan heeft geëvalueerd wel. Bovendien verankert het oordeel van de mens de acties van de AI aan professionele, ethische en maatschappelijke normen die de AI zelf niet kan begrijpen. De AI kan de snelste route vinden, maar alleen de mens kan beslissen of die route de meest ethische of veilige is. Deze twee voordelen zijn essentieel voor verantwoorde en betrouwbare AI.

Interne versus externe redeneringstrouw

Hoe kunnen we de output van een systeem evalueren als we de complexe interne werking van moderne AI-modellen nog steeds niet volledig kunnen doorgronden? Elke activering van een neuraal netwerk, elke parameteraanpassing, of hoe de geleerde kennis van het model (zoals het concept van een “kat”) wordt gedistribueerd en opgeslagen in zijn miljoenen of miljarden parameters (het geheugen van het model) - proberen dit algoritmische circuit te begrijpen is in dit stadium van AI-ontwikkeling niet haalbaar, en zelfs als het dat wel was, zou het zijn alsof je naar de beslissingen van een schaakcomputerprogramma kijkt door het prisma van de afzonderlijke berekeningen die het maakt - te veel details, te complex en niet erg nuttig voor het daadwerkelijk evalueren van de beslissingen.

In plaats daarvan kunnen we systemen zo ontwerpen dat ze verklaringen geven die voor een mens logisch zijn - verklaringen gebaseerd op wat het paper “externe redeneringstrouw” of “plausibiliteit” noemt. Een schaakprogramma zou zeggen: “Ik heb deze zet gekozen om het centrum van het bord te beheersen en druk uit te oefenen op de paard van de tegenstander”, en we zouden deze beslissing kunnen evalueren omdat de uitleg ervan overeenkomt met gevestigde schaakprincipes en menselijk oordeel.

Hoe ontwerpen we nu een systeem om dergelijke aanwijzingen te geven die we kunnen evalueren en, indien nodig, aanvechten?

Oplos-verifieer asymmetrie

Het paper introduceert een nuttig concept van oplos-verifieer asymmetrie: de moeilijkheid van het creëren van een oplossing (oplossen) en de moeilijkheid van het controleren van die oplossing (verifiëren) zijn vaak niet gelijk. Dit is het geval zowel tijdens het ontwerp als tijdens de uitvoering, en het begrijpen hiervan helpt bij het creëren van een effectief menselijk toezichtproces.

In de ontwerpfase is de “oplos”-taak de inspanning die nodig is om het AI-systeem te bouwen:

- het creëren van de systeemarchitectuur

- het specificeren van doelstellingen

- het implementeren van het systeem

- het ontwerpen van verificatietaken en drempels om toe te passen op vele toekomstige gevallen

De “verifieer”-taak is de inspanning om dat systeem te evalueren en te valideren voordat het wordt geïmplementeerd:

- beoordeling van vereisten

- evaluatie van architectuur en ontwerp

- testen

- andere vormen van verificatie en validatie

Tijdens de uitvoering kijken we naar individuele gevallen - specifieke outputs van het systeem, specifieke oplossingen die het voorstelt. De “verifieer”-taak hier is het evalueren van deze afzonderlijke outputs. Soms zijn de “oplos”-taken zeer rekenintensief, maar is het controleren van de outputs eenvoudig; er zijn echter gevallen waarin de AI snel een output genereert, maar de mens die toezicht houdt op het systeem veel tijd en moeite zal besteden aan het verifiëren ervan (bijvoorbeeld fact-checking, controleren op bias, zorgen voor afstemming van de inhoud met normen, enzovoort), en verificatie wordt een knelpunt.

De belangrijkste conclusie is dat effectief toezicht zich moet aanpassen aan deze asymmetrie.

Wanneer verificatie tijdens het ontwerp eenvoudig is

Deze strategie gaat over het inbouwen van veiligheid vanaf het allereerste begin. Door het verificatieproces vooraf te laden, kunt u potentiële problemen ondervangen voordat de AI zelfs maar in gebruik wordt genomen, waardoor de noodzaak van constante, handmatige monitoring wordt verminderd.

Bijvoorbeeld, de arm van een fabrieksrobot moet met een hoge mate van precisie en veiligheid werken en altijd binnen zijn aangewezen werkgebied blijven. De verificatie dat het een nabijgelegen menselijke werknemer niet zal schaden, wordt gedaan tijdens de ontwerp- en programmeerfase door middel van uitgebreide tests, modellering en voorgeprogrammeerde veiligheidsparameters. Het doel is om ervoor te zorgen dat het systeem “veilig door ontwerp” is, waardoor real-time menselijke tussenkomst in zijn basisbewegingen onnodig wordt.

Wanneer verificatie tijdens het ontwerp moeilijk is

Dit paper erkent dat sommige AI-taken te complex zijn om volledig te worden geverifieerd tijdens de ontwikkeling. In deze gevallen kan het systeem worden ontworpen om duidelijke, bruikbare informatie te verstrekken aan een menselijke operator, die vervolgens een weloverwogen definitieve beslissing kan nemen. De mens fungeert als het ultieme controlepunt.

Bijvoorbeeld, een AI-systeem dat een diagnose aanbeveelt, voert een zeer complexe taak uit. De nauwkeurigheid ervan kan moeilijk volledig te verifiëren zijn tijdens de ontwikkeling vanwege de oneindige variaties in de menselijke anatomie en ziekte. Daarom moet het systeem worden ontworpen om runtime verificatie te vergemakkelijken: het zal niet alleen een diagnose geven, maar ook een betrouwbaarheidsscore (bijv. “95% waarschijnlijkheid van een goedaardige tumor”), de specifieke gebieden van een scan markeren die tot zijn conclusie hebben geleid, andere relevante citaten toevoegen en een gedetailleerde uitleg van zijn redenering bieden (rationale traces). Een arts kan deze informatie vervolgens gebruiken om de definitieve, weloverwogen diagnose te stellen.

Hoe zit het met subjectieve domeinen waar geen juist antwoord is?

Op gebieden als kunst, ethiek of strategische planning hebben verschillende mensen verschillende waarden en perspectieven. Hier, in plaats van een AI-systeem alle diversiteit te laten “samenvouwen” tot één “correct” antwoord waar er vaak geen is, moeten we AI ontwerpen als een partner in een discussie. Het doel is niet om een perfecte oplossing te krijgen, maar om verschillende perspectieven en scenario’s naar boven te halen. Deze aanpak maakt onenigheid een waardevol onderdeel van het proces, omdat de AI u de verschillende afwegingen en gezichtspunten kan laten zien. Door dit te doen, wordt het systeem meer verantwoordelijk, omdat het u, de mens, dwingt om deze opties actief te overwegen en een doordachte, goed onderbouwde beslissing te nemen op basis van alle beschikbare invalshoeken.

Grens van delegatie

De auteurs van het paper benadrukken dat er een grens is waarboven AI niet langer de primaire beslisser zou moeten zijn - ze noemen dit de “grens van delegatie”. In bepaalde risicovolle gebieden zoals juridische veroordeling, medische diagnose of aanwerving, heeft het uiteindelijke oordeel een aanzienlijk ethisch en normatief gewicht. Deze beslissingen mogen niet volledig aan AI worden gedelegeerd. In deze gevallen gaat toezicht niet alleen over het controleren of de output van de AI correct is. Het gaat over het waarborgen van menselijke verantwoordelijkheid. De AI moet fungeren als een hulpmiddel om de menselijke beslisser te ondersteunen, door gegevens en inzichten te verstrekken, maar nooit volledig hun rol te vervangen. De uiteindelijke beslissing moet bij een mens blijven om ethische en morele verantwoordelijkheid te waarborgen.

3 C’s van efficiënt menselijk toezicht

Wat moeten we bereiken bij het ontwerpen van het AI-toezichtproces?

- Controle (wij mensen kunnen tijdig en effectief ingrijpen om een beslissing van een AI te pauzeren, om te leiden of te vervangen)

- Betwistbaarheid (AI-beslissingen worden ondersteund door begrijpelijke redenen en bewijs, zodat ze kunnen worden beoordeeld en aangevochten)

- Competentie (toezicht verbetert de algehele prestaties en eerlijkheid van het systeem, waarbij botte overschrijvingen worden vermeden die de correcte outputs van de AI zouden verslechteren)

Voorwaarden voor agency en toezicht

Het paper verwijst naar de voorwaarden voor agency (individualiteit, bron van actie, doelgerichtheid en aanpassingsvermogen) als een raamwerk om effectief menselijk toezicht te ontwerpen, zowel tijdens het ontwerp als tijdens de uitvoering. U kunt meer lezen over deze voorwaarden in een ander paper - Agency is Frame-Dependent

Laten we elk van deze voorwaarden bekijken - en de praktische ontwerptips voor menselijk toezicht die verband houden met elk ervan die het paper aan systeemontwikkelaars biedt.

Individualiteit

Deze voorwaarde vereist een duidelijke grens tussen de rol van de AI (operatieve agency) en de rol van de mens (evaluatieve agency). Hier moeten we de blauwdruk creëren voor mens-AI-interactie waarbij de AI vrij moet zijn om autonoom te werken, en de mens alleen moet ingrijpen op specifieke, goed gedefinieerde controlepunten. Het vervagen van deze lijnen verspreidt de verantwoordelijkheid.

Ontwerptijd

- Definieer de grenzen van het systeem en stel expliciete overdrachtspunten in voor menselijke tussenkomst.

Waar eindigt de taak van de AI? Niet alleen “Het systeem zal de klantenservice afhandelen”, maar “Het systeem zal vragen van klanten beantwoorden met betrekking tot productspecificaties uit een vooraf gedefinieerde kennisbank. Het zal geen factureringsgeschillen of terugbetalingen afhandelen.”

- Voeg voorwaarden toe voor onthouding (de weigering om een vraag te beantwoorden) wanneer het systeem een geval moet markeren voor menselijke tussenkomst in plaats van te gokken

Bijvoorbeeld, wanneer de betrouwbaarheidsscore < 90% is, zal het systeem een mens signaleren dat het in een “grijs gebied” opereert.

- Definieer vooraf bepaalde menselijke overdrachtspunten - waar de controle verschuift van de AI naar een mens.

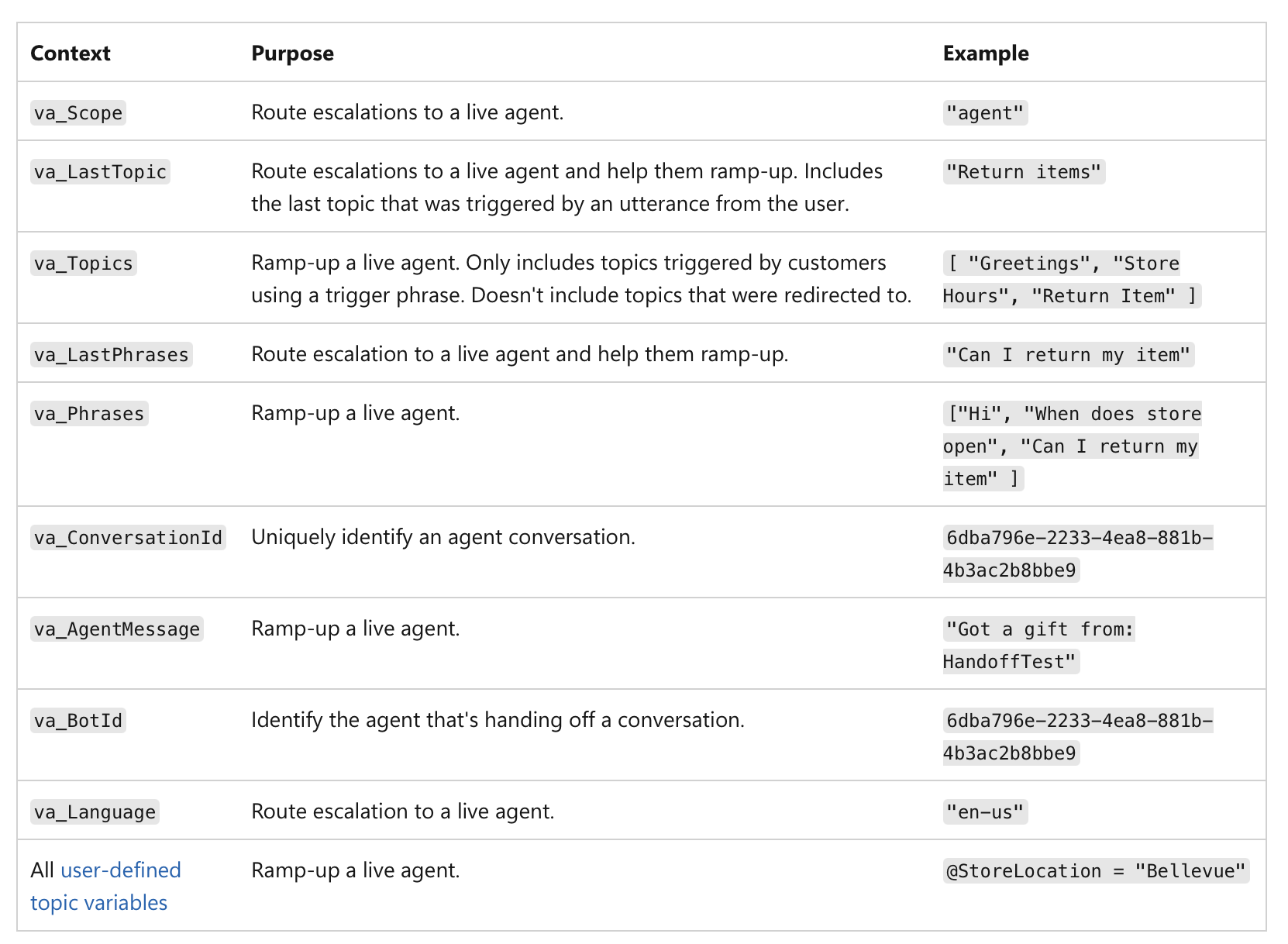

Het gaat niet alleen om een lage betrouwbaarheidsscore, maar om de belangrijkheid van de actie zelf. Bijvoorbeeld, zelfs als een AI 99% zeker is, als de beslissing een financiële transactie van meer dan $1 miljoen of een kritieke medische diagnose betreft, maakt de risicovolle aard van de taak het een verplicht menselijk controlepunt. Hier is een voorbeeld van hoe menselijke overdracht kan worden geïmplementeerd in MS Copilot-agenten:

(bron)

(bron)

Runtime

Zodra het systeem live is, verschuift de focus naar logging en verantwoording.

- Log wanneer de controle daadwerkelijk overgaat van de AI naar de mens.

Uw systeem moet een onveranderlijk record creëren (bijv. op een blockchain of een write-once database - om manipulatie te voorkomen) van elke overdracht: het logboek moet een tijdstempel, de laatste actie van de AI en de identiteit van de mens die de controle overnam bevatten:

“Leningaanvraag #12345 overgedragen aan menselijke analist Mary Smith om 10:30 uur vanwege kredietscore onder de drempel.”

Dit zorgt voor duidelijke verantwoording voor de uiteindelijke beslissing.

De gelogde gegevens kunnen worden gebruikt om dashboards en rapporten voor toezicht te creëren - u kunt zien hoe vaak menselijke tussenkomst plaatsvindt, of de aanbevelingen van de AI worden geaccepteerd of afgewezen, en wie de uiteindelijke beslissingen neemt. Dit helpt ons gebieden te identificeren waar de prestaties van de AI zwak kunnen zijn of waar menselijke processen verfijning behoeven.

Bron van actie

Hier traceren we de oorzaak van een output. Het generatieve proces van een AI is vaak ondoorzichtig, dus proberen het “mede-eigenaar” te worden door nauwgezet prompts te maken, kan slechts een illusie van controle zijn. In plaats daarvan moet menselijk toezicht zich richten op het evalueren van de uiteindelijke output door de causale geschiedenis te beoordelen (prompts, inputs, AI-oproepen) (ook wel herkomst genoemd).

Ontwerptijd

-

Zorg ervoor dat het systeem een volledig overzicht van zijn herkomst kan vastleggen door middel van end-to-end logging (onveranderlijk en gestandaardiseerd voor machineleesbaarheid), waarbij elke stap in de workflow van de AI automatisch wordt gelogd en van een tijdstempel wordt voorzien:

- gebruikte invoergegevens en prompt

- specifieke versie van het AI-model dat is gebruikt om de output te genereren

- volledige geschiedenis van menselijke instructies en wijzigingen

- alle externe oproepen, externe services, API’s, databases waartoe het AI-systeem toegang had

- tussenliggende outputs die het systeem heeft gegenereerd maar uiteindelijk heeft weggegooid

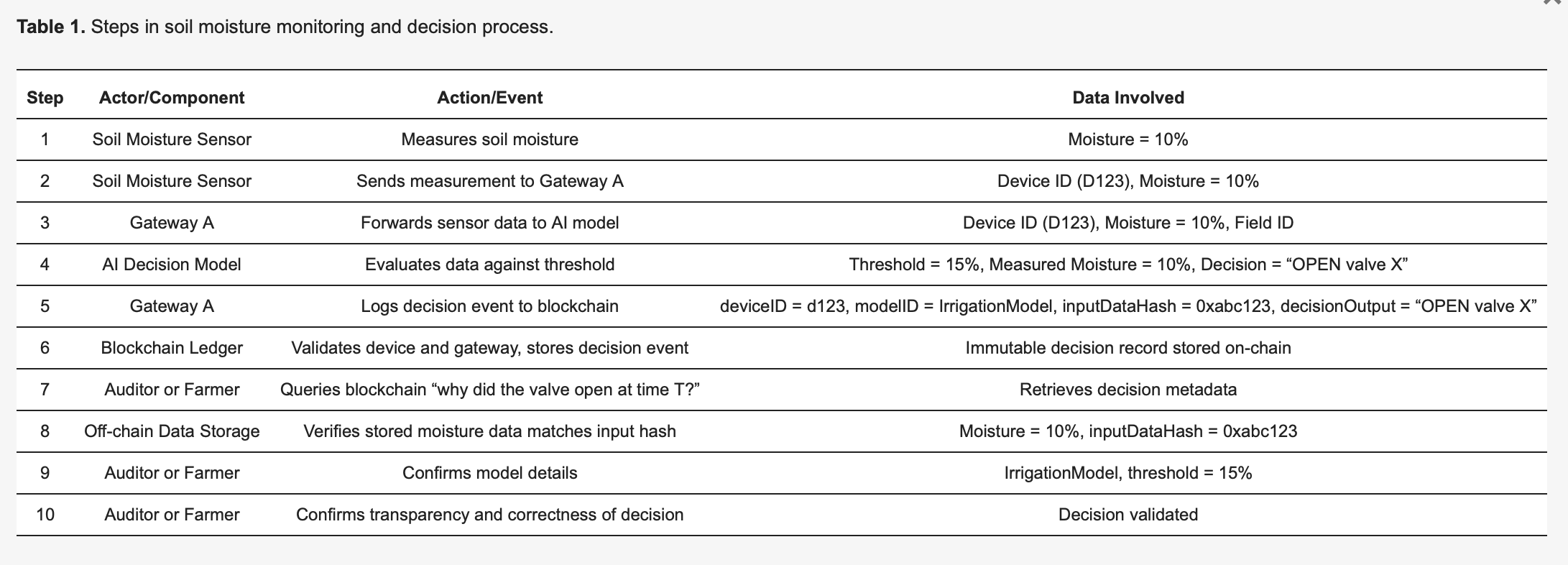

Deze pre-print van “Using Blockchain Ledgers to Record the AI Decisions in IoT”, bijvoorbeeld, bespreekt hoe dit in de praktijk kan worden gedaan: https://www.preprints.org/manuscript/202504.1789/v1 Hier is een voorbeeld uit deze pre-print:

Om de methodologie concreet te maken, beschouwen we een op IoT gebaseerd slim irrigatiesysteem [27], gedetailleerd in Tabel 1. Bodemvochtsensoren (apparaten) sturen metingen naar een edge AI-model dat beslist of waterkleppen moeten openen of gesloten moeten blijven. Elke beslissing die door de AI wordt genomen, activeert een logging-gebeurtenis die onveranderlijk wordt vastgelegd op een blockchain-grootboek, wat de transparantie en controleerbaarheid verbetert. Zoals geïllustreerd in Tabel 1, detecteert Sensor 123 vocht op 10 procent en verzendt deze meting naar Gateway A. Gateway A stuurt de gegevens door naar het AI-model, dat, vanwege een vooraf gedefinieerde drempel van 15 procent (gespecificeerd door IrrigationModelv2), de juiste actie bepaalt: “klep = OPEN” voor veld X. Gateway A bereidt vervolgens een transactie voor met kritieke metadata - inclusief de deviceID (123), modelID (IrrigationModelv2), een hash van de invoergegevens (0xabc123) en het beslissingsresultaat (OPEN klep X) - ondertekent deze en dient deze in bij de blockchain. Blockchain-knooppunten verifiëren de authenticiteit en machtigingen van Sensor 123 en Gateway A, bevestigen dat ze correct zijn geregistreerd voor veld X en slaan vervolgens het record permanent op. Er wordt een gebeurtenis uitgezonden om een succesvolle logging aan te geven. Later kan een auditor of de boer vragen “waarom werd er water vrijgegeven op tijdstip T?”, waarbij het gedetailleerde transactierecord van de blockchain wordt opgehaald. De hash (0xabc123) van de blockchain kan vervolgens worden vergeleken met off-chain opgeslagen sensorgegevens (opgeslagen op IPFS of de database van Gateway A) om te bevestigen dat de vochtmeting inderdaad 10 procent was. Bovendien kan de boer, door te verwijzen naar het modelregister, valideren dat de irrigatiedrempel was ingesteld op 15 procent vocht, wat bevestigt dat de beslissing van de AI correct en gerechtvaardigd was. Dit gestructureerde proces verbetert de transparantie aanzienlijk: elke geautomatiseerde actie is verifieerbaar en volledig verklaarbaar via gelogde metadata, en de onveranderlijkheid van blockchain zorgt ervoor dat noch boeren, noch fabrikanten van apparaten in het geheim beslissingslogboeken kunnen wijzigen.

Runtime

- Inspecteer de causale keten voor het specifieke geval om te zien hoe de output is gegenereerd.

- Gebruik een visueel dashboard dat de hele causale keten voor een specifieke output in kaart brengt om het eindresultaat en elke stap die daartoe heeft geleid te zien.

Wanneer u een beslissing wilt beoordelen, kunt u het herkomstrecord voor dat specifieke geval opvragen. U hoeft het interne “generatieve pad” van de AI (de complexe wiskunde en neurale activeringen) niet te begrijpen. In plaats daarvan controleert u de herkomstmetadata om vragen als deze te beantwoorden:

“Zijn de juiste gegevens gebruikt?”

Bijvoorbeeld, wanneer een arts het herkomstrecord opvraagt, toont de metadata een lijst van de specifieke datapunten die de AI heeft gebruikt. Het herkomstrecord bevestigt dat de AI de volledige medische geschiedenis van de patiënt, een recente bloedtest van 24/10/25 en een MRI-scan van 26/10/25 heeft gebruikt, en alle datapunten komen overeen met het officiële EPD. In een ander geval kan de arts concluderen dat het herkomstrecord aantoont dat de AI toegang had tot bloedtestgegevens van twee jaar geleden, maar de kaart van de patiënt was vorige week bijgewerkt met nieuwe resultaten en de AI gebruikte verouderde informatie.

“Is de prompt van de mens correct verwerkt?”

De prompt van de arts aan de AI was “Analyseer symptomen en beveel een diagnose aan voor een 45-jarige man met aanhoudende hoest en koorts.” Het herkomstrecord logt de exacte query die de AI heeft ontvangen. De arts vergelijkt dit met zijn oorspronkelijke invoer en merkt op dat de gelogde query laat zien dat de prompt was afgekapt, waarbij het symptoom “koorts” ontbrak - dus de AI verwerkte alleen “aanhoudende hoest”, wat leidde tot een ander diagnostisch pad.

“Is de juiste modelversie geïmplementeerd?”

Het herkomstrecord kan aantonen dat de diagnose is gegenereerd door een oudere versie van het model die buiten gebruik had moeten worden gesteld vanwege een systeemfout.

Hier schrijft het systeem duidelijk acties toe aan ofwel de autonome generatie van de AI ofwel een specifieke interventie van een mens. Dit zorgt voor duidelijke verantwoording. Als er een slechte beslissing wordt genomen, kan een snelle controle van het herkomstlogboek onthullen of het een gebrekkige AI-output was of een menselijke evaluatiefout, waardoor het “blame-game” wordt voorkomen waarbij de agency wordt verspreid.

Doelgerichtheid

De AI moet subdoelen op laag niveau afhandelen, terwijl mensen de autoriteit behouden over doelen op hoog niveau. De rol van de mens is ervoor te zorgen dat het door de AI gekozen pad in overeenstemming is met bredere doelen en beperkingen zoals wettelijke vereisten of eerlijkheidsdoelen.

Ontwerptijd

- Publiceer expliciet de doelstellingen op hoog niveau, beperkingen en afwegingsregels voor de AI.

De door de mens gedefinieerde doelen op het hoogste niveau worden duidelijk en toegankelijk gemaakt. Dit zijn niet alleen vage missieverklaringen; het zijn tastbare, vaak numerieke, doelen. Voor een logistieke AI zou dit kunnen zijn “de levertijd met 15% minimaliseren zonder de brandstofkosten te verhogen.” Voor een wervings-AI zou een doel op het hoogste niveau kunnen zijn “het aantal gekwalificeerde sollicitaties met 20% verhogen en tegelijkertijd zorgen voor geen raciale of genderbias bij de werving van kandidaten.”

- Definieer beperkingen en afwegingsregels.

Menselijke autoriteit wordt uitgedrukt door grenzen en regels. De AI moet expliciete limieten krijgen die het niet kan overtreden. Bijvoorbeeld, “blijf binnen het wettelijke budget,” “beveel geen actie aan die de privacywetgeving schendt,” of “geef prioriteit aan eerlijkheid boven pure efficiëntie.” In gevallen waar doelen conflicteren (bijv. snelheid versus kosten), moeten de door de mens gedefinieerde afwegingsregels dicteren welke prioriteit heeft.

Runtime

Hier verschuift de focus naar monitoring en evaluatie. Een mens hoeft niet elke afzonderlijke rekenstap te kennen, maar hij kan zien of de algemene richting van de AI overeenkomt met het doel op een hoger niveau. We kunnen de voortgang op specifieke vooraf gedefinieerde punten evalueren.

- Test of de huidige output en subdoelen van de AI consistent zijn met die verklaarde doelen.

Bijvoorbeeld, een financiële AI kan worden toegestaan om meerdere simulaties uit te voeren om een portefeuille te optimaliseren (subdoelen), maar een menselijke analist moet de uiteindelijke strategie goedkeuren om ervoor te zorgen dat deze in overeenstemming is met de risicotolerantie en wettelijke vereisten van de klant (doelen op het hoogste niveau). Dit proces stelt de AI in staat om zijn “operatieve agency” te gebruiken om oplossingen te verkennen, terwijl de mens “evaluatieve agency” behoudt om ervoor te zorgen dat de richting van de AI legitiem blijft.

- Zorg ervoor dat het systeem is ontworpen om continu de voortgang naar zijn subdoelen te monitoren en te rapporteren.

Voor een contentgeneratie-AI kan dit inhouden dat het rapporteert over zijn pogingen om specifieke trefwoorden te vinden of zijn strategie voor het structureren van het artikel.

- Het systeem moet een duidelijk, traceerbaar overzicht van zijn beslissingen creëren, inclusief waarom het een bepaald subdoel nastreefde. Dit overzicht wordt beschikbaar gesteld aan een menselijke evaluator.

Als een AI een bevooroordeeld resultaat genereert, kan een auditor zijn pad traceren en zien waar het begon af te wijken van de eerlijkheidsbeperkingen die in de ontwerpfase zijn gedefinieerd.

Aanpassingsvermogen

Een mens kan onmogelijk elke kleine interne verandering die een AI maakt overzien. Menselijk toezicht moet gericht zijn op belangrijke veranderingen, zoals verschuivingen in beleid of algemeen systeemgedrag. Het gaat om het creëren van de vangrails voor het adaptieve gedrag van de AI.

Ontwerptijd

- Stel wijzigingscontroles en driftmonitors in die significante gedragsverschuivingen detecteren.

Het systeem moet worden ontworpen om zijn eigen modellen en configuraties te versioneren om het mogelijk te maken terug te keren naar een eerdere, stabiele versie als er iets misgaat.

Driftmonitors zijn tools die constant de prestaties en het gedrag van de AI in de echte wereld volgen. Ze meten niet alleen de nauwkeurigheid; ze zoeken naar concept drift (wanneer de relatie tussen invoer- en uitvoergegevens verandert) en data drift (wanneer de invoergegevens zelf veranderen). De monitors zijn ingesteld met specifieke drempels. Bijvoorbeeld, de driftmonitor van een fraudedetectie-AI kan worden ingesteld om een mens te waarschuwen als het percentage valse positieven met meer dan 5% toeneemt.

Runtime

Zodra het systeem live is, kijken mensen er niet constant naar. Ze worden gewaarschuwd door de geautomatiseerde monitors, waardoor ze hun aandacht effectief kunnen richten. Wanneer de drempel van een driftmonitor wordt overschreden, stuurt deze automatisch een waarschuwing naar een menselijk team. De waarschuwing moet een momentopname van het waargenomen gedrag en de relevante gegevens bevatten, zodat de mens de situatie snel kan beoordelen. Het systeem kan ook vooraf worden geprogrammeerd om een specifiek protocol te volgen wanneer een verandering wordt gedetecteerd.

Wat krijg ik als ik dit raamwerk implementeer?

Deze aanpak creëert een krachtig partnerschap waarbij het AI-systeem en de “toezichthoudende” mens elk een duidelijke, waardevolle rol hebben. De AI is vrij om zijn rekenkracht te gebruiken om complexe problemen aan te pakken (zijn “operatieve agency”), terwijl de mens, met behulp van duidelijke signalen van het systeem, in staat wordt gesteld om weloverwogen beslissingen op hoog niveau te nemen en in te grijpen wanneer dat nodig is (hun “evaluatieve agency”). Het resultaat is een “niet-nulsom”-samenwerking, waarbij de gecombineerde inspanning leidt tot betere resultaten dan de mens of de AI alleen zou kunnen bereiken.

Hoe pakt dit raamwerk Art.14 van de AI Act aan?

Het raamwerk pakt de vereisten van de EU AI Act, met name Artikel 14, direct aan door een praktische, uitvoerbare benadering van “effectief menselijk toezicht” te bieden die verder gaat dan abstracte principes. Het definieert toezicht niet als een vage verplichting, maar als een systematisch proces van het ontwerpen van AI om menselijke evaluatieve agency te ondersteunen.

Wat vereist de AI Act van ontwikkelaars van AI-systemen?

- “Passende mens-machine-interfacetools… kunnen effectief worden overzien.”

Het kernprincipe van het raamwerk is dat het AI-systeem zelf moet worden gebouwd om toezicht mogelijk te maken. Het door het paper voorgestelde raamwerk biedt fundamentele ontwerpkenmerken die ervoor zorgen dat de werking van het systeem transparant en beheersbaar is voor een mens.

- “Streven naar het voorkomen of minimaliseren van de risico’s.”

De nadruk van het raamwerk op evaluatieve agency pakt dit direct aan. De rol van de mens is het bieden van het “hogere-orde oordeel” dat de acties van de AI verankert aan professionele en maatschappelijke normen. Dit is het mechanisme voor het voorkomen van risico’s die de AI, opererend met zijn operatieve agency, mogelijk niet detecteert. De ontwerptijdcontroles van het raamwerk (bijv. het instellen van eerlijkheidsdoelen, het identificeren van risicovolle beslissingen) zorgen ervoor dat risicopreventie een opzettelijk onderdeel is van de architectuur van het systeem, geen bijzaak.

- “Maatregelen… ingebouwd in het hoogrisico-AI-systeem.”

De hele structuur van het raamwerk is rond deze eis opgebouwd. De “AI-artefacten om bloot te leggen” en “Systeemverificatieoppervlak” voor elke voorwaarde zijn voorbeelden van maatregelen die “door de aanbieder in het hoogrisico-AI-systeem zijn ingebouwd”.

De individualiteitsvoorwaarde vereist dat het systeem wordt ontworpen met duidelijke overdrachts-API-contracten. De Aanpassingsvermogen-voorwaarde vereist ingebouwde driftmonitors en terugdraaimechanismen. Dit zijn allemaal concrete maatregelen die door de aanbieder worden geïmplementeerd.

Het raamwerk begeleidt de aanbieder ook bij het identificeren van maatregelen voor de implementeerder. Bijvoorbeeld, de Bron van Actie-voorwaarde vereist dat de aanbieder de implementeerder een herkomstdashboard geeft, wat een belangrijke maatregel is voor de implementeerder om te implementeren en te gebruiken.

- “Menselijk toezicht… mogelijk gemaakt, waar passend en evenredig.” Het raamwerk vertaalt elk punt van dit subartikel rechtstreeks in een ontwerpvereiste.

a) “De relevante capaciteiten en beperkingen goed begrijpen”

De voorwaarden Individualiteit en Doelgerichtheid pakken dit aan door expliciete documentatie van de grenzen, doelstellingen en beperkingen van de AI te vereisen. Dit geeft de mens een duidelijk begrip van de mogelijkheden van de AI.

b) “Zich bewust blijven van… automatiseringsbias”

Het raamwerk promoot evaluatieve agency als tegenwicht voor automatiseringsbias. De nadruk op het controleren van de outputs van de AI in plaats van ze alleen maar te accepteren, dwingt de mens om betrokken te blijven en biedt een mechanisme om de AI te overrulen wanneer dat nodig is.

c) “De… output correct interpreteren”

De voorwaarde Bron van Actie zorgt ervoor dat de output van de AI wordt vergezeld van interpreteerbare metadata en herkomstrecords. Dit stelt de mens in staat om de context en de causale keten van de output correct te interpreteren, waardoor een eenvoudig oordeel mogelijk wordt.

d) “Beslissen… niet te gebruiken… of de output te negeren”

De voorwaarde Individualiteit ondersteunt dit rechtstreeks door expliciete overdrachtspunten en “weigeren te antwoorden en over te dragen aan een mens”-mechanismen te vereisen, waardoor de mens in staat wordt gesteld om in te grijpen en het systeem te overrulen.

e) “Ingrijpen… of onderbreken… via een ‘stop’-knop”

De terugdraai- en onthoudingsmechanismen van de voorwaarde Aanpassingsvermogen bieden het functionele equivalent van een “stop”-knop. Ze stellen een mens in staat om de werking van de AI op een veilige en gecontroleerde manier te stoppen of terug te draaien.

f) “Verificatie door ten minste twee natuurlijke personen.”

Het raamwerk biedt de tools om dit een haalbaar en zinvol proces te maken. Het herkomstrecord van de voorwaarde Bron van Actie en een duidelijk logboek van alle menselijke interacties maken het voor twee of meer personen gemakkelijk om de identificatie van een AI onafhankelijk te verifiëren. Ze kunnen beiden dezelfde set gelogde gegevens opvragen en de causale keten beoordelen om tot een consensus te komen, waardoor wordt gegarandeerd dat de verificatie is gebaseerd op objectief bewijs in plaats van subjectief giswerk.

Uitdagingen

Natuurlijk, hoewel het raamwerk er veelbelovend en toepasbaar uitziet, negeert het paper de veelvoorkomende nadelen van het implementeren van de toezichtmechanismen niet.

Complexiteit en kosten

Ten eerste zijn ze niet allemaal eenvoudig op te zetten - velen vereisen een aanzienlijke inspanning vooraf om te ontwerpen en te bouwen. U hebt gespecialiseerde expertise nodig om systemen te creëren die gestructureerde redeneringen kunnen genereren, herkomst kunnen vastleggen of genuanceerde regels in een doelenregister kunnen coderen. Bereid u bovendien voor op doorlopende kosten voor het onderhouden van het systeem, het kalibreren van signalen en het trainen van menselijke beoordelaars in de nieuwe processen.

Signaalafhankelijkheid

De effectiviteit van deze toezichtmechanismen is sterk afhankelijk van de kwaliteit van de signalen die ze produceren. Als de AI slechte of ruisende signalen genereert (bijv. onnauwkeurige betrouwbaarheidsscores, vage redeneringen of gebrekkige herkomstgegevens), kan dit de menselijke beoordelaar misleiden en het hele toezichtproces ondermijnen.

Verificatielast

Hoewel het doel is om de efficiëntie te verbeteren, elimineren deze systemen de menselijke werklast niet volledig. In grensgevallen, nieuwe of dubbelzinnige gevallen kan de menselijke beoordelaar nog steeds intensieve, handmatige steekproeven moeten uitvoeren. Het paper merkt op dat dit de efficiëntiewinst kan verminderen, omdat beoordelaars mogelijk veel tijd moeten besteden aan het oplossen van onthoudingen of het aanvechten van de suggesties van de AI. De menselijke last verschuift van een volledige evaluatie naar een gedetailleerde verificatie van het werk van de AI, wat nog steeds aanzienlijk kan zijn.

Onthoud: een mentaliteitsverandering is nodig

Het is dus niet genoeg om alleen maar te zeggen dat we “menselijk toezicht” nodig hebben. Om het werkelijkheid te maken, moeten we onze mentaliteit veranderen van simpelweg “toezicht houden op AI” naar het ontwerpen van AI voor mens-AI-samenwerking: de rol van de mens herdefiniëren als een actieve evaluator, toezicht inbouwen in het AI-ontwerp, denken aan de drie C’s - controle, betwistbaarheid en competentie - en dan zult u niet alleen voldoen aan regelgeving zoals de AI Act - u zult een betrouwbaarder en krachtiger systeem creëren dat met mensen werkt.