Mënschlech Iwwerwaachung vun der KI

Mënschlech Iwwerwaachung an KI-Systemer ass eng Konformitéitsufuerderung:

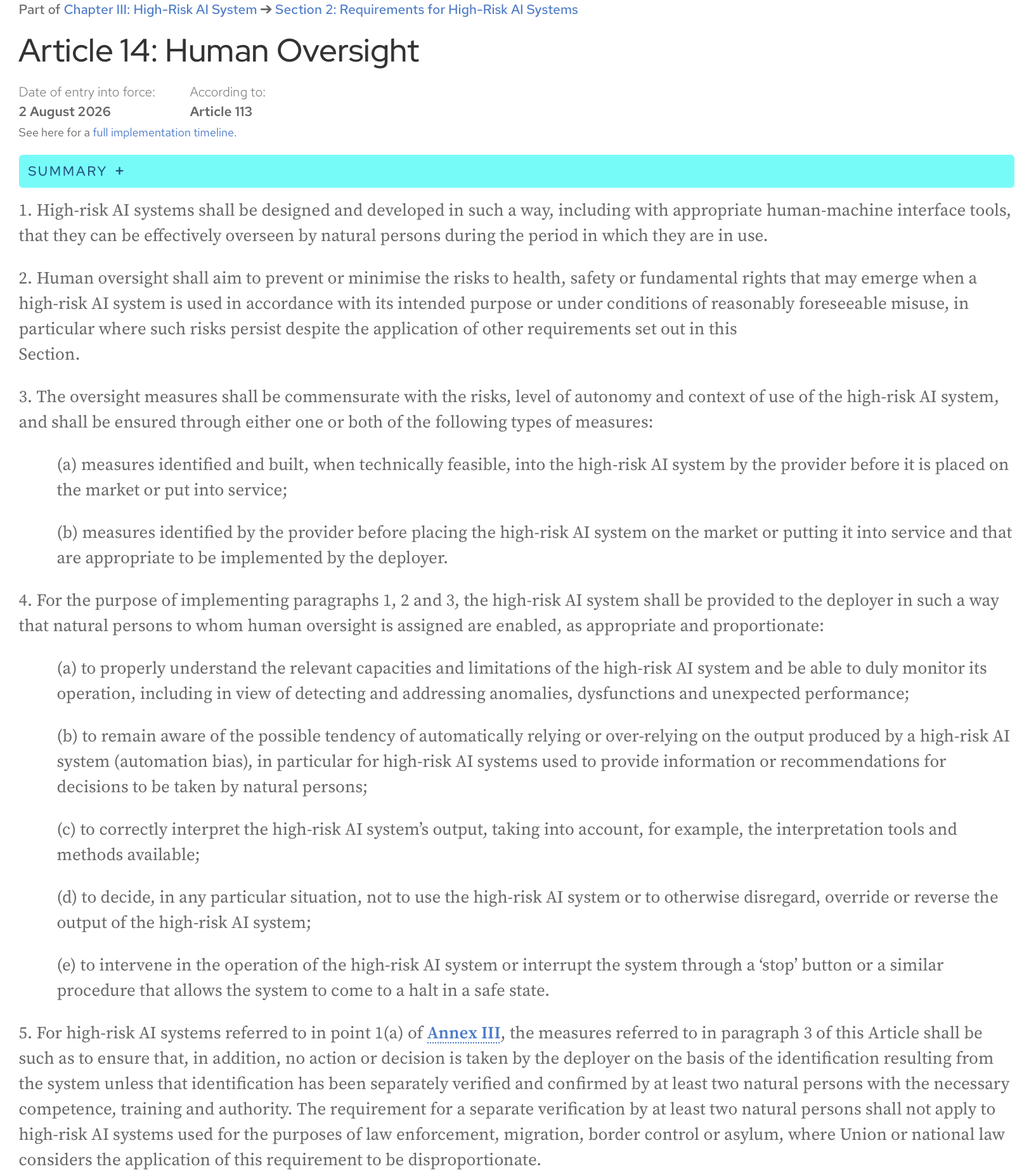

AI Act, Artikel 14: Héichrisiko-KI-Systemer solle sou entworf an entwéckelt ginn, och mat passenden Mënsch-Maschinn-Interface-Tools, datt se effektiv vun natierleche Persounen iwwerwaacht kënne ginn während der Period an där se am Gebrauch sinn.

Hei ass de kompletten Text vum Artikel vun der offizieller AI Act Websäit:

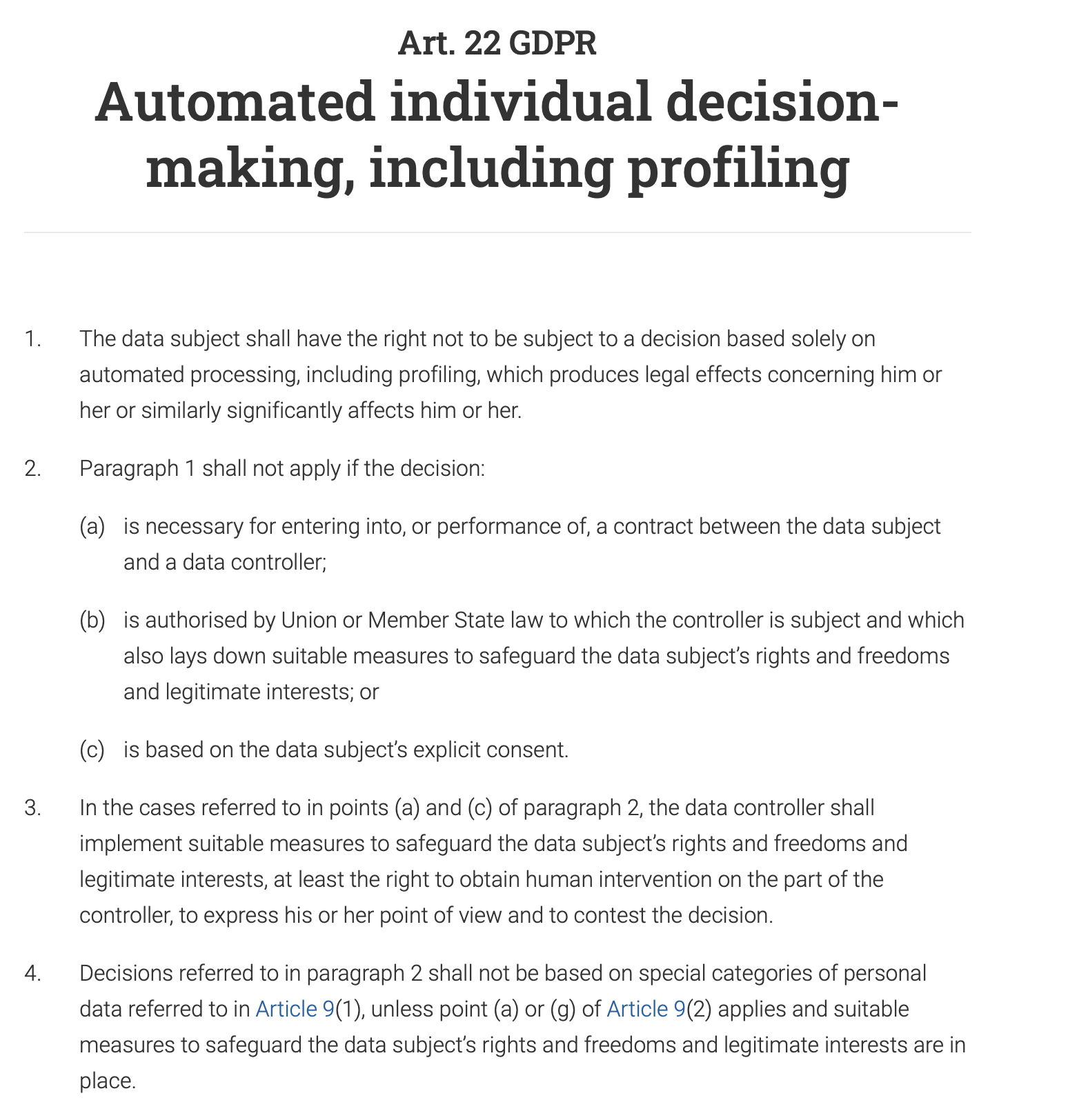

Artikel 22 vun der GDPR gëtt Eenzelpersounen explizit d’Recht “net enger Entscheedung ënnerworf ze ginn, déi eleng op automatiséierter Veraarbechtung baséiert, inklusiv Profiling, déi rechtlech Auswierkungen op hien oder hatt huet oder hien oder hatt op ähnlech Manéier wesentlech beaflosst.” Dëst bedeit, datt fir all automatiséiert Entscheedungssystem, deen e groussen Impakt op eng Persoun huet (z.B. d’Oflehnung vun engem Kredittantrag, enger Aarbechtsoffer oder enger ëffentlecher Leeschtung), e Mënsch am Prozess involvéiert muss sinn fir d’Entscheedung ze iwwerpréiwen an ze validéieren. D’Persoun huet och d’Recht, déi automatiséiert Entscheedung ze contestéieren an eng mënschlech Interventioun ze kréien.

An, net onerwaart, ass mënschlech Iwwerwaachung eng Schlësselufuerderung souwuel am ISO 42001 wéi och am NIST AI Risk Management Framework (AI RMF). Béid Kaderen, obwuel anescht an hirer Approche, betounen d’Noutwennegkeet vu mënschlecher Interventioun fir de verantwortungsvollen an ethesche Gebrauch vun KI-Systemer ze garantéieren.

Dëse Post ass meng Interpretatioun vum Pabeier, deen op der rezenter Sessioun vum monatlechen Data61 AI Adoption and Assurance Chat presentéiert gouf - “Designing meaningful human oversight in AI” (https://www.researchgate.net/publication/395540553_Designing_Meaningful_Human_Oversight_in_AI).

(déi komplett Zitatioun fir de Pabeier: Zhu, Liming & Lu, Qinghua & Ding, Ming & Lee, Sunny & Wang, Chen & Data, & Csiro, & Australia,. (2025). Designing Meaningful Human Oversight in AI. 10.13140/RG.2.2.16624.11528)

De Pabeier diskutéiert de Problem mat der aktueller Approche zur mënschlecher Iwwerwaachung a presentéiert praktesch Tipps fir Entwéckler vun KI-Systemer.

Wat ass mënschlech Iwwerwaachung a wéi gëtt se gemaach?

De Problem mat der mënschlecher Iwwerwaachung ass, datt se schlecht definéiert ass. Awer menger Meenung no, wat alles méi komplizéiert mécht, ass eis natierlech Automatiséierungsbias - eng Tendenz, dem Output vun enger Maschinn méi ze trauen wéi eisem eegenen Uerteel. Wéi oft hutt Dir blann engem GPS op eng net-existent Strooss gefollegt?

Als Resultat stëmme mir entweder dem Systemoutput zou ouni et richteg ze verstoen (“rubber-stamp” et).

Zum Beispill kann de KI-System vun enger Bank Är Transaktioun als héich-Risiko markéieren, an e mënschlechen Analyst, deen d’Aufgab huet, Dausende vun esou Alarmer deeglech ze iwwerpréiwen, stëmmt automatesch der Entscheedung vun der KI zou a fréiert Äre Kont.

De Géigendeel Szenario ass och heefeg: mir beschränken de System sou vill, datt mir, amplaz him en héich-Niveau Zil an e bësse Fräiheet ze ginn fir Kompromësser ze entdecken an ze fannen, probéieren all eenzel Aktioun, déi en huelen soll, virzeprogramméieren an en domat op e reegelbaséiert Automatiséierungssystem reduzéieren.

Eng Firma wëll, datt en KI-Chatbot Clientufroe behandelt. Amplaz him en héich-Niveau Zil ze ginn wéi “léis de Problem vum Client héiflech an effizient”, programméiert Dir en mat engem rigide Skript, dat virschreift, datt wann e Client freet: “Wéi kann ech e Produit zréckginn?”, de Bot muss mat engem Link op d’Retour-Säit äntweren an dann froen: “Huet dëst Är Fro beäntwert?” E kann keng nuancéiert Froen behandelen wéi: “Ech hunn mäi Bong verluer, kann ech dëst nach ëmmer zréckginn?” well d’Reegelen dat spezifescht Szenario net ofdecken. De Chatbot verléiert seng agentesch Qualitéit a gëtt e basis, frustréierenden Entscheedungsbam.

De Pabeier argumentéiert, datt keng vun dëse Szenarie optimal ass, an datt mënschlech Agence an KI-Agence kee Nullsummespill sinn. D’Zesummenaarbecht vun deenen zwee produzéiert besser Resultater wéi jidderee fir sech eleng erreeche kéint.

Wéi kann mënschlech Iwwerwaachung entworf ginn fir dës Zesummenaarbecht z’erméiglechen?

Zwee Aarte vun Agence

Loosst eis mat der Definitioun vun Agence ufänken: et ass d’Fäegkeet, Aktiounen ze huelen an Saachen eleng ze maachen, fir en Zil z’erreechen.

De Pabeier proposéiert, tëscht den zwou Aarte vun Agence z’ënnerscheeden:

- Operativ Agence (d’Kapazitéit vun der KI fir Léisungen ze generéieren)

Zum Beispill, e medizinescht KI-System generéiert eng Diagnos.

- Evaluativ Agence (d’Kapazitéit vum Mënsch fir d’Léisung vun der KI ze verstoen, ze beurteelen, ze verifizéieren an, wou néideg, hir Resultater ze steieren oder se duerch alternativ Léisungen z’ersetzen)

En Dokter replizéiert den diagnostesche Prozess net. Et ass net d’Aarbecht vun engem Dokter, d’Aarbecht vun der KI nei ze maachen oder d’Maschinn ze iwwerlisten. Amplaz ass hir Roll, d’Diagnos vun der KI ze evaluéieren. Den Dokter freet: “Mécht dat Sënn? Ass d’Begrënnung vun der KI konsequent mat deem, wat e verantwortleche mënschlechen Expert géif maachen?” Si kontrolléieren op Konsequenz. Si iwwerpréiwen d’Begrënnung vun der KI, déi eng Lëscht vu Schlësselsymptomer an eng Zitatioun vu medizinescher Literatur kéint sinn. Den Dokter verifizéiert, datt dës Begrënnung mat hirer eegener Ausbildung a medizinesche Standarden iwwereneestëmmt. Si fügen och mënschleche Kontext bäi: wëssend, datt d’Behandlung fir eng rar Krankheet eng deier, schmerzhaf an intensiv Joer-laang Therapie ass, berécksiichtegen si d’Virléiften vum Patient, d’finanziell Situatioun an ob se bereet sinn, sech op esou e schwierege Regime ze engagéieren. Schlussendlech weien si déi potenziell Virdeeler vun der Behandlung géint hir bedeitend Belaaschtung of a entscheeden, ob et de passendsten an etheschste Wee ass, och wann d’Diagnos vun der KI technesch korrekt ass.

Et ass schwéier, mat der Meenung vun den Auteuren net averstanen ze sinn, datt ‘evaluéieren’ e bessert Wuert ass wéi ‘iwwerwaachen’, well et d’mënschlech Roll als aktiv a beurteelend betount, anstatt just iwwerwaachend oder symbolesch.

Evaluativ Agence suergt fir Rechenschaftspflicht

Wann eppes falsch leeft, ass e Mënsch schlussendlech verantwortlech. D’KI kann net viru Geriicht zur Rechenschaft gezu ginn; d’Persoun, déi hiren Output evaluéiert huet, kann. Ausserdeem verankert d’Uerteel vum Mënsch d’Aktiounen vun der KI un professionell, ethesch a gesellschaftlech Standarden, déi d’KI selwer net versteet. D’KI kann de schnellste Wee fannen, awer nëmmen de Mënsch kann entscheeden, ob dee Wee deen etheschsten oder séchersten ass. Dës zwee Virdeeler si Schlëssel fir eng verantwortungsvoll a vertrauenswierdeg KI.

Intern vs. extern Begrënnungstrei

Wéi kënne mir d’Outpute vun engem System evaluéieren, wa mir déi komplex intern Aarbechtsweis vu modernen KI-Modeller nach ëmmer net ganz begräife kënnen? All Aktivéierung vun engem neuralen Netzwierk, all Parameterjustéierung, oder wéi dat geléiert Wësse vum Modell (wéi d’Konzept vun enger “Kaz”) a senge Milliounen oder Milliarden vu Parameteren (d’Erënnerung vum Modell) verdeelt a gespäichert ass - ze probéieren, dësen algorithmesche Circuit ze verstoen ass an dëser Phase vun der KI-Entwécklung net machbar, an och wann et wier, wier et wéi d’Entscheedunge vun engem Schachcomputerprogramm duerch d’Prisma vun den eenzelne Berechnungen ze kucken, déi en mécht - ze vill Detailer, ze komplex an net ganz nëtzlech fir d’Entscheedungen tatsächlech ze evaluéieren.

Amplaz kënne mir Systemer esou designen, datt se Erklärungen ubidden, déi fir e Mënsch Sënn maachen - Erklärungen baséiert op deem, wat de Pabeier als “extern Begrënnungstrei” oder “Plausibilitéit” bezeechent. E Schachprogramm géif soen: “Ech hunn dëse Zuch gewielt fir d’Mëtt vum Briet ze kontrolléieren an Drock op de Sprénger vum Géigner auszeüben”, a mir kéinten dës Entscheedung evaluéieren, well hir Erklärung mat etabléierte Schachprinzipien a mënschlechem Uerteel iwwereneestëmmt.

Elo, wéi designe mir e System fir esou Hiweiser ze liwweren, déi mir evaluéiere kënnen an, wann néideg, contestéieren?

Léis-verifizéier Asymmetrie

De Pabeier stellt e nëtzlecht Konzept vun der Léis-verifizéier Asymmetrie vir: d’Schwieregkeet fir eng Léisung ze kreéieren (léisen) an d’Schwieregkeet fir déi Léisung ze kontrolléieren (verifizéieren) sinn dacks net gläich. Dëst ass de Fall souwuel an der Designzäit wéi och an der Lafzäit, an dëst ze verstoen hëlleft, en effektive mënschlechen Iwwerwaachungsprozess ze kreéieren.

An der Designphase ass d‘“Léis”-Aufgab den Effort, deen néideg ass fir de KI-System ze bauen:

- d’Systemarchitektur erstellen

- d’Ziler spezifizéieren

- de System implementéieren

- d’Verifikatiounsaufgaben an d’Schwellen designen, déi op vill zukünfteg Instanzen applizéiert ginn

D‘“Verifizéier”-Aufgab ass den Effort fir dat System ze evaluéieren an ze validéieren ier et agesat gëtt:

- Ufuerderungsrevisioun

- Architektur- an Designevaluatioun

- Testen

- aner Forme vu Verifikatioun a Validatioun

Zur Lafzäit kucke mir op eenzel Instanzen - spezifesch Outpute vum System, spezifesch Léisungen, déi et proposéiert. D‘“Verifizéier”-Aufgab hei ass d’Evaluatioun vun dësen eenzelen Outputen. Heiansdo sinn d‘“Léis”-Aufgaben ganz rechenintensiv, awer d’Kontroll vun den Outputen ass einfach; et ginn awer Fäll, wou d’KI séier en Output generéiert, awer de Mënsch, deen de System iwwerwaacht, vill Zäit an Effort wäert verbréngen fir en ze verifizéieren (zum Beispill, Fakten-Checken, Iwwerpréiwung op Bias, Sécherstellen, datt den Inhalt mat Standarden ausgeriicht ass, asw.), an d’Verifikatioun gëtt e Flaschenhals.

D’Kärkonklusioun ass, datt effektiv Iwwerwaachung sech un dës Asymmetrie upasse muss.

Wann d’Verifikatioun an der Designzäit einfach ass

Dës Strategie geet drëm, Sécherheet vun Ufank un anzebauen. Andeems de Verifikatiounsprozess virgelueden gëtt, kënnt Dir potenziell Problemer erkennen, ier d’KI iwwerhaapt a Gebrauch geholl gëtt, wat d’Noutwennegkeet vu konstanter, manueller Iwwerwaachung reduzéiert.

Zum Beispill muss den Aarm vun engem Fabriksroboter mat engem héije Grad vu Präzisioun a Sécherheet funktionéieren an ëmmer a sengem designéierte Aarbechtsberäich bleiwen. D’Verifikatioun, datt en e Mënsch an der Géigend net verletzt, gëtt während der Design- a Programméierungsphase duerch extensiv Tester, Modeller a virprogramméiert Sécherheetsparameter gemaach. D’Zil ass et, sécherzestellen, datt de System “sécher duerch Design” ass, wat Echtzäit mënschlech Interventioun a senge Basisbeweegungen onnéideg mécht.

Wann d’Verifikatioun an der Designzäit schwiereg ass

Dëse Pabeier erkennt un, datt verschidde KI-Aufgaben ze komplex sinn fir während der Entwécklung komplett verifizéiert ze ginn. An dëse Fäll kann de System esou entworf ginn, datt en engem mënschlechen Operateur kloer, handlungsfäeg Informatioun liwwert, deen dann eng informéiert final Entscheedung treffe kann. De Mënsch handelt als den ultimativen Kontrollpunkt.

Zum Beispill, e KI-System, deen eng Diagnos recommandéiert, mécht eng héich komplex Aufgab. Seng Genauegkeet kann schwéier während der Entwécklung komplett ze verifizéieren sinn wéinst den onendleche Variatiounen an der mënschlecher Anatomie a Krankheet. Dofir sollt de System esou entworf ginn, datt en Lafzäitverifikatioun erliichtert: en gëtt net nëmmen eng Diagnos, mee och e Vertrauensscore (z.B. “95% Wahrscheinlechkeet vun engem guddaartegen Tumor”), markéiert déi spezifesch Beräicher vun engem Scan, déi zu senger Konklusioun gefouert hunn, füügt aner relevant Zitater bäi an bitt eng detailléiert Erklärung vu senger Begrënnung (Begrënnungsspuren). En Dokter kann dës Informatioun dann benotzen fir déi final, informéiert Diagnos ze stellen.

Wat ass mat subjektiven Domänen, wou et keng richteg Äntwert gëtt?

A Beräicher wéi Konscht, Ethik oder strategesch Planung hu verschidde Leit verschidde Wäerter a Perspektiven. Hei, amplaz e KI-System all d’Diversitéit an eng eenzeg “richteg” Äntwert “zesummeklappen” ze loossen, wou et dacks keng gëtt, sollte mir KI als Partner an enger Diskussioun designen. D’Zil ass net, eng perfekt Léisung ze kréien, mee verschidde Perspektiven a Szenarien opzebréngen. Dës Approche mécht Meenungsverschiddenheeten zu engem wäertvollen Deel vum Prozess, well d’KI Iech déi verschidde Kompromësser a Standpunkter weise kann. Andeems Dir dëst maacht, gëtt de System méi rechenschaftspflichteg, well et Iech, de Mënsch, zwéngt, dës Optiounen aktiv ze berécksiichtegen an eng duerchduechten, gutt begrënnten Entscheedung op Basis vun all de verfügbare Wénkelen ze treffen.

Grenz vun der Delegatioun

D’Auteure vum Pabeier betounen, datt et eng Grenz gëtt, iwwert déi d’KI net méi den primären Entscheedungsträger sollt sinn - si nennen et “Grenz vun der Delegatioun”. A bestëmmten héich-Risiko Beräicher wéi geriichtlech Veruerteelung, medizinesch Diagnos oder Astellung, huet dat endgültegt Uerteel e bedeitend ethescht an normativt Gewiicht. Dës Entscheedunge sollten net komplett un d’KI delegéiert ginn. An dëse Fäll geet d’Iwwerwaachung net nëmmen drëm, ze kontrolléieren, ob den Output vun der KI korrekt ass. Et geet drëm, mënschlech Verantwortung ze schützen. D’KI sollt als Instrument handelen fir de mënschlechen Entscheedungsträger z’ënnerstëtzen, andeems se Daten an Abléck liwwert, awer ni hir Roll komplett ersetzt. Déi lescht Entscheedung muss bei engem Mënsch bleiwen fir ethesch a moralesch Rechenschaftspflicht ze garantéieren.

3 C’s vun effizienter mënschlecher Iwwerwaachung

Wat musse mir erreechen, wa mir de KI-Iwwerwaachungsprozess designen?

- Kontroll (mir Mënschen kënnen zäitgerecht an effektiv Interventiounen maachen fir eng Entscheedung vun enger KI ze pausen, ëmzeleeden oder z’ersetzen)

- Contestabilitéit (KI-Entscheedunge ginn duerch verständlech Grënn a Beweiser ënnerstëtzt, sou datt se iwwerpréift an ugegraff kënne ginn)

- Kompetenz (Iwwerwaachung verbessert d’Gesamtleeschtung an d’Fairness vum System, andeems stompeg Iwwerschreiwunge vermeit ginn, déi d’korrekt Outpute vun der KI degradéiere géifen)

Konditioune vun Agence an Iwwerwaachung

De Pabeier bezitt sech op d’Konditioune vun der Agence (Individualitéit, Handlungsquell, Zilorientéierung an Adaptivitéit) als Kader fir effektiv mënschlech Iwwerwaachung souwuel an der Designzäit wéi och an der Lafzäit ze designen. Dir kënnt méi iwwer dës Konditiounen an engem anere Pabeier liesen - Agency is Frame-Dependent

Loosst eis all dës Konditiounen ukucken - an déi praktesch mënschlech Iwwerwaachungsdesign-Tipps, déi mat jidderengem vun hinnen verbonne sinn, déi de Pabeier de Systementwéckler ubitt.

Individualitéit

Dës Konditioun erfuerdert eng kloer Grenz tëscht der Roll vun der KI (operativ Agence) an der Roll vum Mënsch (evaluativ Agence). Hei musse mir de Plang fir d’Mënsch-KI-Interaktioun erstellen, wou d’KI fräi sollt sinn, autonom ze schaffen, an de Mënsch nëmmen op spezifeschen, gutt definéierte Kontrollpunkten intervenéiere sollt. Dës Linnen ze verschwommen, diffuséiert d’Rechenschaftspflicht.

Designzäit

- Definéiert d’Grenze vum System a setzt explizit Iwwergabepunkte fir mënschlech Interventioun fest.

Wou hält d’Aarbecht vun der KI op? Net nëmmen “De System wäert de Clientsservice behandelen”, mee “De System wäert Clientfroen am Zesummenhang mat Produktspezifikatiounen aus enger viraus definéierter Wëssensbasis beäntweren. E wäert keng Rechnungsstreidereien oder Remboursementer behandelen.”

- Füügt Konditioune fir Enthalung bäi (d’Refus, eng Ufro ze beäntweren), wann de System e Fall fir mënschlech Interventioun markéiere muss amplaz ze roden

Zum Beispill, wann de Vertrauensscore < 90% ass, wäert de System engem Mënsch signaliséieren, datt en an enger “groer Zone” operéiert.

- Definéiert virausbestëmmte mënschlech Iwwergabepunkten - wou d’Kontroll vun der KI op e Mënsch iwwergeet.

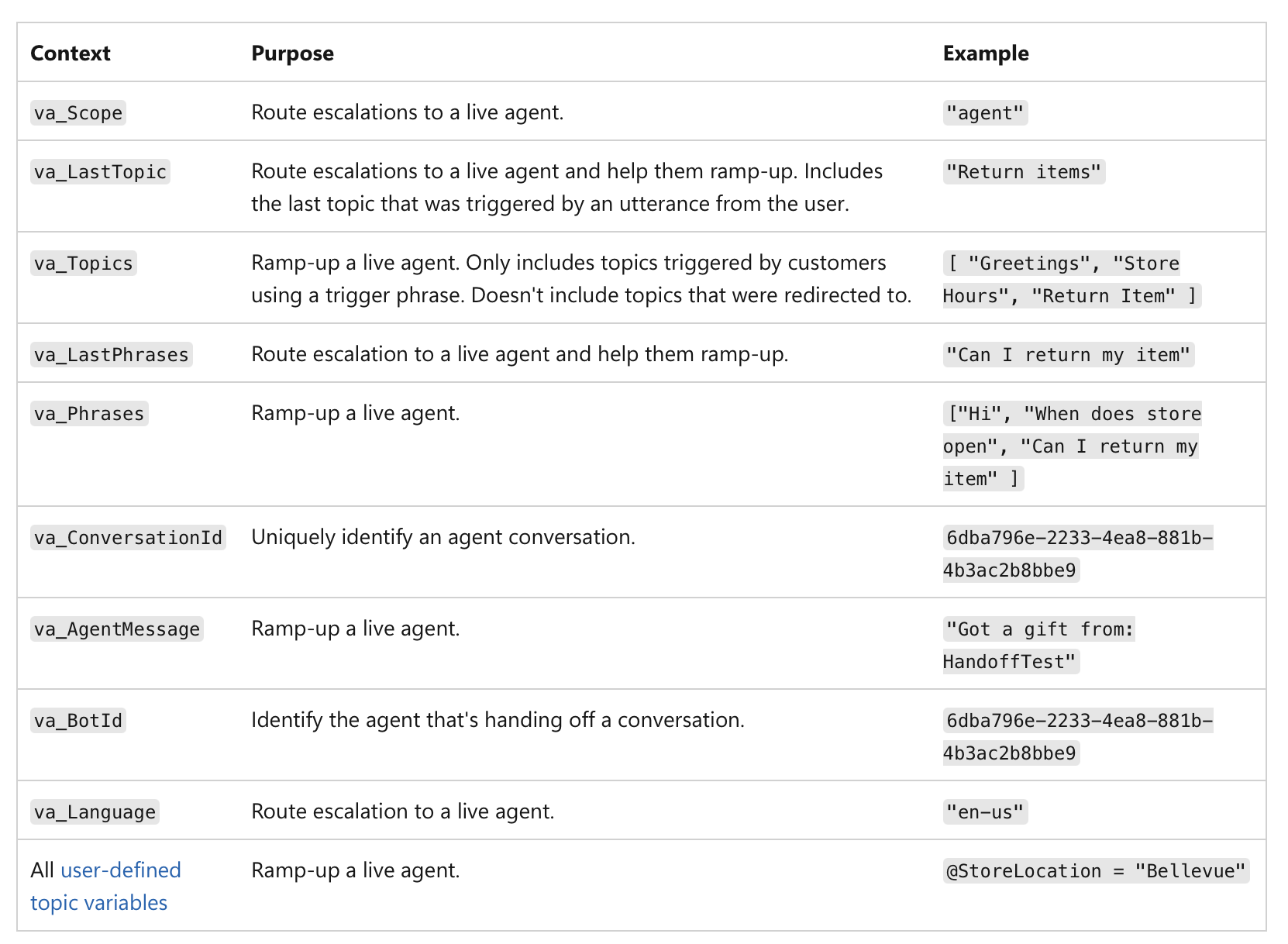

Et geet net nëmmen ëm e nidderegen Vertrauensscore, mee ëm d’Bedeitung vun der Aktioun selwer. Zum Beispill, och wann eng KI 99% sécher ass, wann d’Entscheedung eng finanziell Transaktioun iwwer 1 Millioun Dollar oder eng kritesch medizinesch Diagnos involvéiert, mécht d’héich-Risiko Natur vun der Aufgab et zu engem obligatoresche mënschleche Kontrollpunkt. Hei ass e Beispill, wéi mënschlech Iwwergabe an MS Copilot Agenten implementéiert ka ginn:

(Quell)

(Quell)

Lafzäit

Wann de System live ass, verréckelt sech de Fokus op d’Protokolléierung an d’Rechenschaftspflicht.

- Protokolléiert, wann d’Kontroll tatsächlech vun der KI op de Mënsch iwwergeet.

Äre System muss en onverännerleche Rekord erstellen (z.B. op enger Blockchain oder enger eemol schreiwen Datebank - fir Manipulatioun ze verhënneren) vun all Iwwergabe: de Protokoll sollt en Zäitstempel, déi lescht Aktioun vun der KI an d’Identitéit vum Mënsch enthalen, deen d’Kontroll iwwerholl huet:

“Kredittantrag #12345 un de mënschlechen Analyst Mary Smith um 10:30 Auer iwwerginn wéinst Kredittscore ënner der Schwell.”

Dëst garantéiert eng kloer Rechenschaftspflicht fir déi lescht Entscheedung.

Déi protokolléiert Donnéeë kënne benotzt ginn fir Dashboards a Berichter fir d’Iwwerwaachung ze erstellen - Dir kënnt gesinn, wéi dacks mënschlech Interventioun geschitt, ob d’Recommandatioune vun der KI akzeptéiert oder verworf ginn, a wien déi lescht Entscheedungen hëlt. Dëst hëlleft eis, Beräicher z’identifizéieren, wou d’Leeschtung vun der KI schwaach kéint sinn oder wou mënschlech Prozesser Verfeinerung brauchen.

Handlungsquell

Hei verfollege mir d’Ursaach vun engem Output. De generative Prozess vun enger KI ass dacks opak, also ze probéieren, et “matzebesëtzen” andeems een suergfälteg Prompts erstellt, kann just eng Illusioun vu Kontroll sinn. Amplaz sollt d’mënschlech Iwwerwaachung sech op d’Evaluatioun vum finalen Output konzentréieren andeems d’kausal Geschicht iwwerpréift gëtt (Prompts, Inputen, KI-Uriff) (alias Provenienz).

Designzäit

-

Sécherstellen, datt de System e komplette Rekord vu senger Provenienz duerch End-to-End Protokolléierung erfaasse kann (onverännerlech a standardiséiert fir Maschinneliesbarkeet), wou all Schrëtt am Workflow vun der KI automatesch protokolléiert an zäitgestempelt gëtt:

- benotzten Inputdaten a Prompt

- spezifesch Versioun vum KI-Modell, dee benotzt gouf fir den Output ze generéieren

- komplett Geschicht vu mënschlechen Instruktiounen a Modifikatiounen

- all extern Uriff, extern Servicer, APIen, Datenbanken, op déi de KI-System zougegraff huet

- Zwëschenoutputen, déi de System generéiert huet, awer schlussendlech verworf huet

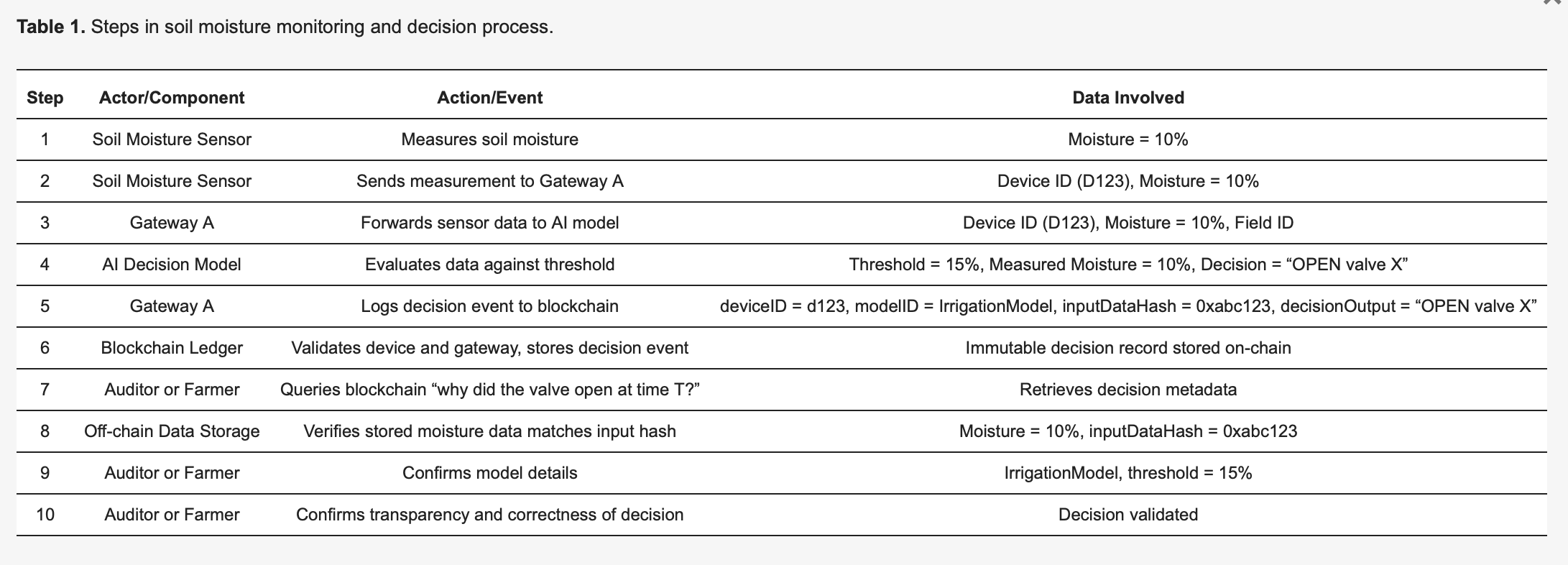

Dëse Vir-Print vun “Using Blockchain Ledgers to Record the AI Decisions in IoT”, zum Beispill, diskutéiert, wéi dëst an der Praxis gemaach ka ginn: https://www.preprints.org/manuscript/202504.1789/v1 Hei ass ee Beispill aus dësem Vir-Print:

Fir d’Methodologie konkret ze maachen, betruecht en IoT-baséiert intelligent Bewässerungssystem [27], detailléiert an der Tabell 1. Buedemfeuchtigkeitssensoren (Apparater) schécken Liesungen un en Edge KI-Modell, deen entscheet, ob Waasserventile opmaachen oder zou bleiwen. All Entscheedung, déi vun der KI getraff gëtt, léist en Protokolléierungsevenement aus, dat onverännerlech op engem Blockchain-Ledger erfaasst gëtt, wat d’Transparenz an d’Auditabilitéit verbessert. Wéi an der Tabell 1 illustréiert, detektéiert de Sensor 123 Feuchtigkeit bei 10 Prozent a schéckt dës Miessung un de Gateway A. De Gateway A schéckt d’Donnéeën un de KI-Modell, deen, wéinst enger viraus definéierter Schwell vun 15 Prozent (spezifizéiert vum IrrigationModelv2), déi entspriechend Aktioun bestëmmt: “Ventil = OPEN” fir Feld X. De Gateway A preparéiert dann eng Transaktioun mat kritesche Metadaten - inklusiv der deviceID (123), modelID (IrrigationModelv2), engem Hash vun den Inputdaten (0xabc123), an dem Entscheedungsresultat (OPEN Ventil X) - ënnerschreift se an schéckt se un d’Blockchain. Blockchain-Knuet verifizéieren d’Authentizitéit an d’Berechtegunge vum Sensor 123 a Gateway A, bestätegen, datt se richteg fir Feld X registréiert sinn, a späicheren de Rekord duerno permanent. En Evenement gëtt ausgestraalt fir eng erfollegräich Protokolléierung unzeginn. Spéider kann en Auditeur oder de Bauer froen “firwat gouf Waasser zur Zäit T fräigelooss?”, andeems en den detailléierte Transaktiounsrekord aus der Blockchain ofrufft. Den Hash (0xabc123) aus der Blockchain kann dann mat off-chain gespäicherten Sensordaten (gespäichert op IPFS oder der Datebank vum Gateway A) verglach ginn fir ze bestätegen, datt d’Feuchtigkeitsliesung tatsächlech 10 Prozent war. Zousätzlech kann de Bauer, andeems en op de Modellregister referéiert, validéieren, datt d’Bewässerungsschwell op 15 Prozent Feuchtigkeit gesat war, wat bestätegt, datt d’Entscheedung vun der KI korrekt a gerechtfäerdegt war. Dëse strukturéierte Prozess verbessert d’Transparenz wesentlech: all automatiséiert Aktioun ass verifizéierbar a komplett erklärbar duerch protokolléiert Metadaten, an d’Onverännerlechkeet vun der Blockchain garantéiert, datt weder Baueren nach Apparathersteller heemlech Entscheedungsprotokoller änneren kënnen.

Lafzäit

- Inspektéiert d’kausal Kette fir de spezifesche Fall fir ze gesinn, wéi den Output generéiert gouf.

- Benotzt en visuellt Dashboard, dat déi ganz kausal Kette fir e spezifeschen Output kartéiert fir dat endgültegt Resultat an all Schrëtt ze gesinn, deen dozou gefouert huet.

Wann Dir eng Entscheedung iwwerpréiwe wëllt, kënnt Dir de Provenienzrekord fir dee spezifesche Fall opruffen. Dir musst den internen “generative Wee” vun der KI (déi komplex Mathematik an neural Aktivéierungen) net verstoen. Amplaz kontrolléiert Dir d’Provenienzmetadaten fir Froen wéi dës ze beäntweren:

“Goufen déi richteg Donnéeë benotzt?”

Zum Beispill, wann en Dokter de Provenienzrekord oprufft, weisen d’Metadaten eng Lëscht vun de spezifeschen Datepunkten, déi d’KI benotzt huet. De Provenienzrekord bestätegt, datt d’KI déi komplett medizinesch Geschicht vum Patient, e rezenten Bluttest vum 24/10/25 an en MRI-Scan vum 26/10/25 benotzt huet, an all Datepunkte stëmmen mam offiziellen EHR iwwereneen. An engem anere Fall kann den Dokter schléissen, datt de Provenienzrekord weist, datt d’KI op Bluttestdaten vun virun zwee Joer zougegraff huet, awer d’Patientekaart war d’lescht Woch mat neie Resultater aktualiséiert ginn, an d’KI huet veralteten Informatioun benotzt.

“Gouf de Prompt vum Mënsch korrekt veraarbecht?”

De Prompt vum Dokter un d’KI war “Analyséier d’Symptomer a recommandéier eng Diagnos fir e 45 Joer ale Mann mat persistentem Houscht a Féiwer.” De Provenienzrekord protokolléiert déi exakt Ufro, déi d’KI krut. Den Dokter vergläicht dëst mat sengem originalen Input a bemierkt, datt déi protokolléiert Ufro weist, datt de Prompt ofgeschnidde war, an d’Symptom “Féiwer” gefeelt huet - also huet d’KI nëmmen “persistente Houscht” veraarbecht, wat zu engem aneren diagnostesche Wee gefouert huet.

“Gouf déi richteg Modellversioun agesat?”

De Provenienzrekord kann weisen, datt d’Diagnos vun enger aler Versioun vum Modell generéiert gouf, déi wéinst engem Systemfeeler ausser Betrib geholl hätt solle ginn.

Hei schreift de System kloer Aktiounen entweder der autonomer Generatioun vun der KI oder enger spezifescher Interventioun vun engem Mënsch zou. Dëst erlaabt eng kloer Rechenschaftspflicht. Wann eng schlecht Entscheedung getraff gëtt, kann e séiere Bléck op de Provenienzprotokoll opdecken, ob et e fehlerhaften KI-Output oder e mënschlechen Evaluatiounsfeeler war, wat de “Scholdespill” verhënnert, wou d’Agence diffuséiert gëtt.

Zilorientéierung

D’KI sollt Ënnerziler op nidderegem Niveau behandelen, wärend d’Mënschen d’Autoritéit iwwer héich-Niveau Ziler behalen. D’Roll vum Mënsch ass et, sécherzestellen, datt de gewielte Wee vun der KI mat méi breeden Ziler a Contrainten wéi gesetzlech Ufuerderungen oder Fairnessziler ausgeriicht ass.

Designzäit

- Verëffentlecht explizit déi héich-Niveau Ziler, Contrainten an Ofwiesselungsreegele fir d’KI.

Déi iewescht, vum Mënsch definéiert Ziler ginn kloer an zougänglech gemaach. Dëst sinn net nëmme vague Missiounserklärungen; et si konkret, dacks numeresch, Ziler. Fir eng Logistik-KI kéint dëst sinn “d’Liwwerzäit ëm 15% minimiséieren ouni d’Brennstoffkäschten ze erhéijen.” Fir eng Astellungs-KI kéint en iewescht Zil sinn “d’qualifizéiert Uwendungen ëm 20% erhéijen an dobäi sécherstellen, datt et keng rassistesch oder geschlechtlech Viraarbecht bei der Kandidatsourcing gëtt.”

- Definéiert Contrainten an Ofwiesselungsreegelen.

Mënschlech Autoritéit gëtt duerch Grenzen a Reegelen ausgedréckt. D’KI sollt explizit Limitte kréien, déi se net verletze kann. Zum Beispill, “bleif am legale Budget,” “recommandéier keng Aktioun, déi d’Privatsphärgesetzer verletzt,” oder “prioriséier Fairness iwwer reng Effizienz.” A Fäll, wou Ziler am Konflikt stinn (z.B. Geschwindegkeet vs. Käschten), mussen déi vum Mënsch definéiert Ofwiesselungsreegelen diktéieren, wéi eng Prioritéit huet.

Lafzäit

Hei verréckelt sech de Fokus op d’Iwwerwaachung an d’Evaluatioun. E Mënsch muss net all eenzelne Rechenschrëtt kennen, awer e kann gesinn, ob d’allgemeng Richtung vun der KI mam héieren Zil iwwereneestëmmt. Mir kënnen de Fortschrëtt op spezifesche viraus definéierte Punkten evaluéieren.

- Test, ob den aktuellen Output an d’Ënnerziler vun der KI konsequent mat deenen deklaréierten Ziler sinn.

Zum Beispill, eng Finanz-KI kéint erlaabt ginn, verschidde Simulatiounen auszeféieren fir e Portfolio ze optimiséieren (Ënnerziler), awer e mënschlechen Analyst muss déi final Strategie approuvéieren fir sécherzestellen, datt se mat der Risikotoleranz an de gesetzleche Viraussetzunge vum Client (iewescht Ziler) iwwereneestëmmt. Dëse Prozess erlaabt der KI, hir “operativ Agence” ze benotzen fir Léisungen ze entdecken, wärend de Mënsch “evaluativ Agence” behält fir sécherzestellen, datt d’Richtung vun der KI legitim bleift.

- Sécherstellen, datt de System entworf ass fir kontinuéierlech säi Fortschrëtt a Richtung seng Ënnerziler ze iwwerwaachen an ze berichten.

Fir eng Inhalt-Generatiouns-KI kéint dëst bedeiten, datt se iwwer hir Versich bericht, spezifesch Schlësselwierder ze fannen oder hir Strategie fir den Artikel ze strukturéieren.

- De System sollt e kloeren, tracéierbare Rekord vu sengen Entscheedungen erstellen, inklusiv firwat en e bestëmmt Ënnerzil verfollegt huet. Dëse Rekord gëtt engem mënschlechen Evaluator zur Verfügung gestallt.

Wann eng KI e biaséiert Resultat generéiert, kann en Auditeur säi Wee verfollegen a gesinn, wou et ugefaang huet vun de Fairness-Contrainten ofzewäichen, déi an der Designphase definéiert goufen.

Adaptivitéit

E Mënsch kann net all kleng intern Ännerung, déi eng KI mécht, iwwerwaachen. Mënschlech Iwwerwaachung sollt op bedeitend Ännerunge gezielt sinn, wéi Ännerungen an der Politik oder am allgemenge Systemverhalen. Et geet drëm, d’Leitplanke fir dat adaptivt Verhalen vun der KI ze schafen.

Designzäit

- Setzt Ännerungskontrollen an Driftmonitore op, déi bedeitend Verhalensännerungen erkennen.

De System sollt entworf ginn fir seng eege Modeller a Konfiguratiounen ze versionéieren fir et méiglech ze maachen, op eng fréier, stabil Versioun zréckzegräifen, wann eppes falsch leeft.

Driftmonitore sinn Tools, déi kontinuéierlech d’Leeschtung an d’Verhalen vun der KI an der realer Welt verfollegen. Si moossen net nëmmen d’Genauegkeet; si sichen no Konzeptdrift (wann d’Relatioun tëscht Input- an Outputdaten sech ännert) an Datendrift (wann d’Inputdaten selwer sech änneren). D’Monitore si mat spezifesche Schwellen agestallt. Zum Beispill, de Driftmonitor vun enger Bedruchserkennungs-KI kéint agestallt ginn fir e Mënsch ze alarméieren, wann säi Falsch-Positiv-Taux ëm méi wéi 5% eropgeet.

Lafzäit

Wann de System live ass, kucken d’Mënschen net konstant drop. Si ginn vun den automatiséierte Monitore alarméiert, wat hinnen erlaabt, hir Opmierksamkeet effektiv ze fokusséieren. Wann d’Schwell vun engem Driftmonitor iwwerschratt gëtt, schéckt en automatesch en Alarm un e mënschlecht Team. Den Alarm sollt e Snapshot vum observéierte Verhalen an déi relevant Donnéeë enthalen, sou datt de Mënsch d’Situatioun séier bewäerte kann. De System kann och virprogramméiert ginn fir e spezifescht Protokoll ze verfollegen, wann eng Ännerung festgestallt gëtt.

Wat kréien ech, wann ech dëse Kader implementéieren?

Dës Approche schaaft eng mächteg Partnerschaft, wou de KI-System an de “iwwerwaachende” Mënsch jidderee eng ënnerscheedlech, wäertvoll Roll hunn. D’KI ass fräi, hir Rechenkraaft ze benotzen fir komplex Problemer unzegoen (hir “operativ Agence”), wärend de Mënsch, mat klore Signaler vum System, erméiglecht gëtt, informéiert, héich-Niveau Entscheedungen ze treffen an ze intervenéieren, wann néideg (hir “evaluativ Agence”). D’Resultat ass eng “net-Nullsummen”-Zesummenaarbecht, wou de kombinéierten Effort zu bessere Resultater féiert wéi entweder de Mënsch oder d’KI eleng erreeche kéint.

Wéi adresséiert dëse Kader den Art.14 vum AI Act?

De Kader adresséiert direkt d’Ufuerderunge vum EU AI Act, besonnesch den Artikel 14, andeems en eng praktesch, handlungsfäeg Approche zur “effektiver mënschlecher Iwwerwaachung” bitt, déi iwwer abstrakt Prinzipien erausgeet. E definéiert Iwwerwaachung net als eng vague Verflichtung, mee als e systematesche Prozess fir KI ze designen fir mënschlech evaluativ Agence z’ënnerstëtzen.

Wat verlaangt den AI Act vun den Entwéckler vun KI-Systemer?

- “Passend Mënsch-Maschinn-Interface-Tools… kënnen effektiv iwwerwaacht ginn.”

De Kärprinzip vum Kader ass, datt de KI-System selwer gebaut muss ginn fir Iwwerwaachung z’erméiglechen. De Kader, deen vum Pabeier proposéiert gëtt, bitt fundamental Designfeatures, déi sécherstellen, datt d’Operatioun vum System transparent a handhabbar fir e Mënsch ass.

- “Zil, d’Risiken ze verhënneren oder ze minimiséieren.”

De Schwéierpunkt vum Kader op evaluativ Agence adresséiert dëst direkt. D’Roll vum Mënsch ass et, dat “héijer Uerdnung Uerteel” ze liwweren, dat d’Aktiounen vun der KI un professionell a gesellschaftlech Standarden verankert. Dëst ass de Mechanismus fir Risiken ze verhënneren, déi d’KI, déi mat hirer operativer Agence operéiert, vläicht net erkennt. D’Designzäit-Kontrolle vum Kader (z.B. Fairnessziler setzen, héich-Risiko Entscheedungen identifizéieren) suergen dofir, datt Risikopreventioun en intentionellen Deel vun der Systemarchitektur ass, net en Nodenken.

- “Moossnamen… an den héich-Risiko KI-System agebaut.”

Déi ganz Struktur vum Kader ass ronderëm dës Ufuerderung opgebaut. D‘“KI-Artefakte fir ze exponéieren” an d‘“Systemverifikatiounsfläch” fir all Konditioun si Beispiller vu Moossnamen, déi “vum Ubidder an den héich-Risiko KI-System agebaut ginn”.

D’Individualitéitskonditioun erfuerdert, datt de System mat kloren Iwwergabe-API-Kontrakter entworf gëtt. D’Adaptivitéit-Konditioun erfuerdert agebaute Driftmonitore a Rollback-Mechanismen. Dëst sinn all konkret Moossnamen, déi vum Ubidder implementéiert ginn.

De Kader leet den Ubidder och bei der Identifikatioun vu Moossname fir den Deployer. Zum Beispill, d’Handlungsquell-Konditioun erfuerdert, datt den Ubidder dem Deployer e Provenienz-Dashboard gëtt, wat eng Schlësselmoossnam fir den Deployer ass fir ze implementéieren an ze benotzen.

- “Mënschlech Iwwerwaachung… erméiglecht, wéi passend a proportional.” De Kader iwwersetzt all Punkt vun dësem Ënner-Artikel direkt an eng Designufuerderung.

a) “Déi relevant Kapazitéiten a Limitte richteg verstoen”

D’Konditiounen Individualitéit an Zilorientéierung adresséieren dëst andeems se explizit Dokumentatioun vun de Grenzen, Ziler a Contrainten vun der KI erfuerderen. Dëst gëtt dem Mënsch e kloert Verständnis vun de Fäegkeete vun der KI.

b) “Bewosst bleiwen vun… Automatiséierungsbias”

De Kader fördert evaluativ Agence als Géigegewiicht zur Automatiséierungsbias. De Schwéierpunkt op d’Kontroll vun den Outpute vun der KI anstatt se einfach ze akzeptéieren, zwéngt de Mënsch, engagéiert ze bleiwen a bitt e Mechanismus fir d’KI ze iwwerschreiden, wann néideg.

c) “Den… Output korrekt interpretéieren”

D’Handlungsquell-Konditioun garantéiert, datt den Output vun der KI vun interpretéierbare Metadaten a Provenienzrekorder begleet gëtt. Dëst erlaabt dem Mënsch, de Kontext an d’kausal Kette vum Output korrekt ze interpretéieren, wat en einfacht Uerteel méiglech mécht.

d) “Entscheeden… net ze benotzen… oder den Output ze ignoréieren”

D’Individualitéit-Konditioun ënnerstëtzt dëst direkt andeems se explizit Iwwergabepunkten a “refuséieren ze äntweren an un e Mënsch iwwerginn”-Mechanismen erfuerdert, wat de Mënsch erméiglecht, anzegräifen an de System ze iwwerschreiden.

e) “Intervenéieren… oder ënnerbriechen… duerch e ‘Stop’-Knäppchen”

D’Rollback- an Enthalungsmechanismen vun der Adaptivitéit-Konditioun bidden dat funktionellt Äquivalent vun engem “Stop”-Knäppchen. Si erlaben engem Mënsch, d’Operatioun vun der KI op eng sécher a kontrolléiert Manéier ze stoppen oder zréckzesetzen.

f) “Verifikatioun duerch op d’mannst zwou natierlech Persounen.”

De Kader bitt d’Tools fir dëst zu engem machbaren a sënnvolle Prozess ze maachen. De Provenienzrekord vun der Handlungsquell-Konditioun an e kloere Protokoll vun all mënschlechen Interaktiounen maachen et einfach fir zwou oder méi Persounen, onofhängeg d’Identifikatioun vun enger KI ze verifizéieren. Si kënnen allebéid dee selwechte Set vu protokolléierten Donnéeën opruffen an d’kausal Kette iwwerpréiwen fir e Konsens z’erreechen, wat garantéiert, datt d’Verifikatioun op objektive Beweiser baséiert anstatt op subjektivem Rotschléi.

Erausfuerderungen

Natierlech, obwuel de Kader ganz villverspriechend an applicabel ausgesäit, ignoréiert de Pabeier net déi heefeg Nodeeler vun der Implementéierung vun den Iwwerwaachungsmechanismen.

Komplexitéit a Käschten

Éischtens, net all si einfach opzestellen - vill erfuerderen e bedeitenden Effort am Viraus fir ze designen an ze bauen. Dir braucht spezialiséiert Expertise fir Systemer ze kreéieren, déi strukturéiert Begrënnunge generéiere kënnen, Provenienz erfaassen oder nuancéiert Reegelen an e Ziler-Ledger kodéieren. Ausserdeem, preparéiert Iech op lafend Käschte fir de System z’erhalen, Signaler ze kalibréieren an mënschlech Iwwerpréiwer an den neie Prozesser ze trainéieren.

Signalofhängegkeet

D’Effektivitéit vun dësen Iwwerwaachungsmechanismen ass staark ofhängeg vun der Qualitéit vun de Signaler, déi se produzéieren. Wann d’KI schlecht oder Kaméidi Signaler generéiert (z.B. ongenau Vertrauensscores, vague Begrënnungen oder fehlerhaft Provenienzdaten), kann et de mënschlechen Iwwerpréiwer an d’Irre féieren an de ganzen Iwwerwaachungsprozess ënnergruewen.

Verifikatiounsbelaaschtung

Obwuel d’Zil ass, d’Effizienz ze verbesseren, eliminéieren dës Systemer d’mënschlech Aarbechtsbelaaschtung net komplett. A Grenzfäll, neien oder zweedeitege Fäll kann de mënschlechen Iwwerpréiwer nach ëmmer intensiv, manuell Punktkontrolle maachen. De Pabeier bemierkt, datt dëst d’Effizienzgewënn reduzéiere kann, well d’Iwwerpréiwer vill Zäit verbrénge kënnen, fir Enthalungen ze léisen oder d’Suggestioune vun der KI ze contestéieren. D’mënschlech Belaaschtung verréckelt sech vun enger voller Skala Evaluatioun op eng detailléiert Verifikatioun vun der Aarbecht vun der KI, déi nach ëmmer bedeitend ka sinn.

Denkt drun: eng Mentalitéitsännerung ass néideg

Also, et ass net genuch, just ze soen, mir brauchen “mënschlech Iwwerwaachung”. Fir et Realitéit ze maachen, musse mir eis Mentalitéit vun einfach “KI iwwerwaachen” op KI fir Mënsch-KI Zesummenaarbecht designen änneren: d’Roll vum Mënsch als aktiven Evaluator nei definéieren, Iwwerwaachung an den KI-Design abauen, un déi dräi C’s denken - Kontroll, Contestabilitéit a Kompetenz - an da wäert Dir net nëmmen Reglementer wéi den AI Act respektéieren - Dir wäert e méi vertrauenswierdegen a mächtege System schafen, dee mat de Leit schafft.