Surveillance humaine de l'IA

La surveillance humaine dans les systèmes d’IA est une exigence de conformité :

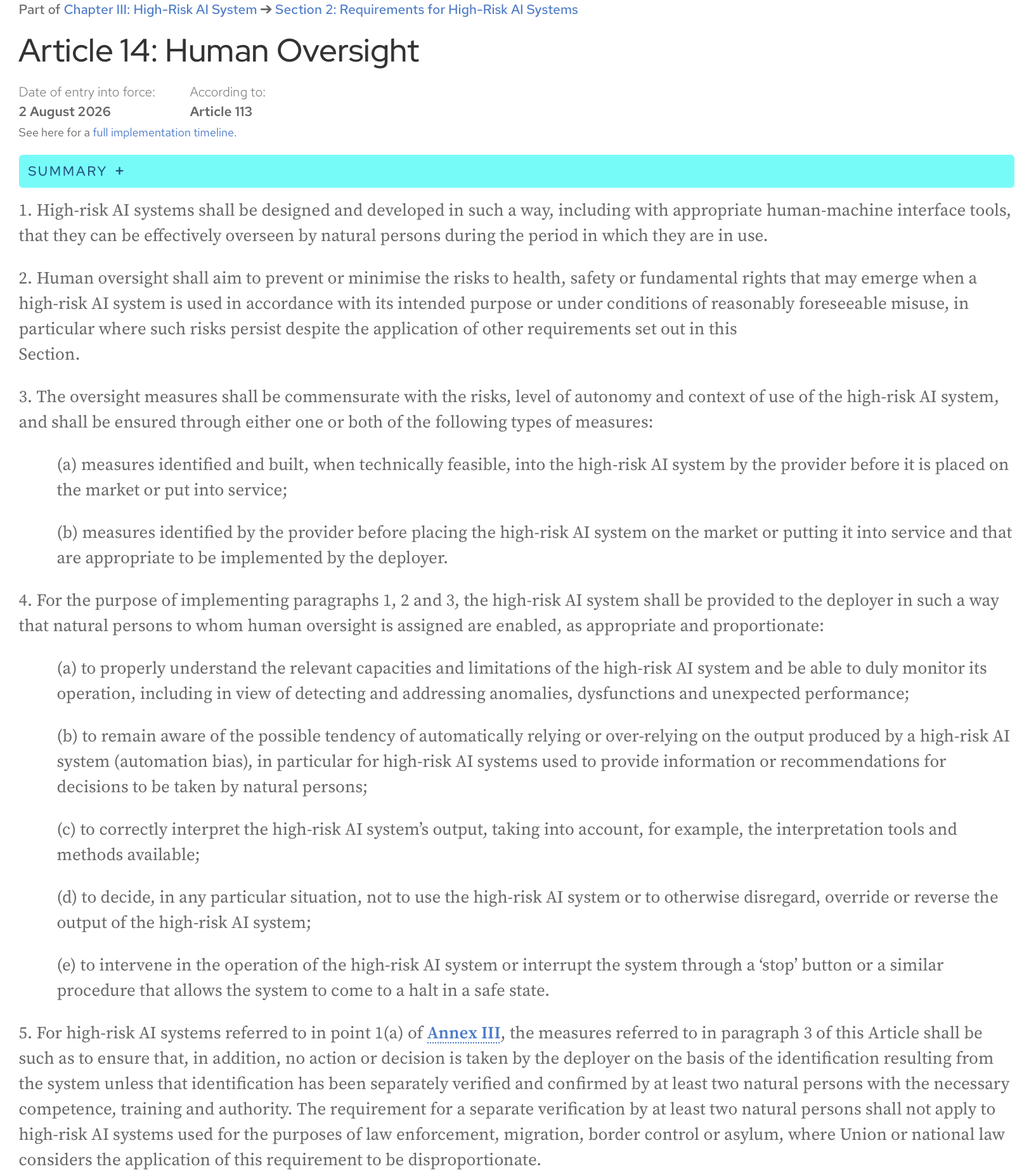

Loi sur l’IA, article 14 : Les systèmes d’IA à haut risque doivent être conçus et développés de manière à pouvoir être efficacement supervisés par des personnes physiques pendant la période où ils sont utilisés, y compris avec des outils d’interface homme-machine appropriés.

Voici le texte intégral de l’article de la page Web officielle de la loi sur l’IA :

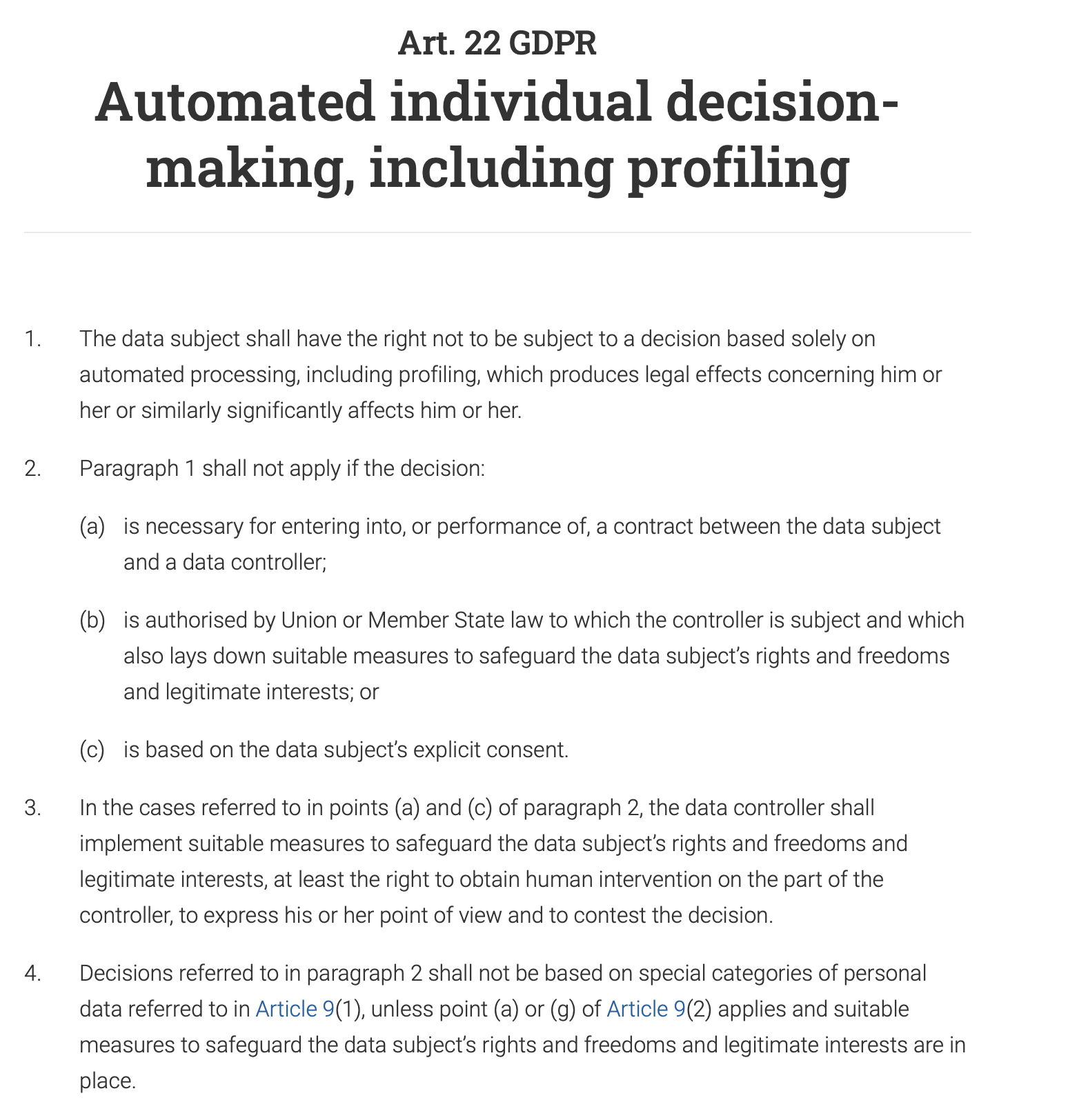

L’article 22 du RGPD accorde explicitement aux individus le droit de « ne pas faire l’objet d’une décision fondée exclusivement sur un traitement automatisé, y compris le profilage, produisant des effets juridiques la concernant ou l’affectant de manière significative de façon similaire ». Cela signifie que pour tout système de prise de décision automatisé ayant un impact majeur sur un individu (par exemple, refuser une demande de prêt, une offre d’emploi ou une prestation publique), un humain doit être impliqué dans le processus pour examiner et valider la décision. L’individu a également le droit de contester la décision automatisée et d’obtenir une intervention humaine.

Et, sans surprise, la surveillance humaine est une exigence clé à la fois dans la norme ISO 42001 et dans le cadre de gestion des risques de l’IA du NIST (AI RMF). Les deux cadres, bien que différents dans leur approche, soulignent la nécessité d’une intervention humaine pour garantir une utilisation responsable et éthique des systèmes d’IA.

Ce billet est mon interprétation de l’article qui a été présenté lors de la récente session du chat mensuel sur l’adoption et l’assurance de l’IA de Data61 - « Concevoir une surveillance humaine significative dans l’IA » (https://www.researchgate.net/publication/395540553_Designing_Meaningful_Human_Oversight_in_AI).

(la citation complète de l’article : Zhu, Liming & Lu, Qinghua & Ding, Ming & Lee, Sunny & Wang, Chen & Data, & Csiro, & Australia,. (2025). Designing Meaningful Human Oversight in AI. 10.13140/RG.2.2.16624.11528)

L’article traite du problème de l’approche actuelle de la surveillance humaine et présente des conseils pratiques pour les développeurs de systèmes d’IA.

Qu’est-ce que la surveillance humaine et comment est-elle effectuée ?

Le problème avec la surveillance humaine est qu’elle est mal définie. Mais, à mon avis, ce qui complique tout, c’est notre biais d’automatisation naturel - une tendance à faire confiance à la sortie d’une machine plutôt qu’à notre propre jugement. Combien de fois avez-vous suivi aveuglément un GPS sur une route inexistante ?

En conséquence, nous approuvons la sortie du système sans la comprendre correctement (nous la « tamponnons »).

Par exemple, le système d’IA d’une banque peut signaler votre transaction comme étant à haut risque, et un analyste humain, chargé d’examiner des milliers d’alertes de ce type quotidiennement, approuve automatiquement la décision de l’IA et gèle votre compte.

Le scénario inverse est également courant : nous contraignons tellement le système qu’au lieu de lui donner un objectif de haut niveau et une certaine liberté pour explorer les compromis et trouver des compromis, nous essayons de préprogrammer chaque action qu’il doit entreprendre et le réduisons ainsi à un système d’automatisation basé sur des règles.

Une entreprise souhaite qu’un chatbot IA gère les demandes des clients. Au lieu de lui donner un objectif de haut niveau comme « résoudre le problème du client poliment et efficacement », vous le programmez avec un script rigide qui dicte que si un client demande : « Comment puis-je retourner un produit ? », le bot doit répondre avec un lien vers la page des retours, puis demander : « Cette réponse a-t-elle répondu à votre question ? ». Il ne peut pas gérer les questions nuancées comme : « J’ai perdu mon reçu, puis-je quand même retourner cet article ? » car les règles ne couvrent pas ce scénario spécifique. Le chatbot perd sa qualité d’agent et devient un arbre de décision basique et frustrant.

L’article soutient qu’aucun de ces scénarios n’est optimal et que l’agence humaine et l’agence de l’IA ne sont pas un jeu à somme nulle. La collaboration des deux produit de meilleurs résultats que ce que l’un ou l’autre pourrait atteindre seul.

Comment la surveillance humaine peut-elle être conçue pour permettre cette collaboration ?

Deux types d’agence

Commençons par la définition de l’agence : c’est la capacité d’agir et de faire bouger les choses par soi-même, pour atteindre un objectif.

L’article suggère de distinguer deux types d’agence :

- Agence opératoire (capacité de l’IA à générer des solutions)

Par exemple, un système d’IA médical génère un diagnostic.

- Agence évaluative (capacité de l’humain à comprendre, juger, vérifier la solution de l’IA et, si nécessaire, à orienter ses résultats ou à les remplacer par des solutions alternatives)

Un médecin ne reproduit pas le processus de diagnostic. Ce n’est pas le travail d’un médecin de refaire le travail de l’IA ou de déjouer la machine. Au lieu de cela, leur rôle est d’évaluer le diagnostic de l’IA. Le médecin se demande : « Est-ce que cela a du sens ? Le raisonnement de l’IA est-il cohérent avec ce qu’un expert humain responsable ferait ? » Ils vérifient la cohérence. Ils examinent la justification de l’IA, qui peut être une liste de symptômes clés et une citation de la littérature médicale. Le médecin vérifie que ce raisonnement correspond à sa propre formation et aux normes médicales. Il ajoute également un contexte humain : sachant que le traitement d’une maladie rare est une thérapie coûteuse, douloureuse et intensive d’un an, il tient compte des préférences du patient, de sa situation financière et de sa volonté de s’engager dans un régime aussi difficile. Enfin, il pèse les avantages potentiels du traitement par rapport à son fardeau important et décide s’il s’agit du plan d’action le plus approprié et le plus éthique, même si le diagnostic de l’IA est techniquement correct.

Il est difficile de ne pas être d’accord avec l’opinion des auteurs selon laquelle « évaluer » est un meilleur mot que « superviser » car il met l’accent sur le rôle humain comme étant actif et critique, plutôt que simplement de surveillance ou symbolique.

L’agence évaluative assure la responsabilité

Si quelque chose ne va pas, un humain est finalement responsable. L’IA ne peut pas être tenue responsable devant un tribunal ; la personne qui a évalué sa sortie le peut. De plus, le jugement de l’humain ancre les actions de l’IA dans des normes professionnelles, éthiques et sociétales que l’IA elle-même ne peut pas comprendre. L’IA peut trouver l’itinéraire le plus rapide, mais seul l’humain peut décider si cet itinéraire est le plus éthique ou le plus sûr. Ces deux avantages sont essentiels à une IA responsable et digne de confiance.

Fidélité du raisonnement interne vs externe

Comment pouvons-nous évaluer les sorties d’un système si nous ne pouvons toujours pas saisir pleinement le fonctionnement interne complexe des modèles d’IA modernes ? Chaque activation de réseau de neurones, chaque ajustement de paramètre, ou comment les connaissances apprises du modèle (comme le concept de « chat ») sont distribuées et stockées dans ses millions ou milliards de paramètres (la mémoire du modèle) - essayer de comprendre ce circuit algorithmique n’est pas réalisable à ce stade du développement de l’IA, et même si c’était le cas, ce serait comme regarder les décisions qu’un programme d’échecs informatique prend à travers le prisme de calculs uniques qu’il effectue - trop de détails, trop complexe et pas très utile pour évaluer réellement les décisions.

Au lieu de cela, nous pouvons concevoir des systèmes de manière à ce qu’ils fournissent des explications qui ont du sens pour un humain - des explications basées sur ce que l’article appelle la « fidélité du raisonnement externe » ou la « plausibilité ». Un programme d’échecs dirait : « J’ai choisi ce coup pour contrôler le centre de l’échiquier et mettre la pression sur le cavalier de l’adversaire », et nous serions en mesure d’évaluer cette décision car son explication correspond aux principes établis des échecs et au jugement humain.

Maintenant, comment concevons-nous un système pour fournir de tels indices que nous pouvons évaluer et, si nécessaire, contester ?

Asymétrie résolution-vérification

L’article introduit un concept utile d’asymétrie résolution-vérification : la difficulté de créer une solution (résoudre) et la difficulté de vérifier cette solution (vérifier) ne sont souvent pas égales. C’est le cas à la fois au moment de la conception et au moment de l’exécution, et le comprendre aide à créer un processus de surveillance humaine efficace.

Lors de la phase de conception, la tâche de « résolution » est l’effort requis pour construire le système d’IA :

- création de l’architecture du système

- spécification des objectifs

- mise en œuvre du système

- conception des tâches de vérification et des seuils à appliquer à de nombreuses instances futures

La tâche de « vérification » est l’effort pour évaluer et valider ce système avant son déploiement :

- examen des exigences

- évaluation de l’architecture et de la conception

- tests

- autres formes de vérification et de validation

Au moment de l’exécution, nous examinons les instances individuelles - les sorties spécifiques du système, les solutions spécifiques qu’il suggère. La tâche de « vérification » ici consiste à évaluer ces sorties uniques. Parfois, les tâches de « résolution » sont très coûteuses en calcul, mais la vérification des sorties est facile ; cependant, il y a des cas où l’IA génère une sortie rapidement mais l’humain qui supervise le système passera beaucoup de temps et d’efforts à la vérifier (par exemple, vérification des faits, examen des biais, garantie de l’alignement du contenu avec les normes, etc.), et la vérification devient un goulot d’étranglement.

Le principal enseignement est qu’une surveillance efficace doit s’adapter à cette asymétrie.

Lorsque la vérification au moment de la conception est facile

Cette stratégie consiste à intégrer la sécurité dès le début. En chargeant à l’avance le processus de vérification, vous pouvez détecter les problèmes potentiels avant même que l’IA ne soit mise en service, ce qui réduit le besoin d’une surveillance manuelle constante.

Par exemple, le bras d’un robot d’usine doit fonctionner avec un haut degré de précision et de sécurité, en restant toujours dans sa zone de travail désignée. La vérification qu’il ne nuira pas à un travailleur humain à proximité est effectuée pendant la phase de conception et de programmation par des tests approfondis, une modélisation et des paramètres de sécurité préprogrammés. L’objectif est de s’assurer que le système est « sûr par conception », rendant l’intervention humaine en temps réel dans ses mouvements de base inutile.

Lorsque la vérification au moment de la conception est difficile

Cet article reconnaît que certaines tâches d’IA sont trop complexes pour être entièrement vérifiées pendant le développement. Dans ces cas, le système peut être conçu pour fournir des informations claires et exploitables à un opérateur humain, qui peut alors prendre une décision finale éclairée. L’humain agit comme le point de contrôle ultime.

Par exemple, un système d’IA qui recommande un diagnostic effectue une tâche très complexe. Sa précision peut être difficile à vérifier entièrement pendant le développement en raison des variations infinies de l’anatomie humaine et des maladies. Par conséquent, le système doit être conçu pour faciliter la vérification au moment de l’exécution : il ne donnera pas seulement un diagnostic, mais fournira également un score de confiance (par exemple, « 95 % de probabilité d’une tumeur bénigne »), mettra en évidence les zones spécifiques d’un scanner qui ont conduit à sa conclusion, ajoutera d’autres citations pertinentes et offrira une explication détaillée de son raisonnement (traces de justification). Un médecin peut alors utiliser ces informations pour poser le diagnostic final et éclairé.

Qu’en est-il des domaines subjectifs où il n’y a pas de bonne réponse ?

Dans des domaines comme l’art, l’éthique ou la planification stratégique, différentes personnes ont des valeurs et des perspectives différentes. Ici, au lieu d’avoir un système d’IA qui « réduit » toute la diversité en une seule réponse « correcte » alors qu’il n’y en a souvent pas, nous devrions concevoir l’IA pour qu’elle soit un partenaire dans une discussion. L’objectif n’est pas d’obtenir une solution parfaite, mais de faire émerger différentes perspectives et scénarios. Cette approche fait du désaccord une partie précieuse du processus, car l’IA peut vous montrer les différents compromis et points de vue. Ce faisant, le système devient plus responsable, car il vous oblige, l’humain, à considérer activement ces options et à prendre une décision réfléchie et bien raisonnée basée sur tous les angles disponibles.

Limite de la délégation

Les auteurs de l’article soulignent qu’il existe une ligne au-delà de laquelle l’IA ne devrait plus être le principal décideur - ils l’appellent la « limite de la délégation ». Dans certains domaines à enjeux élevés comme la détermination de la peine, le diagnostic médical ou l’embauche, le jugement final a un poids éthique et normatif important. Ces décisions ne devraient pas être entièrement déléguées à l’IA. Dans ces cas, la surveillance ne consiste pas seulement à vérifier si la sortie de l’IA est correcte. Il s’agit de sauvegarder la responsabilité humaine. L’IA doit agir comme un outil pour soutenir le décideur humain, en fournissant des données et des informations, mais sans jamais se substituer entièrement à son rôle. La décision finale doit rester entre les mains d’un humain pour garantir la responsabilité éthique et morale.

Les 3 C d’une surveillance humaine efficace

Que devons-nous atteindre lors de la conception du processus de surveillance de l’IA ?

- Contrôle (nous, les humains, pouvons effectuer des interventions opportunes et efficaces pour suspendre, réorienter ou remplacer une décision de l’IA)

- Contestabilité (les décisions de l’IA sont étayées par des raisons et des preuves compréhensibles, de sorte qu’elles peuvent être examinées et contestées)

- Compétence (la surveillance améliore les performances globales et l’équité du système, en évitant les dérogations brutales qui dégraderaient les sorties correctes de l’IA)

Conditions de l’agence et de la surveillance

L’article fait référence aux conditions de l’agence (individualité, source d’action, orientation vers un but et adaptabilité) comme un cadre pour concevoir une surveillance humaine efficace à la fois au moment de la conception et au moment de l’exécution. Vous pouvez en savoir plus sur ces conditions dans un autre article - L’agence dépend du cadre

Examinons chacune de ces conditions - et les conseils pratiques de conception de la surveillance humaine liés à chacune d’elles que l’article propose aux développeurs de systèmes.

Individualité

Cette condition exige une frontière claire entre le rôle de l’IA (agence opératoire) et le rôle de l’humain (agence évaluative). Ici, nous devons créer le plan d’interaction homme-IA où l’IA devrait être libre de travailler de manière autonome, et l’humain ne devrait intervenir qu’à des points de contrôle spécifiques et bien définis. Brouiller ces lignes diffuse la responsabilité.

Moment de la conception

- Définir les limites du système et définir des points de transfert explicites pour l’intervention humaine.

Où se termine le travail de l’IA ? Pas seulement « Le système gérera le service client », mais « Le système répondra aux questions des clients relatives aux spécifications des produits à partir d’une base de connaissances prédéfinie. Il ne gérera pas les litiges de facturation ou les remboursements. »

- Ajouter des conditions d’abstention (le refus de répondre à une requête) lorsque le système doit signaler un cas pour une intervention humaine au lieu de deviner

Par exemple, lorsque le score de confiance est < 90 %, le système signalera à un humain qu’il opère dans une « zone grise ».

- Définir des points de contrôle de transfert humain prédéterminés - où le contrôle passe de l’IA à un humain.

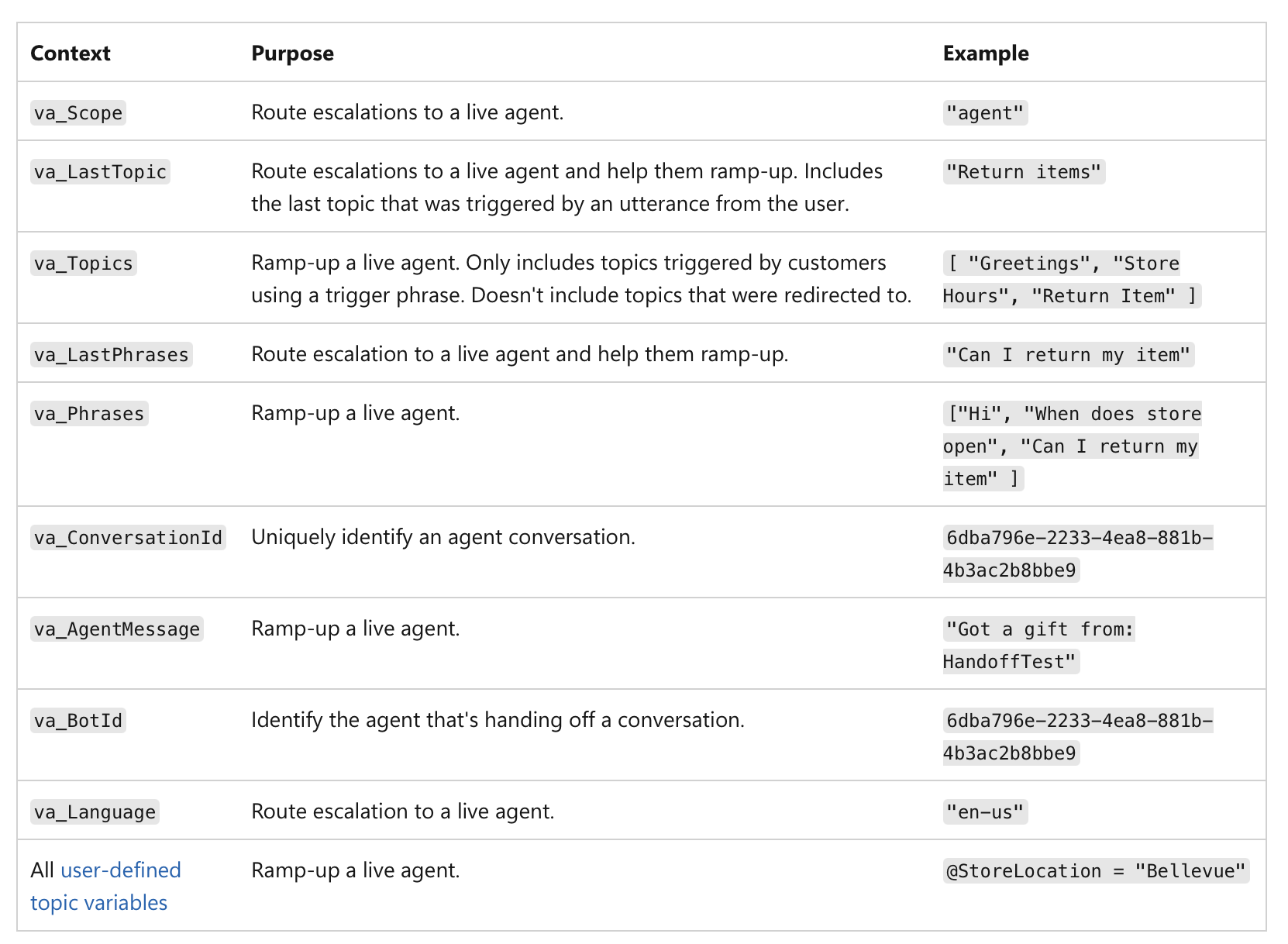

Il ne s’agit pas seulement d’un faible score de confiance, mais de l’importance de l’action elle-même. Par exemple, même si une IA est sûre à 99 %, si la décision implique une transaction financière supérieure à 1 million de dollars ou un diagnostic médical critique, la nature à haut risque de la tâche en fait un point de contrôle humain obligatoire. Voici un exemple de la manière dont le transfert humain peut être mis en œuvre dans les agents MS Copilot :

(source)

(source)

Moment de l’exécution

Une fois le système en service, l’accent est mis sur la journalisation et la responsabilité.

- Journaliser le moment où le contrôle passe réellement de l’IA à l’humain.

Votre système doit créer un enregistrement immuable (par exemple sur une blockchain ou une base de données à écriture unique - pour empêcher la falsification) de chaque transfert : le journal doit inclure un horodatage, la dernière action de l’IA et l’identité de l’humain qui a pris le contrôle :

« Demande de prêt n° 12345 transmise à l’analyste humain Mary Smith à 10h30 en raison d’un score de crédit inférieur au seuil. »

Cela garantit une responsabilité claire pour la décision finale.

Les données journalisées peuvent être utilisées pour créer des tableaux de bord et des rapports de surveillance - vous pouvez voir à quelle fréquence une intervention humaine se produit, si les recommandations de l’IA sont acceptées ou rejetées, et qui prend les décisions finales. Cela nous aide à identifier les domaines où les performances de l’IA pourraient être faibles ou où les processus humains doivent être affinés.

Source de l’action

Ici, nous traçons la cause d’une sortie. Le processus génératif d’une IA est souvent opaque, donc essayer de le « co-posséder » en élaborant méticuleusement des invites peut n’être qu’une illusion de contrôle. Au lieu de cela, la surveillance humaine devrait se concentrer sur l’évaluation de la sortie finale en examinant l’historique causal (invites, entrées, appels à l’IA) (alias provenance).

Moment de la conception

-

S’assurer que le système peut capturer un enregistrement complet de sa provenance grâce à une journalisation de bout en bout (immuable et normalisée pour la lisibilité par machine), où chaque étape du flux de travail de l’IA est automatiquement journalisée et horodatée :

- données d’entrée et invite utilisées

- version spécifique du modèle d’IA utilisée pour générer la sortie

- historique complet des instructions et modifications humaines

- tout appel externe, services externes, API, bases de données auxquels le système d’IA a accédé

- sorties intermédiaires que le système a générées mais a fini par rejeter

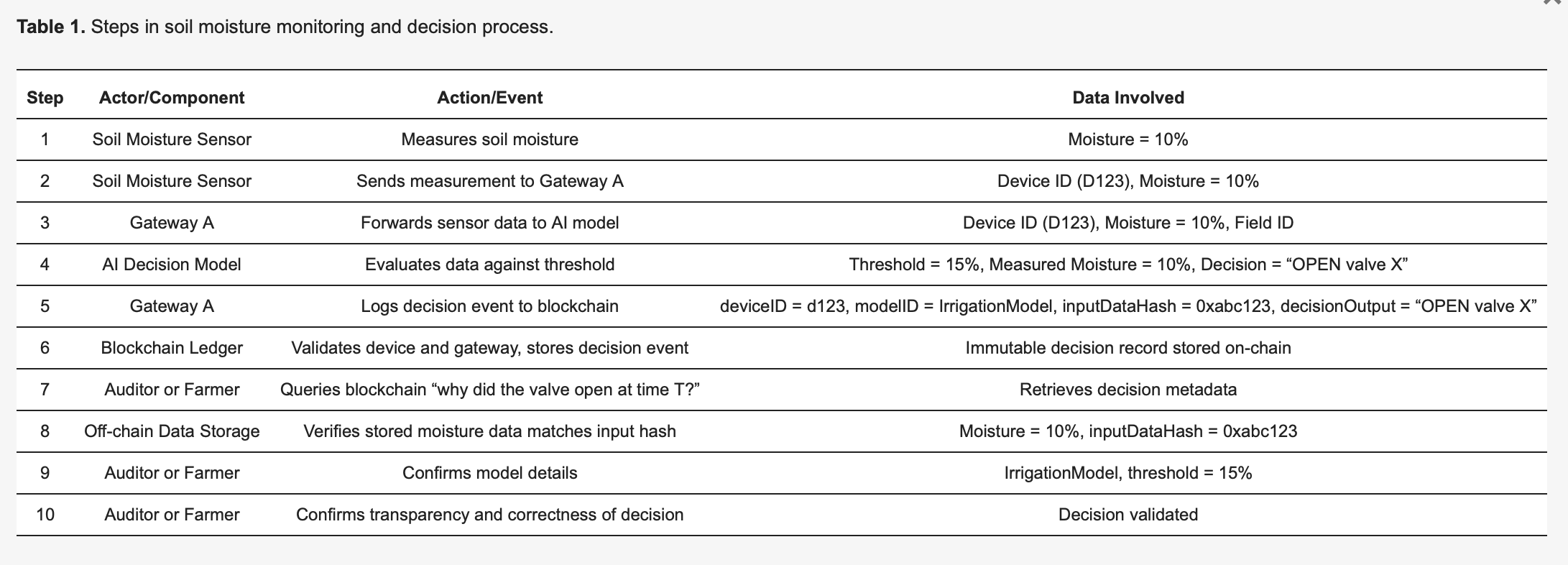

Cette pré-publication de « Utilisation des registres de la blockchain pour enregistrer les décisions de l’IA dans l’IdO », par exemple, explique comment cela peut être fait en pratique : https://www.preprints.org/manuscript/202504.1789/v1 Voici un exemple de cette pré-publication :

Pour concrétiser la méthodologie, considérons un système d’irrigation intelligent basé sur l’IdO [27], détaillé dans le tableau 1. Les capteurs d’humidité du sol (appareils) envoient des lectures à un modèle d’IA en périphérie qui décide si les vannes d’eau doivent s’ouvrir ou rester fermées. Chaque décision prise par l’IA déclenche un événement de journalisation capturé de manière immuable sur un registre de blockchain, améliorant la transparence et l’auditabilité. Comme l’illustre le tableau 1, le capteur 123 détecte une humidité de 10 % et transmet cette mesure à la passerelle A. La passerelle A transmet les données au modèle d’IA, qui, en raison d’un seuil prédéfini de 15 % (spécifié par IrrigationModelv2), détermine l’action appropriée : « vanne = OUVERTE » pour le champ X. La passerelle A prépare ensuite une transaction contenant des métadonnées critiques — y compris l’ID de l’appareil (123), l’ID du modèle (IrrigationModelv2), un hachage des données d’entrée (0xabc123) et le résultat de la décision (OUVRIR la vanne X) — la signe et la soumet à la blockchain. Les nœuds de la blockchain vérifient l’authenticité et les autorisations du capteur 123 et de la passerelle A, confirment qu’ils sont correctement enregistrés pour le champ X, puis stockent l’enregistrement de manière permanente. Un événement est émis pour indiquer une journalisation réussie. Plus tard, un auditeur ou l’agriculteur peut demander « pourquoi l’eau a-t-elle été libérée à l’heure T ? », en récupérant l’enregistrement détaillé de la transaction à partir de la blockchain. Le hachage (0xabc123) de la blockchain peut ensuite être recoupé avec les données des capteurs stockées hors chaîne (stockées sur IPFS ou dans la base de données de la passerelle A) pour confirmer que la lecture d’humidité était bien de 10 %. De plus, en se référant au registre des modèles, l’agriculteur peut valider que le seuil d’irrigation était fixé à 15 % d’humidité, confirmant que la décision de l’IA était correcte et justifiée. Ce processus structuré améliore considérablement la transparence : chaque action automatisée est vérifiable et entièrement explicable grâce aux métadonnées journalisées, et l’immuabilité de la blockchain garantit que ni les opérateurs agricoles ni les fabricants d’appareils ne peuvent modifier secrètement les journaux de décision.

Moment de l’exécution

- Inspecter la chaîne causale pour le cas spécifique afin de voir comment la sortie a été générée.

- Utiliser un tableau de bord visuel qui cartographie l’ensemble de la chaîne causale pour une sortie spécifique afin de voir le résultat final et chaque étape qui y a conduit.

Lorsque vous souhaitez examiner une décision, vous pouvez extraire l’enregistrement de provenance pour ce cas spécifique. Vous n’avez pas besoin de comprendre le « chemin génératif » interne de l’IA (les mathématiques complexes et les activations neuronales). Au lieu de cela, vous vérifiez les métadonnées de provenance pour répondre à des questions comme celles-ci :

« Les bonnes données ont-elles été utilisées ? »

Par exemple, lorsqu’un médecin extrait l’enregistrement de provenance, les métadonnées affichent une liste des points de données spécifiques que l’IA a utilisés. L’enregistrement de provenance confirme que l’IA a utilisé l’historique médical complet du patient, un test sanguin récent du 24/10/25 et une IRM du 26/10/25, et que tous les points de données correspondent au DSE officiel. Dans un cas différent, le médecin peut conclure que l’enregistrement de provenance montre que l’IA a accédé aux données de tests sanguins d’il y a deux ans, mais que le dossier du patient a été mis à jour avec de nouveaux résultats la semaine dernière, et que l’IA a utilisé des informations obsolètes.

« L’invite de l’humain a-t-elle été traitée avec précision ? »

L’invite du médecin à l’IA était « Analyser les symptômes et recommander un diagnostic pour un homme de 45 ans avec une toux persistante et de la fièvre ». L’enregistrement de provenance journalise la requête exacte que l’IA a reçue. Le médecin compare cela à son entrée d’origine et remarque que la requête journalisée montre que l’invite a été tronquée, manquant le symptôme « fièvre » - donc l’IA n’a traité que la « toux persistante », ce qui a conduit à un chemin de diagnostic différent.

« La bonne version du modèle a-t-elle été déployée ? »

L’enregistrement de provenance peut montrer que le diagnostic a été généré par une ancienne version du modèle qui aurait dû être mise hors service en raison d’une erreur système.

Ici, le système attribue clairement les actions soit à la génération autonome de l’IA, soit à l’intervention spécifique d’un humain. Cela permet une responsabilité claire. Si une mauvaise décision est prise, une vérification rapide du journal de provenance peut révéler s’il s’agissait d’une sortie d’IA défectueuse ou d’une erreur d’évaluation humaine, évitant ainsi le « jeu du blâme » où l’agence est diffuse.

Orientation vers un but

L’IA devrait gérer les sous-objectifs de bas niveau, tandis que les humains conservent l’autorité sur les objectifs de haut niveau. Le rôle de l’humain est de s’assurer que le chemin choisi par l’IA correspond aux objectifs et contraintes plus larges, comme les exigences légales ou les objectifs d’équité.

Moment de la conception

- Publier explicitement les objectifs de haut niveau, les contraintes et les règles de compromis pour l’IA.

Les objectifs de haut niveau, définis par l’homme, sont clairs et accessibles. Ce ne sont pas seulement des énoncés de mission vagues ; ce sont des cibles tangibles, souvent numériques. Pour une IA logistique, cela pourrait être « minimiser le temps de livraison de 15 % sans augmenter les coûts de carburant ». Pour une IA de recrutement, un objectif de haut niveau pourrait être « augmenter les candidatures qualifiées de 20 % tout en garantissant l’absence de biais racial ou de genre dans la recherche de candidats ».

- Définir les contraintes et les règles de compromis.

L’autorité humaine s’exprime par des limites et des règles. L’IA doit recevoir des limites explicites qu’elle ne peut pas violer. Par exemple, « rester dans le budget légal », « ne recommander aucune action qui viole les lois sur la protection de la vie privée » ou « donner la priorité à l’équité sur l’efficacité pure ». Dans les cas où les objectifs entrent en conflit (par exemple, vitesse contre coût), les règles de compromis définies par l’homme doivent dicter lequel a la priorité.

Moment de l’exécution

Ici, l’accent est mis sur la surveillance et l’évaluation. Un humain n’a pas besoin de connaître chaque étape de calcul, mais il peut voir si la direction générale de l’IA correspond à l’objectif de plus haut niveau. Nous pouvons évaluer les progrès à des points prédéfinis spécifiques.

- Tester si la sortie actuelle et les sous-objectifs de l’IA sont cohérents avec les objectifs déclarés.

Par exemple, une IA financière peut être autorisée à exécuter plusieurs simulations pour optimiser un portefeuille (sous-objectifs), mais un analyste humain doit approuver la stratégie finale pour s’assurer qu’elle correspond à la tolérance au risque et aux exigences légales du client (objectifs de haut niveau). Ce processus permet à l’IA d’utiliser son « agence opératoire » pour explorer des solutions, tandis que l’humain conserve son « agence évaluative » pour s’assurer que la direction de l’IA reste légitime.

- S’assurer que le système est conçu pour surveiller et rendre compte en permanence de ses progrès vers ses sous-objectifs.

Pour une IA de génération de contenu, cela peut impliquer qu’elle rende compte de ses tentatives de trouver des mots-clés spécifiques ou de sa stratégie de structuration de l’article.

- Le système doit créer un enregistrement clair et traçable de ses décisions, y compris pourquoi il a poursuivi un sous-objectif particulier. Cet enregistrement est mis à la disposition d’un évaluateur humain.

Si une IA génère un résultat biaisé, un auditeur peut retracer son chemin et voir où il a commencé à s’écarter des contraintes d’équité définies au stade de la conception.

Adaptabilité

Un humain ne peut pas raisonnablement superviser chaque changement interne mineur qu’une IA effectue. La surveillance humaine doit être ciblée sur les changements importants, comme les changements de politique ou le comportement global du système. Il s’agit de créer des garde-fous pour le comportement adaptatif de l’IA.

Moment de la conception

- Mettre en place des contrôles de changement et des moniteurs de dérive qui détectent les changements de comportement significatifs.

Le système doit être conçu pour versionner ses propres modèles et configurations afin de permettre de revenir à une version précédente et stable en cas de problème.

Les moniteurs de dérive sont des outils qui suivent en permanence les performances et le comportement de l’IA dans le monde réel. Ils ne mesurent pas seulement la précision ; ils recherchent la dérive conceptuelle (lorsque la relation entre les données d’entrée et de sortie change) et la dérive des données (lorsque les données d’entrée elles-mêmes changent). Les moniteurs sont réglés avec des seuils spécifiques. Par exemple, le moniteur de dérive d’une IA de détection de fraude peut être réglé pour alerter un humain si son taux de faux positifs augmente de plus de 5 %.

Moment de l’exécution

Une fois le système en service, les humains ne le surveillent pas constamment. Ils sont alertés par les moniteurs automatisés, ce qui leur permet de concentrer leur attention efficacement. Lorsqu’un seuil d’un moniteur de dérive est franchi, il envoie automatiquement une alerte à une équipe humaine. L’alerte doit inclure un instantané du comportement observé et les données pertinentes, afin que l’humain puisse rapidement évaluer la situation. Le système peut également être préprogrammé pour suivre un protocole spécifique lorsqu’un changement est détecté.

Qu’est-ce que j’obtiens si je mets en œuvre ce cadre ?

Cette approche crée un partenariat puissant où le système d’IA et l’humain « superviseur » ont chacun un rôle distinct et précieux. L’IA est libre d’utiliser sa puissance de calcul pour s’attaquer à des problèmes complexes (son « agence opératoire »), tandis que l’humain, en utilisant des signaux clairs du système, est habilité à prendre des décisions éclairées de haut niveau et à intervenir si nécessaire (son « agence évaluative »). Le résultat est une collaboration « à somme non nulle », où l’effort combiné conduit à de meilleurs résultats que ce que l’humain ou l’IA pourrait atteindre seul.

Comment ce cadre répond-il à l’article 14 de la loi sur l’IA ?

Le cadre répond directement aux exigences de la loi européenne sur l’IA, en particulier l’article 14, en offrant une approche pratique et exploitable de la « surveillance humaine efficace » qui va au-delà des principes abstraits. Il définit la surveillance non pas comme une obligation vague, mais comme un processus systématique de conception de l’IA pour soutenir l’agence évaluative humaine.

Qu’exige la loi sur l’IA des développeurs de systèmes d’IA ?

- « Des outils d’interface homme-machine appropriés… peuvent être efficacement supervisés. »

Le principe de base du cadre est que le système d’IA lui-même doit être conçu pour permettre la surveillance. Le cadre proposé par l’article offre des caractéristiques de conception fondamentales qui garantissent que le fonctionnement du système est transparent et gérable pour un humain.

- « Viser à prévenir ou à minimiser les risques. »

L’accent mis par le cadre sur l’agence évaluative répond directement à cela. Le rôle de l’humain est de fournir le « jugement d’ordre supérieur » qui ancre les actions de l’IA dans les normes professionnelles et sociétales. C’est le mécanisme de prévention des risques que l’IA, opérant avec son agence opératoire, pourrait ne pas détecter. Les contrôles au moment de la conception du cadre (par exemple, la définition d’objectifs d’équité, l’identification des décisions à haut risque) garantissent que la prévention des risques fait partie intégrante de l’architecture du système, et non une réflexion après coup.

- « Mesures… intégrées au système d’IA à haut risque. »

Toute la structure du cadre est construite autour de cette exigence. Les « artefacts d’IA à exposer » et la « surface de vérification du système » pour chaque condition sont des exemples de mesures qui sont « intégrées… au système d’IA à haut risque par le fournisseur ».

La condition d’individualité exige que le système soit conçu avec des contrats d’API de transfert clairs. La condition d’adaptabilité exige des moniteurs de dérive et des mécanismes de restauration intégrés. Ce sont toutes des mesures concrètes mises en œuvre par le fournisseur.

Le cadre guide également le fournisseur dans l’identification des mesures pour le déployeur. Par exemple, la condition de source d’action exige que le fournisseur fournisse au déployeur un tableau de bord de provenance, qui est une mesure clé que le déployeur doit mettre en œuvre et utiliser.

- « Surveillance humaine… activée, selon le cas et de manière proportionnée. » Le cadre traduit directement chaque point de ce sous-article en une exigence de conception.

a) « Comprendre correctement les capacités et les limites pertinentes »

Les conditions d’individualité et d’orientation vers un but répondent à cela en exigeant une documentation explicite des limites, des objectifs et des contraintes de l’IA. Cela fournit à l’humain une compréhension claire des capacités de l’IA.

b) « Rester conscient de… le biais d’automatisation »

Le cadre promeut l’agence évaluative comme contrepoids au biais d’automatisation. L’accent mis sur la vérification des sorties de l’IA plutôt que sur leur simple acceptation oblige l’humain à rester engagé et fournit un mécanisme pour passer outre l’IA si nécessaire.

c) « Interpréter correctement la… sortie »

La condition de source d’action garantit que la sortie de l’IA est accompagnée de métadonnées et d’enregistrements de provenance interprétables. Cela permet à l’humain d’interpréter correctement le contexte et la chaîne causale de la sortie, rendant possible un simple jugement.

d) « Décider… de ne pas utiliser… ou d’ignorer… la sortie »

La condition d’individualité soutient directement cela en exigeant des points de transfert explicites et des mécanismes de « refus de répondre et de transfert à un humain », donnant à l’humain le pouvoir d’intervenir et de passer outre le système.

e) « Intervenir… ou interrompre… via un bouton ‘stop’ »

Les mécanismes de restauration et d’abstention de la condition d’adaptabilité fournissent l’équivalent fonctionnel d’un bouton « stop ». Ils permettent à un humain d’arrêter ou d’annuler le fonctionnement de l’IA de manière sûre et contrôlée.

f) « Vérification par au moins deux personnes physiques. »

Le cadre fournit les outils pour en faire un processus réalisable et significatif. L’enregistrement de provenance de la condition de source d’action et un journal clair de toutes les interactions humaines permettent à deux personnes ou plus de vérifier indépendamment l’identification d’une IA. Elles peuvent toutes deux extraire le même ensemble de données journalisées et examiner la chaîne causale pour parvenir à un consensus, garantissant que la vérification est basée sur des preuves objectives plutôt que sur des suppositions subjectives.

Défis

Bien sûr, bien que le cadre semble très prometteur et applicable, l’article n’ignore pas les inconvénients courants de la mise en œuvre des mécanismes de surveillance.

Complexité et coût

Premièrement, tous ne sont pas simples à mettre en place - beaucoup nécessitent un effort initial important pour la conception et la construction. Vous avez besoin d’une expertise spécialisée pour créer des systèmes capables de générer des justifications structurées, de capturer la provenance ou d’encoder des règles nuancées dans un registre d’objectifs. De plus, préparez-vous à des coûts permanents de maintenance du système, de calibrage des signaux et de formation des examinateurs humains aux nouveaux processus.

Dépendance au signal

L’efficacité de ces mécanismes de surveillance dépend fortement de la qualité des signaux qu’ils produisent. Si l’IA génère des signaux de mauvaise qualité ou bruités (par exemple, des scores de confiance inexacts, des justifications vagues ou des données de provenance erronées), cela peut induire en erreur l’examinateur humain et saper tout le processus de surveillance.

Fardeau de la vérification

Bien que l’objectif soit d’améliorer l’efficacité, ces systèmes n’éliminent pas complètement la charge de travail humaine. Dans les cas limites, nouveaux ou ambigus, l’examinateur humain peut encore avoir besoin d’effectuer des vérifications ponctuelles manuelles et intensives. L’article note que cela peut réduire les gains d’efficacité, car les examinateurs peuvent avoir besoin de passer beaucoup de temps à résoudre les abstentions ou à contester les suggestions de l’IA. Le fardeau humain passe d’une évaluation à grande échelle à une vérification détaillée du travail de l’IA, qui peut encore être importante.

N’oubliez pas : un changement de mentalité est nécessaire

Il ne suffit donc pas de dire que nous avons besoin d’une « surveillance humaine ». Pour en faire une réalité, nous devons changer notre mentalité, passer de la simple « supervision de l’IA » à la conception de l’IA pour la collaboration homme-IA : redéfinir le rôle de l’humain en tant qu’évaluateur actif, intégrer la surveillance dans la conception de l’IA, se souvenir des trois C - contrôle, contestabilité et compétence - et alors vous ne vous conformerez pas seulement aux réglementations comme la loi sur l’IA - vous créerez un système plus digne de confiance et plus puissant qui fonctionne avec les gens.