Supervisión humana de la IA

La supervisión humana en los sistemas de IA es un requisito de cumplimiento:

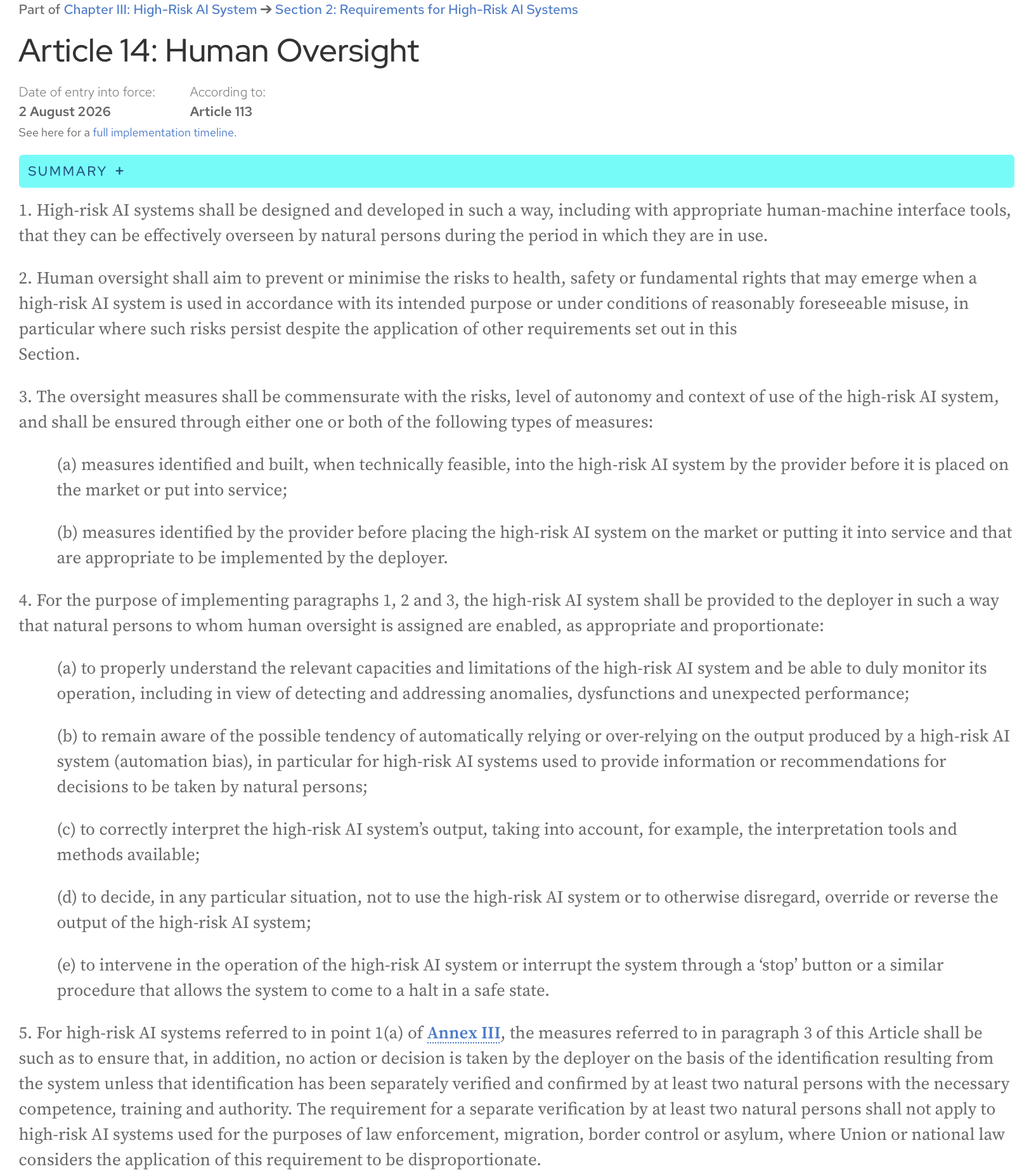

Ley de IA, artículo 14: Los sistemas de IA de alto riesgo se diseñarán y desarrollarán de tal manera, incluso con las herramientas de interfaz hombre-máquina adecuadas, que puedan ser supervisados eficazmente por personas físicas durante el período en que se utilicen.

Aquí está el texto completo del artículo de la página web oficial de la Ley de IA:

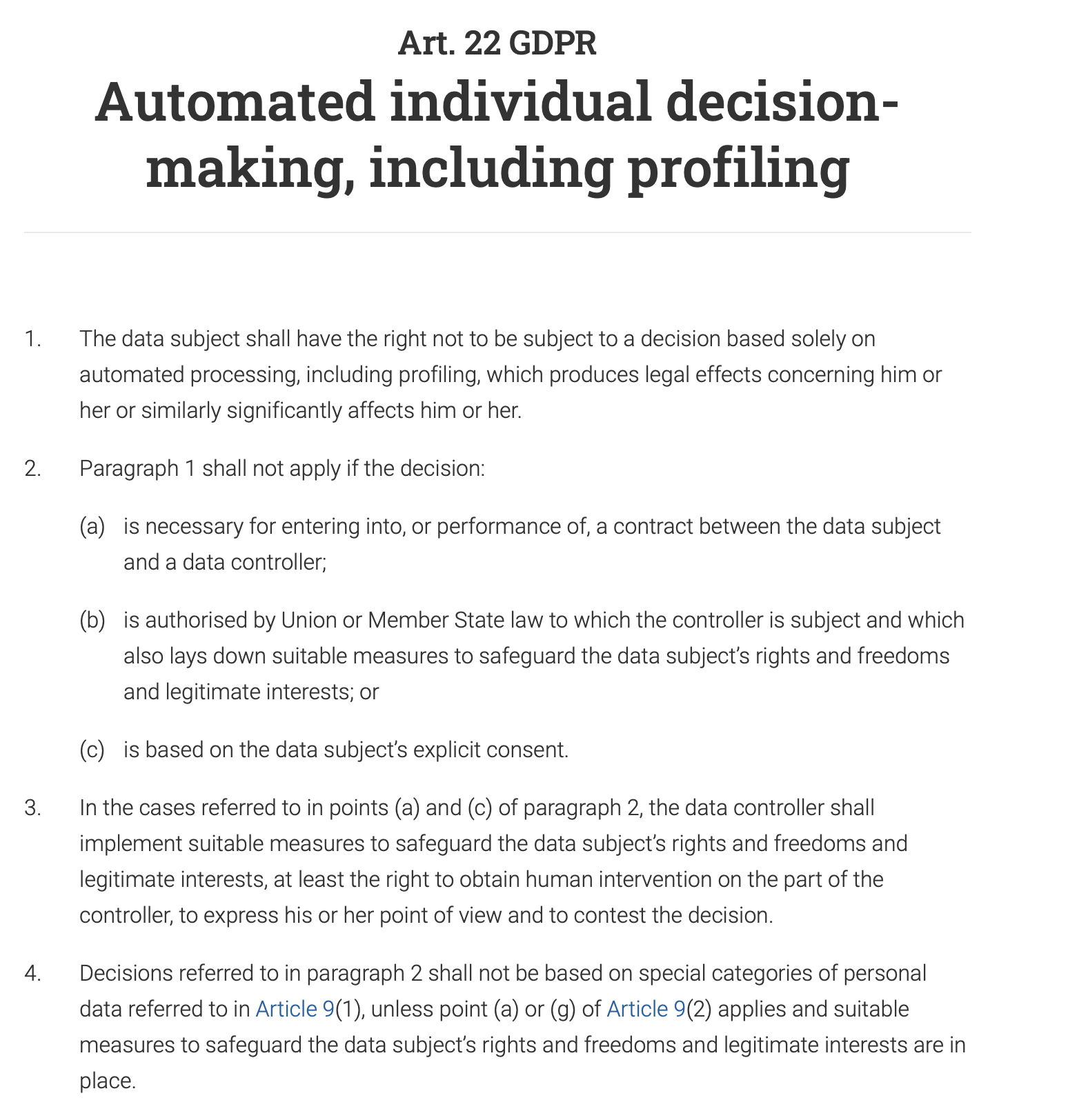

El artículo 22 del RGPD otorga explícitamente a las personas el derecho a «no ser objeto de una decisión basada únicamente en el tratamiento automatizado, incluida la elaboración de perfiles, que produzca efectos jurídicos en él o ella o le afecte significativamente de modo similar». Esto significa que para cualquier sistema de toma de decisiones automatizado que tenga un impacto importante en una persona (por ejemplo, denegar una solicitud de préstamo, una oferta de trabajo o una prestación pública), un ser humano debe participar en el proceso para revisar y validar la decisión. La persona también tiene derecho a impugnar la decisión automatizada y a obtener la intervención humana.

Y, como era de esperar, la supervisión humana es un requisito clave tanto en la norma ISO 42001 como en el Marco de gestión de riesgos de la IA del NIST (AI RMF). Ambos marcos, aunque diferentes en su enfoque, enfatizan la necesidad de la intervención humana para garantizar el uso responsable y ético de los sistemas de IA.

Esta publicación es mi interpretación del artículo que se presentó en la sesión reciente del Chat mensual sobre adopción y garantía de la IA de Data61 - «Diseño de una supervisión humana significativa en la IA» (https://www.researchgate.net/publication/395540553_Designing_Meaningful_Human_Oversight_in_AI).

(la cita completa del artículo: Zhu, Liming & Lu, Qinghua & Ding, Ming & Lee, Sunny & Wang, Chen & Data, & Csiro, & Australia,. (2025). Designing Meaningful Human Oversight in AI. 10.13140/RG.2.2.16624.11528)

El artículo analiza el problema del enfoque actual de la supervisión humana y presenta consejos prácticos para los desarrolladores de sistemas de IA.

¿Qué es la supervisión humana y cómo se realiza?

El problema de la supervisión humana es que está mal definida. Pero, en mi opinión, lo que complica todo es nuestro sesgo de automatización natural: una tendencia a confiar en el resultado de una máquina por encima de nuestro propio juicio. ¿Cuántas veces ha seguido ciegamente un GPS por una carretera inexistente?

Como resultado, o bien aprobamos el resultado del sistema sin entenderlo adecuadamente (lo «sellamos»).

Por ejemplo, el sistema de IA de un banco puede marcar su transacción como de alto riesgo, y un analista humano, encargado de revisar miles de alertas de este tipo a diario, aprueba automáticamente la decisión de la IA y congela su cuenta.

El escenario opuesto también es común: restringimos tanto el sistema que, en lugar de darle un objetivo de alto nivel y cierta libertad para explorar compensaciones y encontrar compromisos, intentamos preprogramar cada acción que debe realizar y, por lo tanto, lo reducimos a un sistema de automatización basado en reglas.

Una empresa quiere que un chatbot de IA gestione las consultas de los clientes. En lugar de darle un objetivo de alto nivel como «resolver el problema del cliente de forma educada y eficiente», lo programas con un guion rígido que dicta que si un cliente pregunta: «¿Cómo devuelvo un producto?», el bot debe responder con un enlace a la página de devoluciones y luego preguntar: «¿Respondió esto a su pregunta?». No puede gestionar preguntas matizadas como: «Perdí mi recibo, ¿puedo devolver esto?», porque las reglas no cubren ese escenario específico. El chatbot pierde su cualidad de agente y se convierte en un árbol de decisiones básico y frustrante.

El artículo argumenta que ninguno de estos escenarios es óptimo y que la agencia humana y la agencia de la IA no son un juego de suma cero. La colaboración de ambos produce mejores resultados que los que cualquiera de ellos podría lograr por sí solo.

¿Cómo se puede diseñar la supervisión humana para permitir esta colaboración?

Dos tipos de agencia

Comencemos por la definición de agencia: es la capacidad de actuar y hacer que las cosas sucedan por uno mismo, para lograr un objetivo.

El artículo sugiere distinguir entre los dos tipos de agencia:

- Agencia operativa (la capacidad de la IA para generar soluciones)

Por ejemplo, un sistema de IA médico genera un diagnóstico.

- Agencia evaluativa (la capacidad del ser humano para comprender, juzgar, verificar la solución de la IA y, cuando sea necesario, dirigir sus resultados o sustituirlos por soluciones alternativas)

Un médico no replica el proceso de diagnóstico. No es trabajo de un médico rehacer el trabajo de la IA o ser más listo que la máquina. En cambio, su función es evaluar el diagnóstico de la IA. El médico se pregunta: «¿Tiene esto sentido? ¿Es el razonamiento de la IA coherente con lo que haría un experto humano responsable?». Comprueban la coherencia. Revisan la justificación de la IA, que podría ser una lista de síntomas clave y una cita de la literatura médica. El médico verifica que este razonamiento se alinee con su propia formación y las normas médicas. También añaden el contexto humano: sabiendo que el tratamiento para una enfermedad rara es una terapia costosa, dolorosa e intensiva de un año, consideran las preferencias del paciente, su situación financiera y si está dispuesto a comprometerse con un régimen tan difícil. Finalmente, sopesan los beneficios potenciales del tratamiento frente a su carga significativa y deciden si es el curso de acción más apropiado y ético, incluso si el diagnóstico de la IA es técnicamente correcto.

Es difícil no estar de acuerdo con la opinión de los autores de que «evaluar» es una palabra mejor que «supervisar» porque enfatiza el papel humano como activo y crítico, en lugar de meramente supervisor o simbólico.

La agencia evaluativa proporciona responsabilidad

Si algo sale mal, un ser humano es el responsable último. La IA no puede ser considerada responsable en un tribunal; la persona que evaluó su resultado sí puede. Además, el juicio del ser humano ancla las acciones de la IA a las normas profesionales, éticas y sociales que la propia IA no puede comprender. La IA puede encontrar la ruta más rápida, pero solo el ser humano puede decidir si esa ruta es la más ética o segura. Estos dos beneficios son clave para una IA responsable y fiable.

Fidelidad del razonamiento interno frente al externo

¿Cómo podemos evaluar los resultados de un sistema si todavía no podemos comprender completamente el complejo funcionamiento interno de los modelos de IA modernos? Cada activación de la red neuronal, cada ajuste de parámetros, o cómo el conocimiento aprendido del modelo (como el concepto de un «gato») se distribuye y almacena dentro de sus millones o miles de millones de parámetros (la memoria del modelo): tratar de comprender este circuito algorítmico no es factible en esta etapa del desarrollo de la IA, e incluso si lo fuera, sería como mirar las decisiones que toma un programa de ajedrez por ordenador a través del prisma de los cálculos individuales que realiza: demasiados detalles, demasiado complejo y no muy útil para evaluar realmente las decisiones.

En cambio, podemos diseñar sistemas de tal manera que proporcionen explicaciones que tengan sentido para un ser humano, explicaciones basadas en lo que el artículo denomina «fidelidad del razonamiento externo» o «plausibilidad». Un programa de ajedrez diría: «Elegí este movimiento para controlar el centro del tablero y presionar al caballo del oponente», y podríamos evaluar esta decisión porque su explicación se alinea con los principios establecidos del ajedrez y el juicio humano.

Ahora, ¿cómo diseñamos un sistema para proporcionar tales pistas que podamos evaluar y, si es necesario, impugnar?

Asimetría resolver-verificar

El artículo introduce un concepto útil de asimetría resolver-verificar: la dificultad de crear una solución (resolver) y la dificultad de comprobar esa solución (verificar) a menudo no son iguales. Este es el caso tanto en el momento del diseño como en el momento de la ejecución, y comprenderlo ayuda a crear un proceso de supervisión humana eficaz.

En la fase de diseño, la tarea de «resolver» es el esfuerzo necesario para construir el sistema de IA:

- crear la arquitectura del sistema

- especificar los objetivos

- implementar el sistema

- diseñar tareas de verificación y umbrales para aplicar en muchas instancias futuras

La tarea de «verificar» es el esfuerzo para evaluar y validar ese sistema antes de su implementación:

- revisión de requisitos

- evaluación de la arquitectura y el diseño

- pruebas

- otras formas de verificación y validación

En tiempo de ejecución, observamos instancias individuales: resultados específicos del sistema, soluciones específicas que sugiere. La tarea de «verificar» aquí es evaluar estos resultados únicos. A veces, las tareas de «resolver» son muy costosas desde el punto de vista computacional, pero comprobar los resultados es fácil; sin embargo, hay casos en los que la IA genera un resultado rápidamente, pero el ser humano que supervisa el sistema dedicará mucho tiempo y esfuerzo a verificarlo (por ejemplo, comprobación de hechos, revisión de sesgos, garantía de que el contenido se alinee con las normas, etc.), y la verificación se convierte en un cuello de botella.

La conclusión principal es que una supervisión eficaz debe adaptarse a esta asimetrametría.

Cuando la verificación en tiempo de diseño es fácil

Esta estrategia consiste en incorporar la seguridad desde el principio. Al adelantar el proceso de verificación, puede detectar posibles problemas antes incluso de que se ponga en uso la IA, lo que reduce la necesidad de una supervisión manual constante.

Por ejemplo, el brazo de un robot de fábrica debe funcionar con un alto grado de precisión y seguridad, permaneciendo siempre dentro de su área de trabajo designada. La verificación de que no dañará a un trabajador humano cercano se realiza durante la fase de diseño y programación mediante pruebas exhaustivas, modelado y parámetros de seguridad preprogramados. El objetivo es garantizar que el sistema sea «seguro por diseño», lo que hace innecesaria la intervención humana en tiempo real en sus movimientos básicos.

Cuando la verificación en tiempo de diseño es difícil

Este artículo reconoce que algunas tareas de IA son demasiado complejas para ser verificadas por completo durante el desarrollo. En estos casos, el sistema puede diseñarse para proporcionar información clara y procesable a un operador humano, quien luego puede tomar una decisión final informada. El ser humano actúa como el punto de control final.

Por ejemplo, un sistema de IA que recomienda un diagnóstico está realizando una tarea muy compleja. Su precisión puede ser difícil de verificar por completo durante el desarrollo debido a las infinitas variaciones en la anatomía humana y las enfermedades. Por lo tanto, el sistema debe diseñarse para facilitar la verificación en tiempo de ejecución: no solo dará un diagnóstico, sino que también proporcionará una puntuación de confianza (por ejemplo, «95 % de probabilidad de un tumor benigno»), resaltará las áreas específicas de una exploración que llevaron a su conclusión, agregará otras citas relevantes y ofrecerá una explicación detallada de su razonamiento (rastros de justificación). Un médico puede entonces utilizar esta información para realizar el diagnóstico final e informado.

¿Qué pasa con los dominios subjetivos donde no hay una respuesta correcta?

En áreas como el arte, la ética o la planificación estratégica, diferentes personas tienen diferentes valores y perspectivas. Aquí, en lugar de tener un sistema de IA que «colapsa» toda la diversidad en una única respuesta «correcta» donde a menudo no la hay, deberíamos diseñar la IA para que sea un socio en una discusión. El objetivo no es obtener una solución perfecta, sino sacar a la luz diferentes perspectivas y escenarios. Este enfoque hace que el desacuerdo sea una parte valiosa del proceso, ya que la IA puede mostrarle las diversas compensaciones y puntos de vista. Al hacer esto, el sistema se vuelve más responsable, porque te obliga a ti, el ser humano, a considerar activamente estas opciones y a tomar una decisión reflexiva y bien razonada basada en todos los ángulos disponibles.

Límite de delegación

Los autores del artículo enfatizan que hay una línea más allá de la cual la IA ya no debería ser el principal responsable de la toma de decisiones; la llaman «límite de delegación». En ciertos campos de alto riesgo como la sentencia legal, el diagnóstico médico o la contratación, el juicio final conlleva un peso ético y normativo significativo. Estas decisiones no deben delegarse por completo a la IA. En estos casos, la supervisión no consiste solo en comprobar si el resultado de la IA es correcto. Se trata de salvaguardar la responsabilidad humana. La IA debe actuar como una herramienta para apoyar al responsable de la toma de decisiones humano, proporcionando datos y conocimientos, pero sin sustituir nunca por completo su función. La decisión final debe recaer en un ser humano para garantizar la responsabilidad ética y moral.

Las 3 C de una supervisión humana eficiente

¿Qué debemos lograr al diseñar el proceso de supervisión de la IA?

- Control (los humanos podemos realizar intervenciones oportunas y eficaces para pausar, redirigir o sustituir una decisión de la IA)

- Contestabilidad (las decisiones de la IA están respaldadas por razones y pruebas comprensibles, por lo que pueden ser revisadas y cuestionadas)

- Competencia (la supervisión mejora el rendimiento general y la equidad del sistema, evitando anulaciones contundentes que degradarían los resultados correctos de la IA)

Condiciones de la agencia y la supervisión

El artículo se refiere a las condiciones de la agencia (individualidad, fuente de acción, orientación a objetivos y adaptabilidad) como un marco para diseñar una supervisión humana eficaz tanto en el momento del diseño como en el momento de la ejecución. Puede leer más sobre estas condiciones en otro artículo: La agencia depende del marco

Veamos cada una de estas condiciones y los consejos prácticos de diseño de la supervisión humana relacionados con cada una de ellas que el artículo ofrece a los desarrolladores de sistemas.

Individualidad

Esta condición requiere un límite claro entre el papel de la IA (agencia operativa) y el papel del ser humano (agencia evaluativa). Aquí necesitamos crear el plan para la interacción hombre-IA donde la IA debe ser libre de trabajar de forma autónoma, y el ser humano debe intervenir solo en puntos de control específicos y bien definidos. Desdibujar estas líneas difumina la responsabilidad.

Momento del diseño

- Definir los límites del sistema y establecer puntos de transferencia explícitos para la intervención humana.

¿Dónde termina el trabajo de la IA? No solo «El sistema se encargará del servicio al cliente», sino «El sistema responderá a las preguntas de los clientes relacionadas con las especificaciones del producto a partir de una base de conocimientos predefinida. No se encargará de las disputas de facturación ni de los reembolsos».

- Añadir condiciones de abstención (la negativa a responder a una consulta) cuando el sistema tenga que marcar un caso para la intervención humana en lugar de adivinar.

Por ejemplo, cuando la puntuación de confianza sea < 90 %, el sistema señalará a un ser humano que está operando en una «zona gris».

- Definir puntos de control de transferencia humana predeterminados, donde el control pasa de la IA a un ser humano.

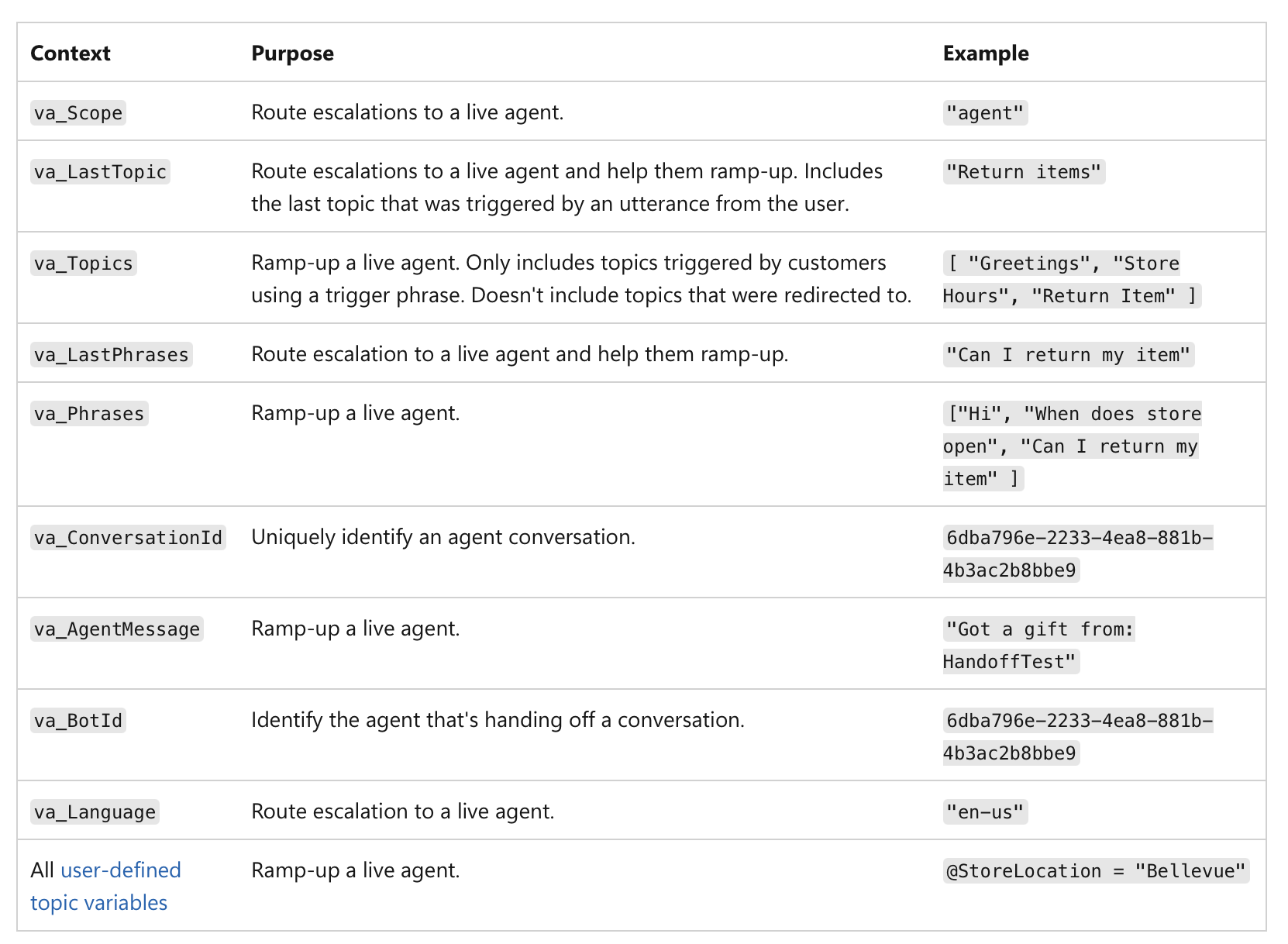

No se trata solo de una puntuación de confianza baja, sino de la importancia de la propia acción. Por ejemplo, incluso si una IA tiene un 99 % de confianza, si la decisión implica una transacción financiera superior a 1 millón de dólares o un diagnóstico médico crítico, la naturaleza de alto riesgo de la tarea la convierte en un punto de control humano obligatorio. Aquí hay un ejemplo de cómo se puede implementar la transferencia humana en los agentes de MS Copilot:

(fuente)

(fuente)

Momento de la ejecución

Una vez que el sistema está en funcionamiento, el enfoque se desplaza hacia el registro y la rendición de cuentas.

- Registrar cuándo el control pasa realmente de la IA al ser humano.

Su sistema debe crear un registro inmutable (por ejemplo, en una cadena de bloques o en una base de datos de escritura única para evitar manipulaciones) de cada transferencia: el registro debe incluir una marca de tiempo, la acción final de la IA y la identidad del ser humano que tomó el control:

«Solicitud de préstamo n.º 12345 transferida al analista humano Mary Smith a las 10:30 a. m. debido a una puntuación de crédito por debajo del umbral».

Esto garantiza una clara rendición de cuentas de la decisión final.

Los datos registrados se pueden utilizar para crear paneles e informes para la supervisión: puede ver con qué frecuencia se produce la intervención humana, si se aceptan o rechazan las recomendaciones de la IA y quién toma las decisiones finales. Esto nos ayuda a identificar áreas en las que el rendimiento de la IA podría ser débil o en las que los procesos humanos necesitan perfeccionarse.

Fuente de la acción

Aquí rastreamos la causa de un resultado. El proceso generativo de una IA suele ser opaco, por lo que intentar «ser copropietario» de él elaborando meticulosamente las indicaciones puede ser solo una ilusión de control. En cambio, la supervisión humana debería centrarse en evaluar el resultado final revisando el historial causal (indicaciones, entradas, llamadas a la IA) (también conocido como procedencia).

Momento del diseño

-

Asegurarse de que el sistema pueda capturar un registro completo de su procedencia a través de un registro de extremo a extremo (inmutable y estandarizado para la legibilidad por máquina), donde cada paso en el flujo de trabajo de la IA se registra y se marca con la hora automáticamente:

- datos de entrada e indicación utilizados

- versión específica del modelo de IA utilizado para generar el resultado

- historial completo de instrucciones y modificaciones humanas

- cualquier llamada externa, servicios externos, API, bases de datos a las que accedió el sistema de IA

- resultados intermedios que el sistema generó pero que acabó descartando

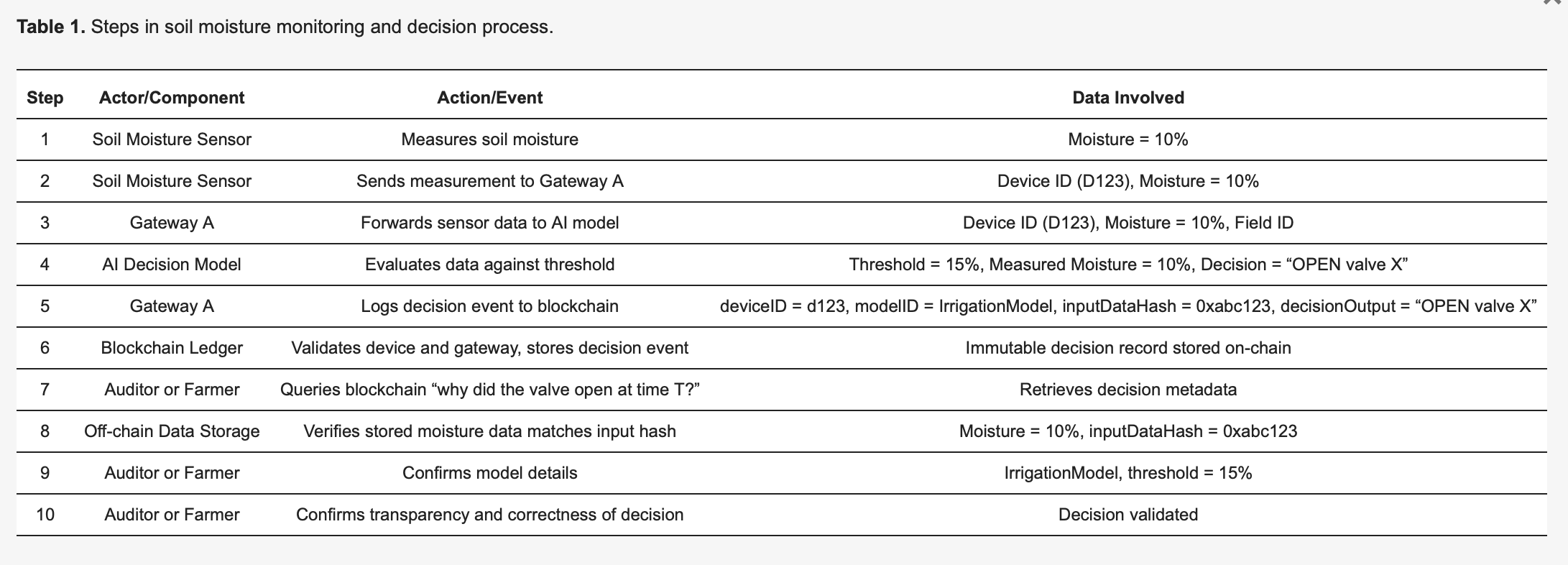

Esta preimpresión de «Uso de libros de contabilidad de cadena de bloques para registrar las decisiones de la IA en el IoT», por ejemplo, analiza cómo se puede hacer esto en la práctica: https://www.preprints.org/manuscript/202504.1789/v1 Aquí hay un ejemplo de esta preimpresión:

Para concretar la metodología, considere un sistema de riego inteligente basado en IoT [27], detallado en la Tabla 1. Los sensores de humedad del suelo (dispositivos) envían lecturas a un modelo de IA perimetral que decide si las válvulas de agua deben abrirse o permanecer cerradas. Cada decisión tomada por la IA desencadena un evento de registro capturado de forma inmutable en un libro de contabilidad de cadena de bloques, lo que mejora la transparencia y la auditabilidad. Como se ilustra en la Tabla 1, el sensor 123 detecta una humedad del 10 por ciento y transmite esta medición a la puerta de enlace A. La puerta de enlace A reenvía los datos al modelo de IA, que, debido a un umbral predefinido del 15 por ciento (especificado por IrrigationModelv2), determina la acción apropiada: «válvula = ABIERTA» para el campo X. La puerta de enlace A luego prepara una transacción que contiene metadatos críticos, incluido el ID del dispositivo (123), el ID del modelo (IrrigationModelv2), un hash de los datos de entrada (0xabc123) y el resultado de la decisión (ABRIR válvula X), la firma y la envía a la cadena de bloques. Los nodos de la cadena de bloques verifican la autenticidad y los permisos del sensor 123 y la puerta de enlace A, confirman que están registrados correctamente en el campo X y, posteriormente, almacenan el registro de forma permanente. Se emite un evento para indicar que el registro se ha realizado correctamente. Más tarde, un auditor o el agricultor pueden consultar «¿por qué se liberó agua en el momento T?», recuperando el registro detallado de la transacción de la cadena de bloques. El hash (0xabc123) de la cadena de bloques se puede cotejar con los datos del sensor almacenados fuera de la cadena (almacenados en IPFS o en la base de datos de la puerta de enlace A) para confirmar que la lectura de humedad fue efectivamente del 10 por ciento. Además, al consultar el registro del modelo, el agricultor puede validar que el umbral de riego se estableció en un 15 por ciento de humedad, lo que confirma que la decisión de la IA fue correcta y justificada. Este proceso estructurado mejora significativamente la transparencia: cada acción automatizada es verificable y totalmente explicable a través de metadatos registrados, y la inmutabilidad de la cadena de bloques garantiza que ni los operadores agrícolas ni los fabricantes de dispositivos puedan modificar en secreto los registros de decisiones.

Momento de la ejecución

- Inspeccionar la cadena causal del caso específico para ver cómo se generó el resultado.

- Utilizar un panel visual que trace toda la cadena causal de un resultado específico para ver el resultado final y cada paso que condujo a él.

Cuando desee revisar una decisión, puede consultar el registro de procedencia de ese caso específico. No necesita comprender la «vía generativa» interna de la IA (las complejas matemáticas y las activaciones neuronales). En cambio, comprueba los metadatos de procedencia para responder a preguntas como estas:

«¿Se utilizaron los datos correctos?»

Por ejemplo, cuando un médico consulta el registro de procedencia, los metadatos muestran una lista de los puntos de datos específicos que utilizó la IA. El registro de procedencia confirma que la IA utilizó el historial médico completo del paciente, un análisis de sangre reciente del 24/10/25 y una resonancia magnética del 26/10/25, y todos los puntos de datos coinciden con el HCE oficial. En un caso diferente, el médico puede concluir que el registro de procedencia muestra que la IA accedió a los datos de los análisis de sangre de hace dos años, pero el historial del paciente se actualizó con nuevos resultados la semana pasada y la IA utilizó información obsoleta.

«¿Se procesó correctamente la indicación del ser humano?»

La indicación del médico a la IA fue «Analizar los síntomas y recomendar un diagnóstico para un varón de 45 años con tos persistente y fiebre». El registro de procedencia registra la consulta exacta que recibió la IA. El médico compara esto con su entrada original y se da cuenta de que la consulta registrada muestra que la indicación se truncó, omitiendo el síntoma de «fiebre», por lo que la IA solo procesó la «tos persistente», lo que condujo a una vía de diagnóstico diferente.

«¿Se implementó la versión correcta del modelo?»

El registro de procedencia puede mostrar que el diagnóstico fue generado por una versión anterior del modelo que debería haber sido retirada debido a un error del sistema.

Aquí, el sistema atribuye claramente las acciones a la generación autónoma de la IA o a la intervención específica de un ser humano. Esto permite una clara rendición de cuentas. Si se toma una mala decisión, una rápida comprobación del registro de procedencia puede revelar si se trató de un resultado defectuoso de la IA o de un error de evaluación humana, lo que evita el «juego de culpas» en el que se difumina la agencia.

Orientación a objetivos

La IA debe gestionar los subobjetivos de bajo nivel, mientras que los humanos conservan la autoridad sobre los objetivos de alto nivel. El papel del ser humano es garantizar que el camino elegido por la IA se alinee con los objetivos y las restricciones más amplios, como los requisitos legales o los objetivos de equidad.

Momento del diseño

- Publicar explícitamente los objetivos de alto nivel, las restricciones y las reglas de compensación para la IA.

Los objetivos de alto nivel, definidos por el ser humano, se hacen claros y accesibles. No son solo declaraciones de misión vagas; son objetivos tangibles, a menudo numéricos. Para una IA de logística, esto podría ser «minimizar el tiempo de entrega en un 15 % sin aumentar los costes de combustible». Para una IA de contratación, un objetivo de alto nivel podría ser «aumentar las solicitudes cualificadas en un 20 % garantizando al mismo tiempo que no haya sesgos raciales o de género en la búsqueda de candidatos».

- Definir restricciones y reglas de compensación.

La autoridad humana se expresa a través de límites y reglas. A la IA se le deben dar límites explícitos que no puede violar. Por ejemplo, «mantenerse dentro del presupuesto legal», «no recomendar ninguna acción que viole las leyes de privacidad» o «priorizar la equidad sobre la eficiencia pura». En los casos en que los objetivos entren en conflicto (por ejemplo, velocidad frente a coste), las reglas de compensación definidas por el ser humano deben dictar cuál tiene prioridad.

Momento de la ejecución

Aquí el enfoque se desplaza hacia la supervisión y la evaluación. Un ser humano no necesita conocer cada paso computacional, pero puede ver si la dirección general de la IA se alinea con el objetivo de nivel superior. Podemos evaluar el progreso en puntos predefinidos específicos.

- Probar si el resultado actual y los subobjetivos de la IA son coherentes con los objetivos declarados.

Por ejemplo, a una IA financiera se le podría permitir ejecutar múltiples simulaciones para optimizar una cartera (subobjetivos), pero un analista humano debe aprobar la estrategia final para garantizar que se alinee con la tolerancia al riesgo y los requisitos legales del cliente (objetivos de alto nivel). Este proceso permite a la IA utilizar su «agencia operativa» para explorar soluciones, mientras que el ser humano conserva la «agencia evaluativa» para garantizar que la dirección de la IA siga siendo legítima.

- Asegurarse de que el sistema esté diseñado para supervisar e informar continuamente sobre su progreso hacia sus subobjetivos.

Para una IA de generación de contenido, esto podría implicar que informe sobre sus intentos de encontrar palabras clave específicas o su estrategia para estructurar el artículo.

- El sistema debe crear un registro claro y rastreable de sus decisiones, incluido por qué persiguió un subobjetivo en particular. Este registro se pone a disposición de un evaluador humano.

Si una IA genera un resultado sesgado, un auditor puede rastrear su ruta y ver dónde comenzó a desviarse de las restricciones de equidad definidas en la etapa de diseño.

Adaptabilidad

Un ser humano no puede supervisar de manera factible cada cambio interno menor que realiza una IA. La supervisión humana debe dirigirse a cambios significativos, como cambios en la política o en el comportamiento general del sistema. Se trata de crear las barandillas para el comportamiento adaptativo de la IA.

Momento del diseño

- Configurar controles de cambio y monitores de deriva que detecten cambios de comportamiento significativos.

El sistema debe diseñarse para versionar sus propios modelos y configuraciones para que sea posible volver a una versión anterior y estable si algo sale mal.

Los monitores de deriva son herramientas que rastrean constantemente el rendimiento y el comportamiento de la IA en el mundo real. No solo miden la precisión; buscan la deriva de concepto (cuando cambia la relación entre los datos de entrada y salida) y la deriva de datos (cuando cambian los propios datos de entrada). Los monitores se configuran con umbrales específicos. Por ejemplo, el monitor de deriva de una IA de detección de fraudes podría configurarse para alertar a un ser humano si su tasa de falsos positivos aumenta en más del 5 %.

Momento de la ejecución

Una vez que el sistema está en funcionamiento, los humanos no lo vigilan constantemente. Son alertados por los monitores automatizados, lo que les permite centrar su atención de manera eficaz. Cuando se cruza el umbral de un monitor de deriva, envía automáticamente una alerta a un equipo humano. La alerta debe incluir una instantánea del comportamiento observado y los datos relevantes, para que el ser humano pueda evaluar rápidamente la situación. El sistema también puede preprogramarse para seguir un protocolo específico cuando se detecta un cambio.

¿Qué obtengo si implemento este marco?

Este enfoque crea una poderosa asociación en la que el sistema de IA y el ser humano «supervisor» tienen cada uno un papel distinto y valioso. La IA es libre de usar su poder computacional para abordar problemas complejos (su «agencia operativa»), mientras que el ser humano, utilizando señales claras del sistema, está facultado para tomar decisiones informadas de alto nivel e intervenir cuando sea necesario (su «agencia evaluativa»). El resultado es una colaboración de «suma no cero», en la que el esfuerzo combinado conduce a mejores resultados de los que el ser humano o la IA podrían lograr por sí solos.

¿Cómo aborda este marco el artículo 14 de la Ley de IA?

El marco aborda directamente los requisitos de la Ley de IA de la UE, en particular el artículo 14, al ofrecer un enfoque práctico y procesable para la «supervisión humana eficaz» que va más allá de los principios abstractos. Define la supervisión no como una obligación vaga, sino como un proceso sistemático de diseño de la IA para apoyar la agencia evaluativa humana.

¿Qué exige la Ley de IA a los desarrolladores de sistemas de IA?

- «Herramientas de interfaz hombre-máquina apropiadas… pueden ser supervisadas eficazmente».

El principio fundamental del marco es que el propio sistema de IA debe construirse para permitir la supervisión. El marco propuesto por el artículo ofrece características de diseño fundamentales que garantizan que el funcionamiento del sistema sea transparente y manejable para un ser humano.

- «Tener como objetivo prevenir o minimizar los riesgos».

El énfasis del marco en la agencia evaluativa aborda directamente esto. El papel del ser humano es proporcionar el «juicio de orden superior» que ancla las acciones de la IA a las normas profesionales y sociales. Este es el mecanismo para prevenir los riesgos que la IA, operando con su agencia operativa, podría no detectar. Las comprobaciones en tiempo de diseño del marco (por ejemplo, establecer objetivos de equidad, identificar decisiones de alto riesgo) garantizan que la prevención de riesgos sea una parte intencional de la arquitectura del sistema, no una ocurrencia tardía.

- «Medidas… integradas en el sistema de IA de alto riesgo».

Toda la estructura del marco se basa en este requisito. Los «artefactos de IA para exponer» y la «superficie de verificación del sistema» para cada condición son ejemplos de medidas que son «integradas… en el sistema de IA de alto riesgo por el proveedor».

La condición de individualidad requiere que el sistema se diseñe con contratos de API de transferencia claros. La condición de adaptabilidad requiere monitores de deriva y mecanismos de reversión integrados. Todas estas son medidas concretas implementadas por el proveedor.

El marco también guía al proveedor en la identificación de medidas para el implementador. Por ejemplo, la condición de fuente de acción requiere que el proveedor le dé al implementador un panel de procedencia, que es una medida clave para que el implementador la implemente y la use.

- «Supervisión humana… habilitada, según corresponda y sea proporcionada». El marco traduce directamente cada punto de este subartículo en un requisito de diseño.

a) «Comprender adecuadamente las capacidades y limitaciones pertinentes»

Las condiciones de individualidad y orientación a objetivos abordan esto al requerir una documentación explícita de los límites, objetivos y restricciones de la IA. Esto proporciona al ser humano una comprensión clara de las capacidades de la IA.

b) «Permanecer consciente de… el sesgo de automatización»

El marco promueve la agencia evaluativa como contrapeso al sesgo de automatización. El énfasis en comprobar los resultados de la IA en lugar de simplemente aceptarlos obliga al ser humano a permanecer comprometido y proporciona un mecanismo para anular la IA cuando sea necesario.

c) «Interpretar correctamente el… resultado»

La condición de fuente de acción garantiza que el resultado de la IA vaya acompañado de metadatos y registros de procedencia interpretables. Esto permite al ser humano interpretar correctamente el contexto y la cadena causal del resultado, lo que hace posible una simple decisión.

d) «Decidir… no usar… o ignorar… el resultado»

La condición de individualidad apoya directamente esto al requerir puntos de transferencia explícitos y mecanismos de «negarse a responder y transferir a un ser humano», lo que faculta al ser humano para intervenir y anular el sistema.

e) «Intervenir… o interrumpir… a través de un botón de ‘parada’»

Los mecanismos de reversión y abstención de la condición de adaptabilidad proporcionan el equivalente funcional de un botón de «parada». Permiten a un ser humano detener o revertir el funcionamiento de la IA de manera segura y controlada.

f) «Verificación por al menos dos personas físicas».

El marco proporciona las herramientas para que este sea un proceso factible y significativo. El registro de procedencia de la condición de fuente de acción y un registro claro de todas las interacciones humanas facilitan que dos o más personas verifiquen de forma independiente la identificación de una IA. Ambos pueden consultar el mismo conjunto de datos registrados y revisar la cadena causal para llegar a un consenso, lo que garantiza que la verificación se base en pruebas objetivas en lugar de conjeturas subjetivas.

Desafíos

Por supuesto, si bien el marco parece muy prometedor y aplicable, el artículo no ignora los inconvenientes comunes de implementar los mecanismos de supervisión.

Complejidad y coste

En primer lugar, no todos son sencillos de configurar; muchos requieren un esfuerzo inicial significativo para diseñarlos y construirlos. Se necesita experiencia especializada para crear sistemas que puedan generar justificaciones estructuradas, capturar la procedencia o codificar reglas matizadas en un libro de contabilidad de objetivos. Además, prepárese para los costes continuos de mantenimiento del sistema, calibración de señales y formación de los revisores humanos en los nuevos procesos.

Dependencia de la señal

La eficacia de estos mecanismos de supervisión depende en gran medida de la calidad de las señales que producen. Si la IA genera señales deficientes o ruidosas (por ejemplo, puntuaciones de confianza inexactas, justificaciones vagas o datos de procedencia defectuosos), puede inducir a error al revisor humano y socavar todo el proceso de supervisión.

Carga de verificación

Si bien el objetivo es mejorar la eficiencia, estos sistemas no eliminan por completo la carga de trabajo humana. En casos límite, novedosos o ambiguos, el revisor humano aún puede necesitar realizar comprobaciones puntuales manuales e intensivas. El artículo señala que esto puede reducir las ganancias de eficiencia, ya que los revisores pueden necesitar dedicar mucho tiempo a resolver las abstenciones o a impugnar las sugerencias de la IA. La carga humana pasa de una evaluación a gran escala a una verificación detallada del trabajo de la IA, que aún puede ser significativa.

Recuerde: se necesita un cambio de mentalidad

Por lo tanto, no basta con decir que necesitamos «supervisión humana». Para que sea una realidad, debemos cambiar nuestra mentalidad de simplemente «supervisar la IA» a diseñar la IA para la colaboración hombre-IA: redefinir el papel del ser humano como un evaluador activo, incorporar la supervisión en el diseño de la IA, recordar las tres C (control, contestabilidad y competencia), y entonces no solo cumplirá con regulaciones como la Ley de IA, sino que creará un sistema más fiable y potente que funcione con las personas.