الإشراف البشري على الذكاء الاصطناعي

الإشراف البشري في أنظمة الذكاء الاصطناعي هو مطلب امتثال:

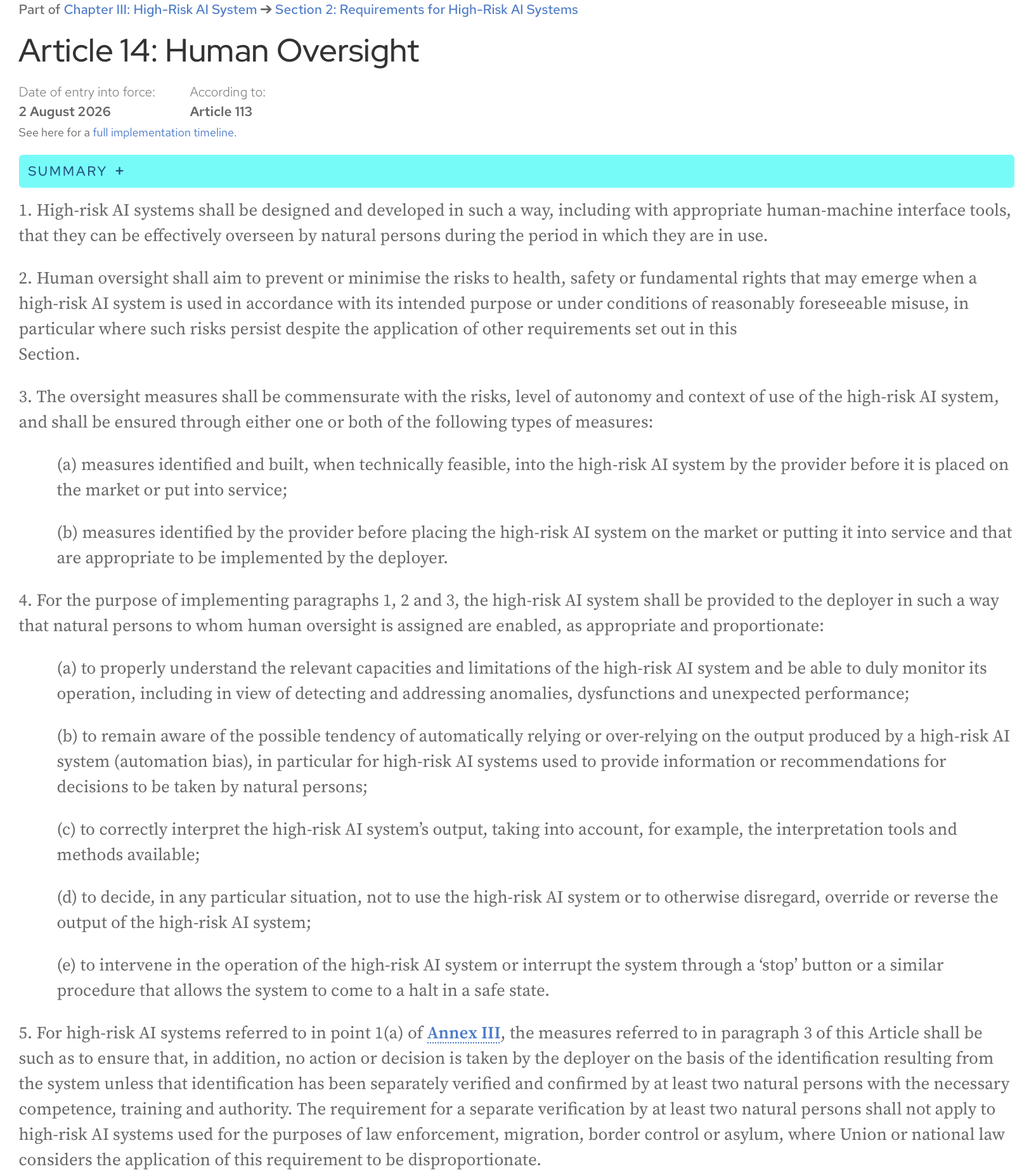

قانون الذكاء الاصطناعي، المادة 14: يجب تصميم وتطوير أنظمة الذكاء الاصطناعي عالية المخاطر بطريقة، بما في ذلك مع أدوات واجهة الإنسان والآلة المناسبة، بحيث يمكن للأشخاص الطبيعيين الإشراف عليها بفعالية خلال فترة استخدامها.

إليكم النص الكامل للمادة من صفحة الويب الرسمية لقانون الذكاء الاصطناعي:

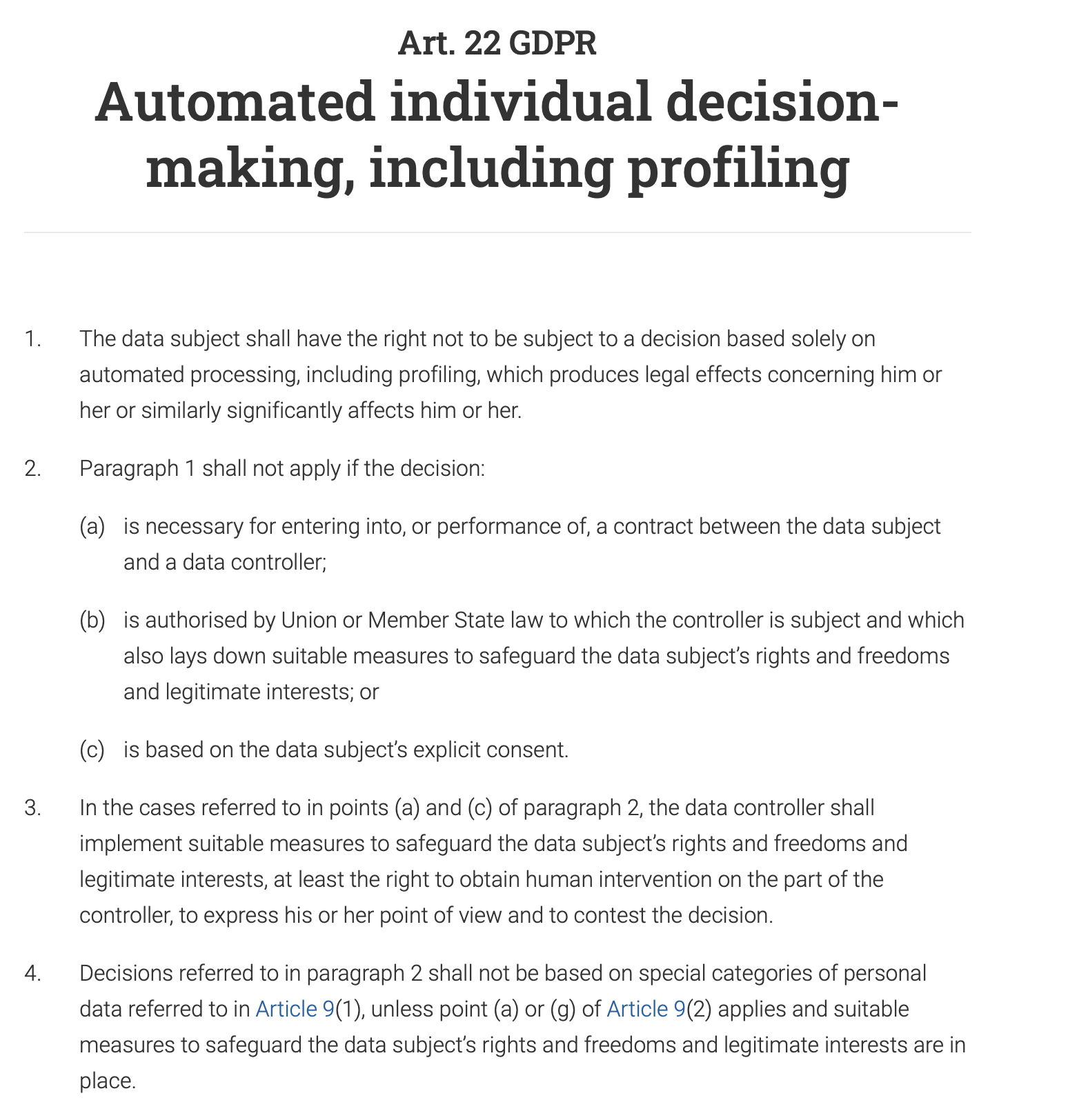

المادة 22 من اللائحة العامة لحماية البيانات (GDPR) تمنح الأفراد صراحة الحق في “عدم الخضوع لقرار يعتمد فقط على المعالجة الآلية، بما في ذلك التنميط، والذي ينتج عنه آثار قانونية تتعلق به أو يؤثر عليه بشكل كبير.” هذا يعني أنه بالنسبة لأي نظام لاتخاذ القرارات الآلية له تأثير كبير على فرد (على سبيل المثال، رفض طلب قرض، أو عرض عمل، أو منفعة عامة)، يجب أن يشارك إنسان في العملية لمراجعة القرار والتحقق من صحته. كما يحق للفرد الاعتراض على القرار الآلي والحصول على تدخل بشري.

وليس من المستغرب أن يكون الإشراف البشري مطلبًا رئيسيًا في كل من ISO 42001 وإطار عمل إدارة مخاطر الذكاء الاصطناعي (AI RMF) من NIST. يؤكد كلا الإطارين، على الرغم من اختلافهما في نهجهما، على الحاجة إلى التدخل البشري لضمان الاستخدام المسؤول والأخلاقي لأنظمة الذكاء الاصطناعي.

هذا المنشور هو تفسيري للورقة التي تم تقديمها في الجلسة الأخيرة من الدردشة الشهرية حول تبني الذكاء الاصطناعي وضمانه في Data61 - “تصميم إشراف بشري هادف في الذكاء الاصطناعي” (https://www.researchgate.net/publication/395540553_Designing_Meaningful_Human_Oversight_in_AI).

(الاستشهاد الكامل للورقة: Zhu, Liming & Lu, Qinghua & Ding, Ming & Lee, Sunny & Wang, Chen & Data, & Csiro, & Australia,. (2025). Designing Meaningful Human Oversight in AI. 10.13140/RG.2.2.16624.11528)

تناقش الورقة المشكلة المتعلقة بالنهج الحالي للإشراف البشري وتقدم نصائح عملية لمطوري أنظمة الذكاء الاصطناعي.

ما هو الإشراف البشري وكيف يتم؟

المشكلة في الإشراف البشري هي أنه غير محدد بشكل جيد. ولكن، في رأيي، ما يجعل كل شيء أكثر تعقيدًا هو تحيزنا الطبيعي للأتمتة - وهو ميل إلى الثقة في مخرجات الآلة أكثر من حكمنا الخاص. كم مرة اتبعت نظام تحديد المواقع العالمي (GPS) بشكل أعمى إلى طريق غير موجود؟

نتيجة لذلك، إما أن نوافق على مخرجات النظام دون فهمها بشكل صحيح (“الختم المطاطي”).

على سبيل المثال، يمكن لنظام الذكاء الاصطناعي في أحد البنوك أن يضع علامة على معاملتك على أنها عالية المخاطر، ويقوم محلل بشري، مكلف بمراجعة الآلاف من هذه التنبيهات يوميًا، بالموافقة تلقائيًا على قرار الذكاء الاصطناعي وتجميد حسابك.

السيناريو المعاكس شائع أيضًا: نحن نقيد النظام لدرجة أننا بدلاً من منحه هدفًا عالي المستوى وبعض الحرية لاستكشاف المقايضات وإيجاد حلول وسط، نحاول برمجة كل إجراء يجب أن يتخذه مسبقًا وبالتالي نحوله إلى نظام أتمتة قائم على القواعد.

تريد شركة أن يتعامل روبوت محادثة يعمل بالذكاء الاصطناعي مع استفسارات العملاء. بدلاً من منحه هدفًا عالي المستوى مثل “حل مشكلة العميل بأدب وكفاءة”، تقوم ببرمجته بنص جامد يملي أنه إذا سأل العميل، “كيف يمكنني إرجاع منتج؟”، يجب على الروبوت الرد برابط إلى صفحة المرتجعات ثم يسأل، “هل أجاب هذا على سؤالك؟” لا يمكنه التعامل مع الأسئلة الدقيقة مثل، “لقد فقدت إيصالي، هل لا يزال بإمكاني إرجاع هذا؟” لأن القواعد لا تغطي هذا السيناريو المحدد. يفقد روبوت المحادثة جودته كعامل ويصبح شجرة قرارات أساسية ومحبطة.

تجادل الورقة بأن أيًا من هذين السيناريوهين ليس هو الأمثل، وأن الوكالة البشرية ووكالة الذكاء الاصطناعي ليستا لعبة محصلتها صفر. ينتج عن تعاون الاثنين نتائج أفضل مما يمكن لأي منهما تحقيقه بمفرده.

كيف يمكن تصميم الإشراف البشري لتمكين هذا التعاون؟

نوعان من الوكالة

لنبدأ من تعريف الوكالة: إنها القدرة على اتخاذ إجراء وتحقيق الأشياء بنفسك، لتحقيق هدف.

تقترح الورقة التمييز بين نوعين من الوكالة:

- الوكالة التشغيلية (قدرة الذكاء الاصطناعي على توليد الحلول)

على سبيل المثال، يقوم نظام ذكاء اصطناعي طبي بتوليد تشخيص.

- الوكالة التقييمية (قدرة الإنسان على فهم وحكم والتحقق من حل الذكاء الاصطناعي وحيثما كان ذلك ضروريًا، توجيه نتائجه أو استبدالها بحلول بديلة)

لا يكرر الطبيب عملية التشخيص. ليس من وظيفة الطبيب إعادة عمل الذكاء الاصطناعي أو التفوق على الآلة. بدلاً من ذلك، يتمثل دورهم في تقييم تشخيص الذكاء الاصطناعي. يسأل الطبيب، “هل هذا منطقي؟ هل تفكير الذكاء الاصطناعي متسق مع ما سيفعله خبير بشري مسؤول؟” يتحققون من الاتساق. يراجعون منطق الذكاء الاصطناعي، والذي قد يكون قائمة بالأعراض الرئيسية واستشهادًا بالأدبيات الطبية. يتحقق الطبيب من أن هذا المنطق يتماشى مع تدريبهم ومعاييرهم الطبية. يضيفون أيضًا السياق البشري: مع العلم أن علاج مرض نادر هو علاج مكلف ومؤلم ومكثف لمدة عام، فإنهم يأخذون في الاعتبار تفضيلات المريض ووضعه المالي وما إذا كانوا على استعداد للالتزام بمثل هذا النظام الصعب. أخيرًا، يزنون الفوائد المحتملة للعلاج مقابل عبئه الكبير ويقررون ما إذا كان هو المسار الأكثر ملاءمة وأخلاقية للعمل، حتى لو كان تشخيص الذكاء الاصطناعي صحيحًا من الناحية الفنية.

من الصعب الاختلاف مع رأي المؤلفين بأن “التقييم” كلمة أفضل من “الإشراف” لأنها تؤكد على الدور البشري كدور نشط وحكمي، بدلاً من مجرد دور إشرافي أو رمزي.

الوكالة التقييمية توفر المساءلة

إذا حدث خطأ ما، فإن الإنسان هو المسؤول في النهاية. لا يمكن مساءلة الذكاء الاصطناعي في المحكمة؛ يمكن مساءلة الشخص الذي قام بتقييم مخرجاته. إلى جانب ذلك، يرسخ حكم الإنسان تصرفات الذكاء الاصطناعي بالمعايير المهنية والأخلاقية والمجتمعية التي لا يستطيع الذكاء الاصطناعي نفسه فهمها. يمكن للذكاء الاصطناعي أن يجد أسرع طريق، ولكن الإنسان فقط هو الذي يمكنه أن يقرر ما إذا كان هذا الطريق هو الأكثر أخلاقية أو أمانًا. هاتان الفائدتان أساسيتان للذكاء الاصطناعي المسؤول والجدير بالثقة.

الإخلاص في التفكير الداخلي مقابل الخارجي

كيف يمكننا تقييم مخرجات النظام إذا كنا لا نزال غير قادرين على فهم الأعمال الداخلية المعقدة لنماذج الذكاء الاصطناعي الحديثة بشكل كامل؟ كل تنشيط للشبكة العصبية، كل تعديل للمعلمات، أو كيف يتم توزيع وتخزين المعرفة المكتسبة للنموذج (مثل مفهوم “القطة”) داخل الملايين أو المليارات من المعلمات (ذاكرة النموذج) - محاولة فهم هذه الدوائر الخوارزمية غير ممكنة في هذه المرحلة من تطوير الذكاء الاصطناعي، وحتى لو كانت كذلك، فسيكون الأمر أشبه بالنظر إلى القرارات التي يتخذها برنامج كمبيوتر الشطرنج من خلال منظور الحسابات الفردية التي يقوم بها - تفاصيل كثيرة جدًا، معقدة جدًا، وليست مفيدة جدًا لتقييم القرارات بالفعل.

بدلاً من ذلك، يمكننا تصميم الأنظمة بطريقة توفر تفسيرات منطقية للإنسان - تفسيرات تستند إلى ما تشير إليه الورقة باسم “إخلاص التفكير الخارجي” أو “المعقولية”. سيقول برنامج الشطرنج، “لقد اخترت هذه الخطوة للسيطرة على مركز اللوحة والضغط على فارس الخصم”، وسنكون قادرين على تقييم هذا القرار لأن تفسيره يتماشى مع مبادئ الشطرنج الراسخة والحكم البشري.

الآن، كيف نصمم نظامًا لتقديم مثل هذه الأدلة التي يمكننا تقييمها، وإذا لزم الأمر، الاعتراض عليها؟

عدم التماثل بين الحل والتحقق

تقدم الورقة مفهومًا مفيدًا لـ عدم التماثل بين الحل والتحقق: غالبًا ما لا تكون صعوبة إنشاء حل (الحل) وصعوبة التحقق من هذا الحل (التحقق) متساويتين. هذا هو الحال في وقت التصميم وفي وقت التشغيل، وفهم ذلك يساعد في إنشاء عملية إشراف بشري فعالة.

في مرحلة التصميم، تتمثل مهمة “الحل” في الجهد المطلوب لبناء نظام الذكاء الاصطناعي:

- إنشاء بنية النظام

- تحديد الأهداف

- تنفيذ النظام

- تصميم مهام التحقق والعتبات لتطبيقها عبر العديد من الحالات المستقبلية

مهمة “التحقق” هي الجهد المبذول لتقييم هذا النظام والتحقق من صحته قبل نشره:

- مراجعة المتطلبات

- تقييم البنية والتصميم

- الاختبار

- أشكال أخرى من التحقق والتحقق من الصحة

في وقت التشغيل، ننظر إلى الحالات الفردية - مخرجات محددة للنظام، حلول محددة يقترحها. مهمة “التحقق” هنا هي تقييم هذه المخرجات الفردية. في بعض الأحيان تكون مهام “الحل” باهظة التكلفة من الناحية الحسابية ولكن التحقق من المخرجات سهل؛ ومع ذلك، هناك حالات يولد فيها الذكاء الاصطناعي مخرجات بسرعة ولكن الإنسان الذي يشرف على النظام سيقضي الكثير من الوقت والجهد في التحقق منها (على سبيل المثال، التحقق من الحقائق، والمراجعة بحثًا عن التحيز، وضمان توافق المحتوى مع المعايير وما إلى ذلك)، ويصبح التحقق عنق الزجاجة.

الخلاصة الأساسية هي أن الإشراف الفعال يجب أن يتكيف مع عدم التماثل هذا.

عندما يكون التحقق في وقت التصميم سهلاً

تتعلق هذه الاستراتيجية ببناء السلامة منذ البداية. من خلال تحميل عملية التحقق مسبقًا، يمكنك اكتشاف المشكلات المحتملة حتى قبل استخدام الذكاء الاصطناعي، مما يقلل من الحاجة إلى المراقبة اليدوية المستمرة.

على سبيل المثال، يجب أن يعمل ذراع روبوت المصنع بدرجة عالية من الدقة والأمان، مع البقاء دائمًا داخل منطقة عمله المخصصة. يتم التحقق من أنه لن يضر بعامل بشري قريب خلال مرحلة التصميم والبرمجة من خلال الاختبارات المكثفة والنمذجة ومعلمات السلامة المبرمجة مسبقًا. الهدف هو ضمان أن النظام “آمن حسب التصميم”، مما يجعل التدخل البشري في الوقت الفعلي في حركاته الأساسية غير ضروري.

عندما يكون التحقق في وقت التصميم صعبًا

تقر هذه الورقة بأن بعض مهام الذكاء الاصطناعي معقدة للغاية بحيث لا يمكن التحقق منها بالكامل أثناء التطوير. في هذه الحالات، يمكن تصميم النظام لتوفير معلومات واضحة وقابلة للتنفيذ لمشغل بشري، يمكنه بعد ذلك اتخاذ قرار نهائي مستنير. يعمل الإنسان كنقطة تفتيش نهائية.

على سبيل المثال، يقوم نظام ذكاء اصطناعي يوصي بتشخيص بمهمة معقدة للغاية. قد يكون من الصعب التحقق من دقته بالكامل أثناء التطوير بسبب الاختلافات اللانهائية في علم التشريح البشري والأمراض. لذلك، يجب تصميم النظام لتسهيل التحقق في وقت التشغيل: لن يعطي تشخيصًا فحسب، بل سيوفر أيضًا درجة ثقة (على سبيل المثال، “احتمال 95٪ لوجود ورم حميد”)، ويسلط الضوء على المناطق المحددة في الفحص التي أدت إلى استنتاجه، ويضيف استشهادات أخرى ذات صلة، ويقدم شرحًا تفصيليًا لمنطقه (آثار المنطق). يمكن للطبيب بعد ذلك استخدام هذه المعلومات لإجراء التشخيص النهائي المستنير.

ماذا عن المجالات الذاتية حيث لا توجد إجابة صحيحة؟

في مجالات مثل الفن أو الأخلاق أو التخطيط الاستراتيجي، لدى الأشخاص المختلفين قيم ووجهات نظر مختلفة. هنا، بدلاً من وجود نظام ذكاء اصطناعي “يطوي” كل التنوع في إجابة واحدة “صحيحة” حيث لا يوجد غالبًا، يجب أن نصمم الذكاء الاصطناعي ليكون شريكًا في مناقشة. الهدف ليس الحصول على حل مثالي، ولكن إظهار وجهات نظر وسيناريوهات مختلفة. هذا النهج يجعل الخلاف جزءًا قيمًا من العملية، حيث يمكن للذكاء الاصطناعي أن يوضح لك المقايضات ووجهات النظر المختلفة. من خلال القيام بذلك، يصبح النظام أكثر مساءلة، لأنه يجبرك، أيها الإنسان، على التفكير بنشاط في هذه الخيارات واتخاذ قرار مدروس ومسبب جيدًا بناءً على جميع الزوايا المتاحة.

حدود التفويض

يؤكد مؤلفو الورقة على وجود خط لا ينبغي بعده أن يكون الذكاء الاصطناعي هو صانع القرار الأساسي - يسمونه “حدود التفويض”. في بعض المجالات عالية المخاطر مثل إصدار الأحكام القانونية أو التشخيص الطبي أو التوظيف، يحمل الحكم النهائي وزنًا أخلاقيًا ومعياريًا كبيرًا. يجب عدم تفويض هذه القرارات بالكامل إلى الذكاء الاصطناعي. في هذه الحالات، لا يقتصر الإشراف على التحقق مما إذا كانت مخرجات الذكاء الاصطناعي صحيحة. إنه يتعلق بـ حماية المسؤولية البشرية. يجب أن يعمل الذكاء الاصطناعي كأداة لدعم صانع القرار البشري، وتوفير البيانات والرؤى، ولكن لا يحل محله بالكامل أبدًا. يجب أن يظل القرار النهائي مع إنسان لضمان المساءلة الأخلاقية والمعنوية.

3 C للإشراف البشري الفعال

ما الذي نحتاج إلى تحقيقه عند تصميم عملية الإشراف على الذكاء الاصطناعي؟

- التحكم (يمكننا نحن البشر إجراء تدخلات فعالة وفي الوقت المناسب لإيقاف أو إعادة توجيه أو استبدال قرار الذكاء الاصطناعي)

- القابلية للطعن (قرارات الذكاء الاصطناعي مدعومة بأسباب وأدلة مفهومة، بحيث يمكن مراجعتها والطعن فيها)

- الكفاءة (يحسن الإشراف الأداء العام للنظام وعدالته، وتجنب التجاوزات الفظة التي من شأنها أن تقلل من المخرجات الصحيحة للذكاء الاصطناعي)

شروط الوكالة والإشراف

تشير الورقة إلى شروط الوكالة (الفردية، مصدر العمل، التوجه نحو الهدف، والقدرة على التكيف) كإطار لتصميم إشراف بشري فعال في كل من وقت التصميم و وقت التشغيل. يمكنك قراءة المزيد عن هذه الشروط في ورقة أخرى - الوكالة تعتمد على الإطار

دعونا نلقي نظرة على كل من هذه الشروط - ونصائح تصميم الإشراف البشري العملية المتعلقة بكل منها والتي تقدمها الورقة لمطوري الأنظمة.

الفردية

يتطلب هذا الشرط حدودًا واضحة بين دور الذكاء الاصطناعي (الوكالة التشغيلية) ودور الإنسان (الوكالة التقييمية). نحتاج هنا إلى إنشاء مخطط للتفاعل بين الإنسان والذكاء الاصطناعي حيث يجب أن يكون الذكاء الاصطناعي حرًا في العمل بشكل مستقل، ويجب على الإنسان التدخل فقط عند نقاط تفتيش محددة ومحددة جيدًا. يؤدي عدم وضوح هذه الخطوط إلى نشر المساءلة.

وقت التصميم

- تحديد حدود النظام وتعيين نقاط تسليم صريحة للتدخل البشري.

أين تنتهي وظيفة الذكاء الاصطناعي؟ ليس فقط “سيتعامل النظام مع خدمة العملاء” ولكن “سيجيب النظام على أسئلة العملاء المتعلقة بمواصفات المنتج من قاعدة معرفية محددة مسبقًا. لن يتعامل مع نزاعات الفواتير أو المبالغ المستردة.”

- إضافة شروط الامتناع (رفض الإجابة على استعلام) عندما يتعين على النظام الإبلاغ عن حالة للتدخل البشري بدلاً من التخمين

على سبيل المثال، عندما تكون درجة الثقة < 90٪، سيشير النظام إلى الإنسان بأنه يعمل في “منطقة رمادية”.

- تحديد نقاط تسليم بشرية محددة مسبقًا - حيث ينتقل التحكم من الذكاء الاصطناعي إلى الإنسان.

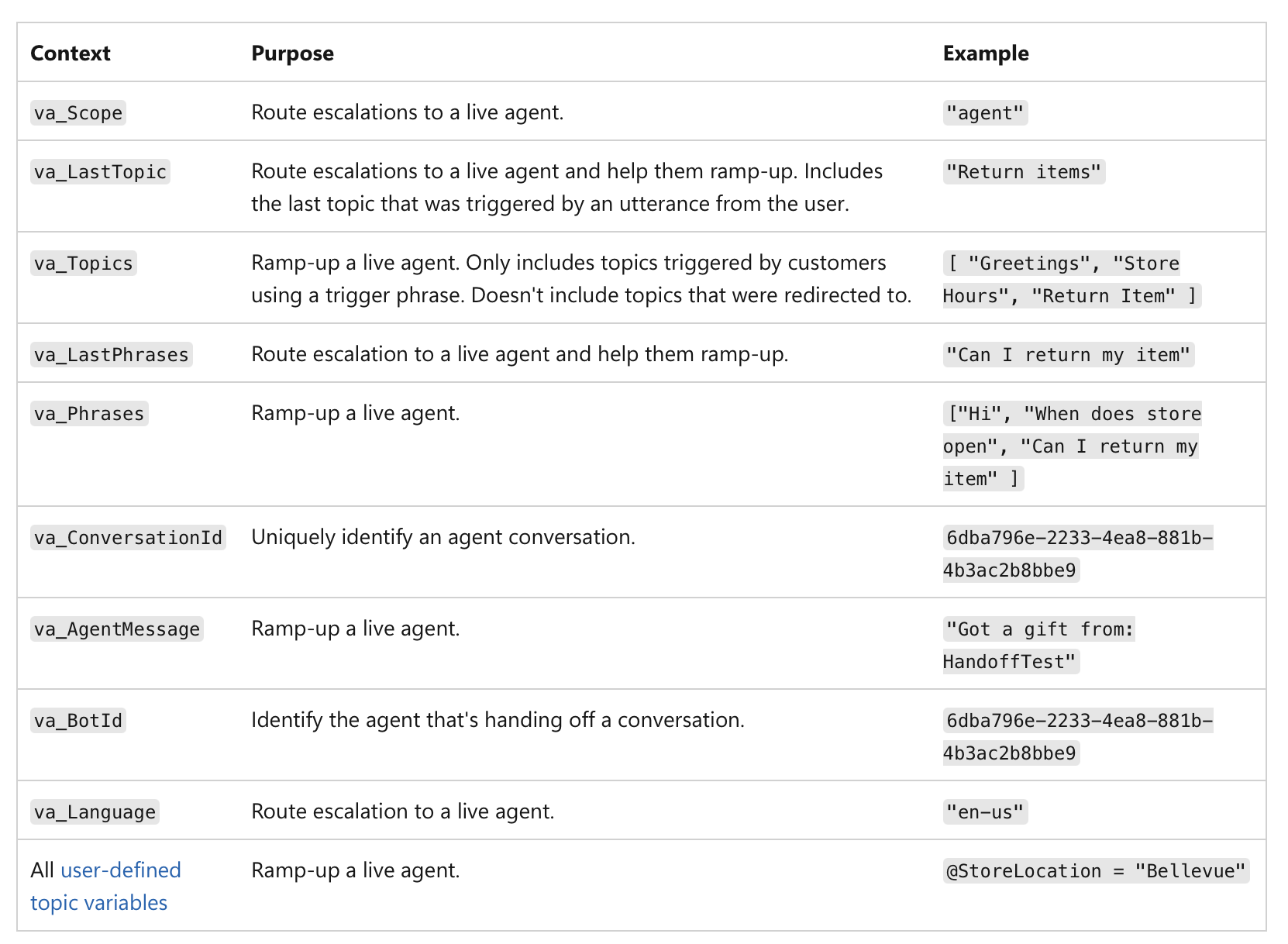

لا يتعلق الأمر فقط بدرجة ثقة منخفضة، ولكن بـ أهمية الإجراء نفسه. على سبيل المثال، حتى لو كان الذكاء الاصطناعي واثقًا بنسبة 99٪، إذا كان القرار يتضمن معاملة مالية تزيد عن مليون دولار أو تشخيصًا طبيًا حاسمًا، فإن الطبيعة عالية المخاطر للمهمة تجعلها نقطة تفتيش بشرية إلزامية. إليكم مثال على كيفية تنفيذ التسليم البشري في وكلاء MS Copilot:

(المصدر)

(المصدر)

وقت التشغيل

بمجرد أن يصبح النظام مباشرًا، يتحول التركيز إلى التسجيل والمساءلة.

- سجل متى ينتقل التحكم بالفعل من الذكاء الاصطناعي إلى الإنسان.

يجب أن يقوم نظامك بإنشاء سجل غير قابل للتغيير (على سبيل المثال على blockchain أو قاعدة بيانات للكتابة مرة واحدة - لمنع العبث) لكل عملية تسليم: يجب أن يتضمن السجل طابعًا زمنيًا، والإجراء النهائي للذكاء الاصطناعي، وهوية الإنسان الذي تولى السيطرة:

“تم تسليم طلب القرض رقم 12345 إلى المحلل البشري ماري سميث في الساعة 10:30 صباحًا بسبب درجة ائتمان أقل من الحد الأدنى.”

وهذا يضمن مساءلة واضحة عن القرار النهائي.

يمكن استخدام البيانات المسجلة لإنشاء لوحات معلومات وتقارير للإشراف - يمكنك معرفة عدد مرات حدوث التدخل البشري، وما إذا كانت توصيات الذكاء الاصطناعي يتم قبولها أو رفضها، ومن يتخذ القرارات النهائية. يساعدنا هذا في تحديد المجالات التي قد يكون فيها أداء الذكاء الاصطناعي ضعيفًا أو حيث تحتاج العمليات البشرية إلى تحسين.

مصدر العمل

هنا نتتبع سبب الإخراج. غالبًا ما تكون عملية التوليد في الذكاء الاصطناعي غير شفافة، لذا فإن محاولة “المشاركة في ملكيتها” من خلال صياغة المطالبات بدقة قد تكون مجرد وهم بالسيطرة. بدلاً من ذلك، يجب أن يركز الإشراف البشري على تقييم المخرجات النهائية من خلال مراجعة التاريخ السببي (المطالبات، المدخلات، استدعاءات الذكاء الاصطناعي) (المعروف أيضًا باسم المصدر).

وقت التصميم

-

تأكد من أن النظام يمكنه التقاط سجل كامل لمصدره من خلال التسجيل الشامل (غير قابل للتغيير وموحد للقراءة الآلية)، حيث يتم تسجيل كل خطوة في سير عمل الذكاء الاصطناعي تلقائيًا وختمها زمنيًا:

- بيانات الإدخال والمطالبة المستخدمة

- الإصدار المحدد من نموذج الذكاء الاصطناعي المستخدم لإنشاء المخرجات

- التاريخ الكامل للتعليمات والتعديلات البشرية

- أي استدعاءات خارجية، خدمات خارجية، واجهات برمجة تطبيقات، قواعد بيانات وصل إليها نظام الذكاء الاصطناعي

- المخرجات الوسيطة التي أنشأها النظام ولكنه انتهى به الأمر إلى التخلص منها

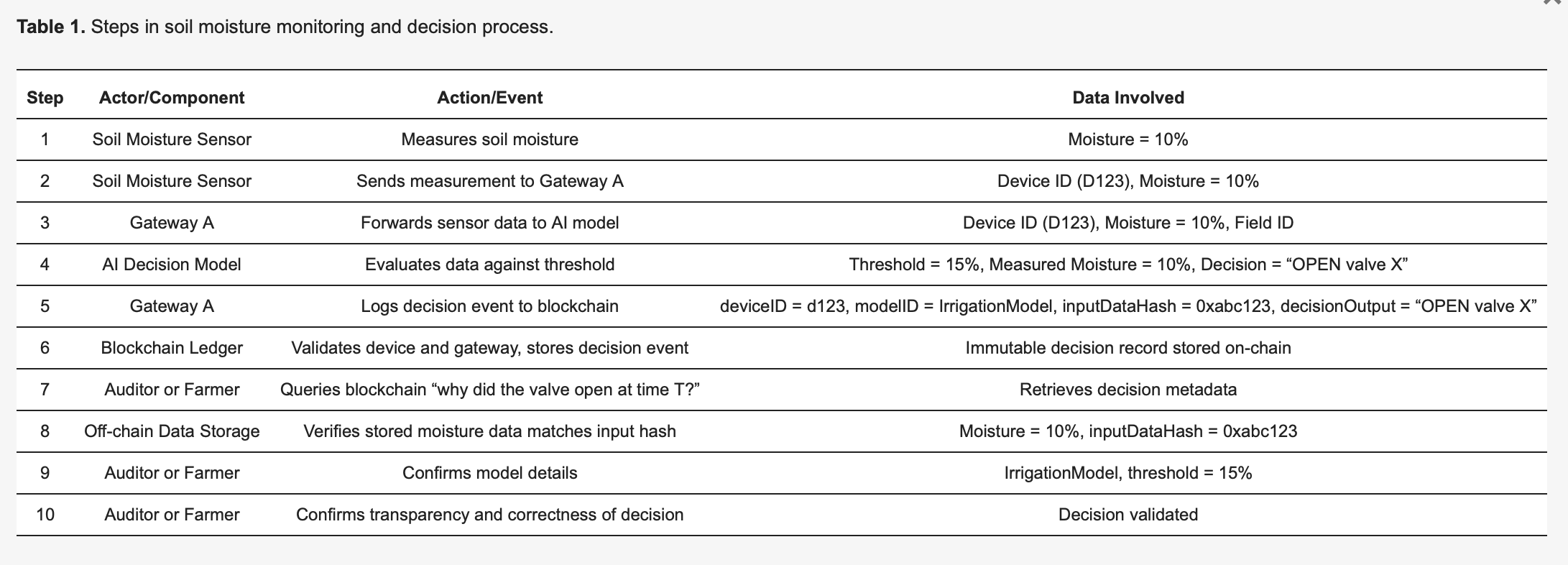

يناقش هذا الإصدار المسبق من “استخدام سجلات Blockchain لتسجيل قرارات الذكاء الاصطناعي في إنترنت الأشياء”، على سبيل المثال، كيفية القيام بذلك عمليًا: https://www.preprints.org/manuscript/202504.1789/v1 إليكم مثال واحد من هذا الإصدار المسبق:

لجعل المنهجية ملموسة، ضع في اعتبارك نظام ري ذكي قائم على إنترنت الأشياء [27]، مفصل في الجدول 1. ترسل مستشعرات رطوبة التربة (الأجهزة) قراءات إلى نموذج ذكاء اصطناعي طرفي يقرر ما إذا كان يجب فتح صمامات المياه أو إغلاقها. يؤدي كل قرار يتخذه الذكاء الاصطناعي إلى تشغيل حدث تسجيل يتم التقاطه بشكل غير قابل للتغيير على سجل blockchain، مما يعزز الشفافية وقابلية التدقيق. كما هو موضح في الجدول 1، يكتشف المستشعر 123 رطوبة بنسبة 10 بالمائة ويرسل هذا القياس إلى البوابة A. تقوم البوابة A بإعادة توجيه البيانات إلى نموذج الذكاء الاصطناعي، والذي، بسبب عتبة محددة مسبقًا بنسبة 15 بالمائة (محددة بواسطة IrrigationModelv2)، يحدد الإجراء المناسب: “valve = OPEN” للحقل X. ثم تقوم البوابة A بإعداد معاملة تحتوي على بيانات وصفية مهمة - بما في ذلك deviceID (123)، و modelID (IrrigationModelv2)، وتجزئة لبيانات الإدخال (0xabc123)، ونتيجة القرار (OPEN valve X) - وتوقعها، وتقدمها إلى blockchain. تتحقق عقد blockchain من أصالة وأذونات المستشعر 123 والبوابة A، وتؤكد أنها مسجلة بشكل صحيح في الحقل X، وتخزن السجل بشكل دائم لاحقًا. يتم إصدار حدث للإشارة إلى التسجيل الناجح. لاحقًا، يمكن للمدقق أو المزارع الاستعلام عن “لماذا تم إطلاق المياه في الوقت T؟”، واسترداد سجل المعاملات المفصل من blockchain. يمكن بعد ذلك مقارنة التجزئة (0xabc123) من blockchain مع بيانات المستشعر المخزنة خارج السلسلة (المخزنة على IPFS أو قاعدة بيانات البوابة A) لتأكيد أن قراءة الرطوبة كانت بالفعل 10 بالمائة. بالإضافة إلى ذلك، بالرجوع إلى سجل النموذج، يمكن للمزارع التحقق من أن عتبة الري تم ضبطها على 15 بالمائة من الرطوبة، مما يؤكد أن قرار الذكاء الاصطناعي كان صحيحًا ومبررًا. تعزز هذه العملية المنظمة الشفافية بشكل كبير: كل إجراء آلي يمكن التحقق منه وشرحه بالكامل من خلال البيانات الوصفية المسجلة، وتضمن عدم قابلية تغيير blockchain أنه لا يمكن لمشغلي المزارع ولا مصنعي الأجهزة تعديل سجلات القرارات سراً.

وقت التشغيل

- فحص السلسلة السببية للحالة المحددة لمعرفة كيفية إنشاء المخرجات.

- استخدم لوحة معلومات مرئية ترسم السلسلة السببية بأكملها لمخرجات محددة لرؤية النتيجة النهائية وكل خطوة أدت إليها.

عندما تريد مراجعة قرار ما، يمكنك سحب سجل المصدر لتلك الحالة المحددة. لا تحتاج إلى فهم “المسار التوليدي” الداخلي للذكاء الاصطناعي (الرياضيات المعقدة والتنشيطات العصبية). بدلاً من ذلك، تتحقق من البيانات الوصفية للمصدر للإجابة على أسئلة مثل هذه:

“هل تم استخدام البيانات الصحيحة؟”

على سبيل المثال، عندما يسحب الطبيب سجل المصدر، تظهر البيانات الوصفية قائمة بنقاط البيانات المحددة التي استخدمها الذكاء الاصطناعي. يؤكد سجل المصدر أن الذكاء الاصطناعي استخدم التاريخ الطبي الكامل للمريض، واختبار دم حديث من 24/10/25، ومسح بالرنين المغناطيسي من 26/10/25، وجميع نقاط البيانات تتطابق مع السجل الصحي الإلكتروني الرسمي. في حالة مختلفة، قد يستنتج الطبيب أن سجل المصدر يظهر أن الذكاء الاصطناعي وصل إلى بيانات اختبار الدم من عامين مضيا، ولكن تم تحديث مخطط المريض بنتائج جديدة الأسبوع الماضي، واستخدم الذكاء الاصطناعي معلومات قديمة.

“هل تمت معالجة مطالبة الإنسان بدقة؟”

كانت مطالبة الطبيب للذكاء الاصطناعي “تحليل الأعراض والتوصية بتشخيص لرجل يبلغ من العمر 45 عامًا يعاني من سعال مستمر وحمى”. يسجل سجل المصدر الاستعلام الدقيق الذي تلقاه الذكاء الاصطناعي. يقارن الطبيب هذا بإدخاله الأصلي ويلاحظ أن الاستعلام المسجل يظهر أن المطالبة تم اقتطاعها، مع فقدان عرض “الحمى” - لذلك قام الذكاء الاصطناعي بمعالجة “السعال المستمر” فقط مما أدى إلى مسار تشخيصي مختلف.

“هل تم نشر إصدار النموذج الصحيح؟”

قد يظهر سجل المصدر أن التشخيص تم إنشاؤه بواسطة إصدار أقدم من النموذج كان يجب إيقافه بسبب خطأ في النظام.

هنا، ينسب النظام بوضوح الإجراءات إما إلى الجيل المستقل للذكاء الاصطناعي أو إلى تدخل بشري محدد. هذا يسمح بمساءلة واضحة. إذا تم اتخاذ قرار سيئ، يمكن لفحص سريع لسجل المصدر أن يكشف ما إذا كان ناتجًا عن مخرجات ذكاء اصطناعي معيبة أو خطأ تقييم بشري، مما يمنع “لعبة إلقاء اللوم” حيث يتم نشر الوكالة.

التوجه نحو الهدف

يجب أن يتعامل الذكاء الاصطناعي مع الأهداف الفرعية منخفضة المستوى، بينما يحتفظ البشر بالسلطة على الأهداف عالية المستوى. يتمثل دور الإنسان في ضمان توافق المسار الذي اختاره الذكاء الاصطناعي مع الأهداف والقيود الأوسع مثل المتطلبات القانونية أو أهداف الإنصاف.

وقت التصميم

- نشر الأهداف عالية المستوى والقيود وقواعد المقايضة للذكاء الاصطناعي بشكل صريح.

يتم توضيح الأهداف عالية المستوى التي يحددها الإنسان وإتاحتها. هذه ليست مجرد بيانات مهمة غامضة؛ إنها أهداف ملموسة، غالبًا ما تكون رقمية. بالنسبة للذكاء الاصطناعي اللوجستي، قد يكون هذا “تقليل وقت التسليم بنسبة 15٪ دون زيادة تكاليف الوقود”. بالنسبة للذكاء الاصطناعي للتوظيف، قد يكون الهدف عالي المستوى “زيادة الطلبات المؤهلة بنسبة 20٪ مع ضمان عدم وجود تحيز عنصري أو جنساني في مصادر المرشحين”.

- تحديد القيود وقواعد المقايضة.

يتم التعبير عن السلطة البشرية من خلال الحدود والقواعد. يجب إعطاء الذكاء الاصطناعي حدودًا صريحة لا يمكنه انتهاكها. على سبيل المثال، “البقاء ضمن الميزانية القانونية”، “عدم التوصية بأي إجراء ينتهك قوانين الخصوصية”، أو “إعطاء الأولوية للإنصاف على الكفاءة البحتة”. في الحالات التي تتعارض فيها الأهداف (على سبيل المثال، السرعة مقابل التكلفة)، يجب أن تملي قواعد المقايضة التي يحددها الإنسان أي منها له الأولوية.

وقت التشغيل

هنا يتحول التركيز إلى المراقبة والتقييم. لا يحتاج الإنسان إلى معرفة كل خطوة حسابية، لكن يمكنه معرفة ما إذا كان الاتجاه العام للذكاء الاصطناعي يتماشى مع الهدف عالي المستوى. يمكننا تقييم التقدم في نقاط محددة مسبقًا.

- اختبار ما إذا كانت المخرجات الحالية للذكاء الاصطناعي وأهدافه الفرعية متوافقة مع تلك الأهداف المعلنة.

على سبيل المثال، قد يُسمح للذكاء الاصطناعي المالي بإجراء عمليات محاكاة متعددة لتحسين محفظة (أهداف فرعية)، ولكن يجب على محلل بشري الموافقة على الاستراتيجية النهائية لضمان توافقها مع تحمل العميل للمخاطر والمتطلبات القانونية (أهداف عالية المستوى). تسمح هذه العملية للذكاء الاصطناعي باستخدام “وكالته التشغيلية” لاستكشاف الحلول، بينما يحتفظ الإنسان بـ “وكالته التقييمية” لضمان بقاء اتجاه الذكاء الاصطناعي مشروعًا.

- التأكد من أن النظام مصمم لمراقبة تقدمه نحو أهدافه الفرعية والإبلاغ عنه باستمرار.

بالنسبة للذكاء الاصطناعي لتوليد المحتوى، قد يتضمن ذلك الإبلاغ عن محاولاته للعثور على كلمات رئيسية محددة أو استراتيجيته لهيكلة المقالة.

- يجب أن يقوم النظام بإنشاء سجل واضح وقابل للتتبع لقراراته، بما في ذلك سبب متابعته لهدف فرعي معين. يتم توفير هذا السجل لمقيم بشري.

إذا أنتج الذكاء الاصطناعي نتيجة متحيزة، يمكن للمدقق تتبع مساره ومعرفة أين بدأ في الانحراف عن قيود الإنصاف المحددة في مرحلة التصميم.

القدرة على التكيف

لا يمكن للإنسان الإشراف بشكل عملي على كل تغيير داخلي بسيط يقوم به الذكاء الاصطناعي. يجب أن يستهدف الإشراف البشري التغييرات المهمة، مثل التحولات في السياسة أو سلوك النظام العام. يتعلق الأمر بإنشاء حواجز حماية لسلوك الذكاء الاصطناعي التكيفي.

وقت التصميم

- إعداد ضوابط التغيير ومراقبي الانحراف الذين يكتشفون التحولات السلوكية المهمة.

يجب تصميم النظام لإصدار نماذجه وتكويناته الخاصة لجعله من الممكن العودة إلى إصدار سابق ومستقر إذا حدث خطأ ما.

مراقبو الانحراف هم أدوات تتعقب باستمرار أداء وسلوك الذكاء الاصطناعي في العالم الحقيقي. إنهم لا يقيسون الدقة فقط؛ إنهم يبحثون عن انحراف المفهوم (عندما تتغير العلاقة بين بيانات الإدخال والإخراج) و انحراف البيانات (عندما تتغير بيانات الإدخال نفسها). يتم تعيين المراقبين بعتبات محددة. على سبيل المثال، قد يتم تعيين مراقب انحراف الذكاء الاصطناعي للكشف عن الاحتيال لتنبيه الإنسان إذا زاد معدل الإيجابيات الخاطئة بأكثر من 5٪.

وقت التشغيل

بمجرد أن يصبح النظام مباشرًا، لا يراقبه البشر باستمرار. يتم تنبيههم من قبل المراقبين الآليين، مما يسمح لهم بتركيز انتباههم بشكل فعال. عندما يتم تجاوز عتبة مراقب الانحراف، فإنه يرسل تلقائيًا تنبيهًا إلى فريق بشري. يجب أن يتضمن التنبيه لقطة من السلوك المرصود والبيانات ذات الصلة، حتى يتمكن الإنسان من تقييم الموقف بسرعة. يمكن أيضًا برمجة النظام مسبقًا لاتباع بروتوكول معين عند اكتشاف تغيير.

ماذا أحصل إذا قمت بتنفيذ هذا الإطار؟

يخلق هذا النهج شراكة قوية حيث يكون لكل من نظام الذكاء الاصطناعي والإنسان “المشرف” دور متميز وقيم. يتمتع الذكاء الاصطناعي بالحرية في استخدام قوته الحسابية لمعالجة المشكلات المعقدة (“وكالته التشغيلية”)، بينما يتم تمكين الإنسان، باستخدام إشارات واضحة من النظام، من اتخاذ قرارات مستنيرة وعالية المستوى والتدخل عند الحاجة (“وكالته التقييمية”). والنتيجة هي تعاون “ليس محصلته صفر”، حيث يؤدي الجهد المشترك إلى نتائج أفضل مما يمكن أن يحققه الإنسان أو الذكاء الاصطناعي بمفرده.

كيف يعالج هذا الإطار المادة 134 من قانون الذكاء الاصطناعي؟

يعالج الإطار مباشرة متطلبات قانون الذكاء الاصطناعي للاتحاد الأوروبي، ولا سيما المادة 134، من خلال تقديم نهج عملي وقابل للتنفيذ “للإشراف البشري الفعال” يتجاوز المبادئ المجردة. إنه لا يعرف الإشراف على أنه التزام غامض، ولكن كعملية منهجية لتصميم الذكاء الاصطناعي لدعم الوكالة التقييمية البشرية.

ماذا يطلب قانون الذكاء الاصطناعي من مطوري أنظمة الذكاء الاصطناعي؟

- “أدوات واجهة الإنسان والآلة المناسبة … يمكن الإشراف عليها بفعالية.”

المبدأ الأساسي للإطار هو أن نظام الذكاء الاصطناعي نفسه يجب أن يتم بناؤه لتمكين الإشراف. يقدم الإطار الذي اقترحته الورقة ميزات تصميم أساسية تضمن أن تشغيل النظام شفاف وقابل للإدارة من قبل الإنسان.

- “تهدف إلى منع أو تقليل المخاطر.”

يؤكد الإطار على الوكالة التقييمية لمعالجة هذا الأمر مباشرة. يتمثل دور الإنسان في توفير “الحكم عالي المستوى” الذي يرسخ تصرفات الذكاء الاصطناعي بالمعايير المهنية والمجتمعية. هذه هي آلية منع المخاطر التي قد لا يكتشفها الذكاء الاصطناعي، الذي يعمل بوكالته التشغيلية. تضمن فحوصات وقت التصميم في الإطار (على سبيل المثال، تحديد أهداف الإنصاف، وتحديد القرارات عالية المخاطر) أن منع المخاطر جزء مقصود من بنية النظام، وليس فكرة لاحقة.

- “تدابير … مدمجة في نظام الذكاء الاصطناعي عالي المخاطر.”

تم بناء هيكل الإطار بأكمله حول هذا المطلب. “التحف الفنية للذكاء الاصطناعي التي يجب كشفها” و “سطح التحقق من النظام” لكل شرط هي أمثلة على التدابير “المدمجة … في نظام الذكاء الاصطناعي عالي المخاطر من قبل المزود”.

يتطلب شرط الفردية تصميم النظام بعقود واجهة برمجة تطبيقات تسليم واضحة. يتطلب شرط القدرة على التكيف مراقبي انحراف مدمجين وآليات تراجع. هذه كلها تدابير ملموسة ينفذها المزود.

يوجه الإطار أيضًا المزود في تحديد تدابير للناشر. على سبيل المثال، يتطلب شرط مصدر العمل من المزود إعطاء الناشر لوحة معلومات للمصدر، وهو إجراء رئيسي للناشر لتنفيذه واستخدامه.

- “الإشراف البشري … ممكّن، حسب الاقتضاء والتناسب.” يترجم الإطار مباشرة كل نقطة من هذه المادة الفرعية إلى متطلب تصميم.

أ) “فهم القدرات والقيود ذات الصلة بشكل صحيح”

يعالج شرطا الفردية و التوجه نحو الهدف هذا من خلال طلب توثيق صريح لحدود الذكاء الاصطناعي وأهدافه وقيوده. يوفر هذا للإنسان فهمًا واضحًا لقدرات الذكاء الاصطناعي.

ب) “البقاء على دراية بـ … تحيز الأتمتة”

يعزز الإطار الوكالة التقييمية كثقل موازن لتحيز الأتمتة. يجبر التركيز على فحص مخرجات الذكاء الاصطناعي بدلاً من مجرد قبولها الإنسان على البقاء منخرطًا ويوفر آلية لتجاوز الذكاء الاصطناعي عند الضرورة.

ج) “تفسير … المخرجات بشكل صحيح”

يضمن شرط مصدر العمل أن تكون مخرجات الذكاء الاصطناعي مصحوبة ببيانات وصفية قابلة للتفسير وسجلات مصدر. يمكّن هذا الإنسان من تفسير سياق المخرجات وسلسلتها السببية بشكل صحيح، مما يجعل اتخاذ قرار حكم بسيط ممكنًا.

د) “القرار … بعدم استخدام … أو تجاهل … المخرجات”

يدعم شرط الفردية هذا مباشرة من خلال طلب نقاط تسليم صريحة وآليات “رفض الإجابة والتسليم إلى الإنسان”، مما يمكّن الإنسان من التدخل وتجاوز النظام.

هـ) “التدخل … أو المقاطعة … من خلال زر ‘إيقاف’”

توفر آليات التراجع والامتناع في شرط القدرة على التكيف المكافئ الوظيفي لزر “إيقاف”. إنها تمكن الإنسان من إيقاف أو عكس تشغيل الذكاء الاصطناعي بطريقة آمنة ومضبوطة.

و) “التحقق من قبل شخصين طبيعيين على الأقل.”

يوفر الإطار الأدوات لجعل هذه العملية ممكنة وذات مغزى. يجعل سجل المصدر في شرط مصدر العمل وسجل واضح لجميع التفاعلات البشرية من السهل على شخصين أو أكثر التحقق بشكل مستقل من تحديد الذكاء الاصطناعي. يمكن لكليهما سحب نفس مجموعة البيانات المسجلة ومراجعة السلسلة السببية للوصول إلى إجماع، مما يضمن أن التحقق يعتمد على أدلة موضوعية بدلاً من التخمين الذاتي.

التحديات

بالطبع، في حين أن الإطار يبدو واعدًا جدًا وقابلًا للتطبيق، فإن الورقة لا تتجاهل العيوب الشائعة لتنفيذ آليات الإشراف.

التعقيد والتكلفة

أولاً، ليس من السهل إعدادها جميعًا - فالكثير منها يتطلب جهدًا كبيرًا مقدمًا للتصميم والبناء. تحتاج إلى خبرة متخصصة لإنشاء أنظمة يمكنها توليد مبررات منظمة، أو التقاط المصدر، أو ترميز قواعد دقيقة في سجل الأهداف. إلى جانب ذلك، استعد للتكاليف المستمرة لصيانة النظام، ومعايرة الإشارات، وتدريب المراجعين البشريين على العمليات الجديدة.

الاعتماد على الإشارة

تعتمد فعالية آليات الإشراف هذه بشكل كبير على جودة الإشارات التي تنتجها. إذا أنتج الذكاء الاصطناعي إشارات ضعيفة أو مشوشة (على سبيل المثال، درجات ثقة غير دقيقة، أو مبررات غامضة، أو بيانات مصدر معيبة)، فيمكن أن يضلل المراجع البشري ويقوض عملية الإشراف بأكملها.

عبء التحقق

بينما الهدف هو تحسين الكفاءة، فإن هذه الأنظمة لا تقضي تمامًا على عبء العمل البشري. في الحالات الحدودية أو الجديدة أو الغامضة، قد لا يزال المراجع البشري بحاجة إلى إجراء فحوصات موضعية يدوية مكثفة. تشير الورقة إلى أن هذا يمكن أن يقلل من مكاسب الكفاءة، حيث قد يحتاج المراجعون إلى قضاء الكثير من الوقت في حل حالات الامتناع أو الطعن في اقتراحات الذكاء الاصطناعي. يتحول العبء البشري من تقييم واسع النطاق إلى تحقق مفصل من عمل الذكاء الاصطناعي، والذي لا يزال من الممكن أن يكون كبيرًا.

تذكر: التحول في العقلية ضروري

لذا، لا يكفي أن نقول فقط إننا بحاجة إلى “إشراف بشري”. لجعله حقيقة واقعة، نحتاج إلى تحويل عقليتنا من مجرد “الإشراف على الذكاء الاصطناعي” إلى تصميم الذكاء الاصطناعي للتعاون بين الذكاء الاصطناعي والإنسان: إعادة تعريف دور الإنسان كمقيم نشط، وبناء الإشراف في تصميم الذكاء الاصطناعي، وتذكر الثلاثة “C” - التحكم، والقابلية للطعن، والكفاءة، - وبعد ذلك لن تكون فقط ممتثلاً للوائح مثل قانون الذكاء الاصطناعي - بل ستنشئ نظامًا أكثر جدارة بالثقة وقوة يعمل مع الناس.